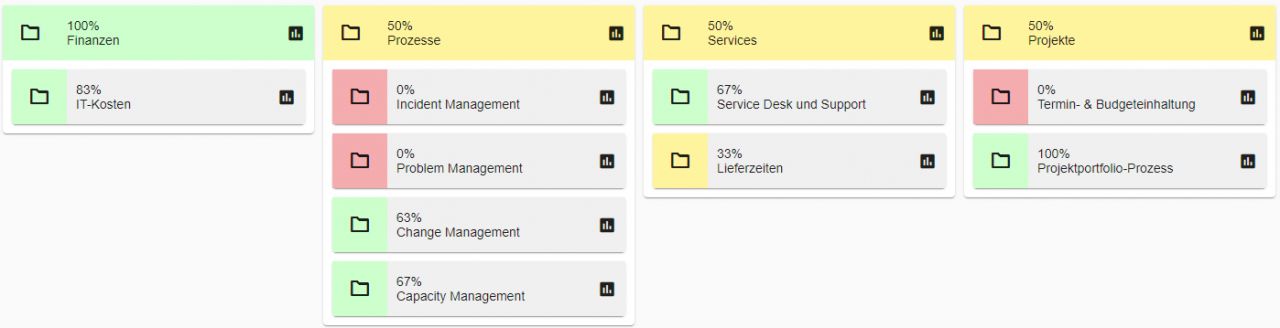

KPI OF THE MONTH

Seit der Gründung der axeba im Jahr 2002 haben wir 97 Unternehmen mit insgesamt gut 350 000 PC gebenchmarkt und über 300 000 Benutzer zu Ihrer Zufriedenheit befragt. Im KPI of the month stellen wir jeweils eine relevante Kennzahl vor.

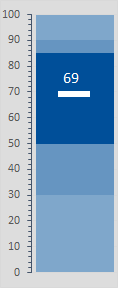

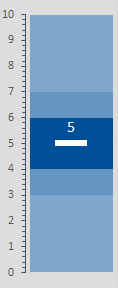

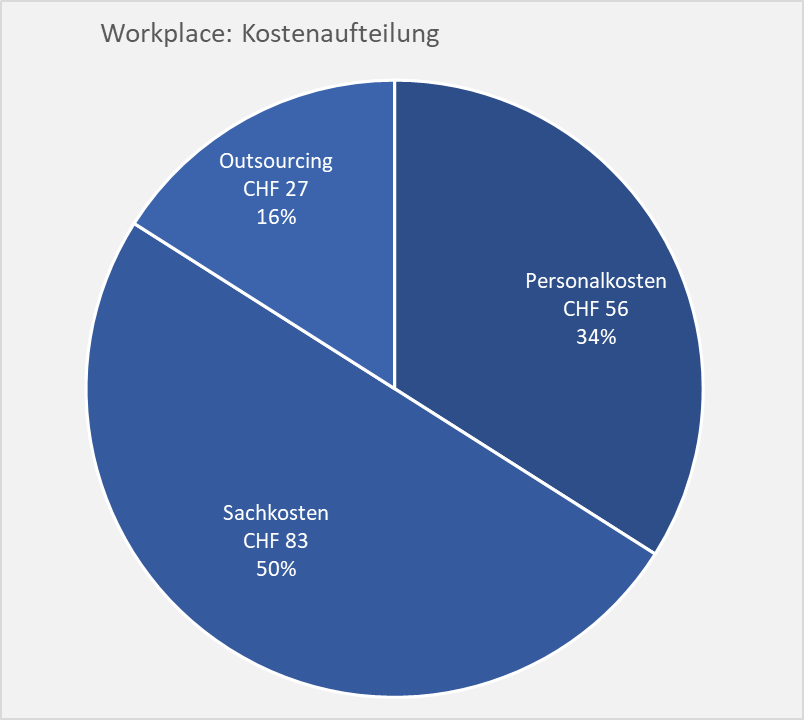

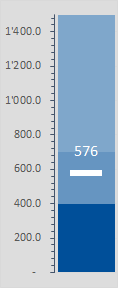

Die Sachkosten machen 50% der Workplacekosten aus

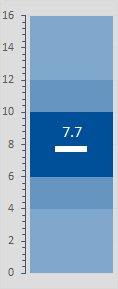

Workplacekosten nach Kostenarten

Im letzten KPI of the month haben wir gesehen, dass ein Workplace pro Benutzer CHF 166 im Monat kostet und wie sich diese Kosten auf die Gebiete Service Desk, Onsite Support, Endgeräte, Server, LAN, Telefonie & Collaboration, E-Mail und Client Software Management verteilen. Betrachtet man, wie hoch dabei die Personal- und Sachkosten sowie die Outsourcing-Kosten sind, ergibt sich das folgende Bild:

Aufteilung der Workplacekosten

Einige IT-Abteilungen haben einen Teil ihrer Leistungen an einen Outsourcing-Partner übergeben. Dies macht über alle untersuchten Firmen hinweg einen Anteil von 16% aus.

Den grössten Anteil haben die Sachkosten mit 50%. Dieser Kostenblock wird vor allem dominiert durch die Endgeräte, die komplett aus Sachkosten bestehen, sowie die Server und das LAN. Ebenfalls sehr sachkostenlastig ist das Gebiet Client Software Management, das durch die Microsoft-Lizenzen dominiert ist.

An zweiter Stelle folgen die Personalkosten, die einen Drittel der gesamten Workplacekosten ausmachen. Bei Sparprogrammen ist es wichtig, zu verstehen, dass beim Workplace die Personalkosten nur einen geringen Teil der Gesamtkosten ausmachen. Über die ganze Firma betrachtet machen die Personalkosten häufig 80% aus. Daher liegt in der Regel der grösste Hebel in diesem Bereich, wenn es darum geht, die Kosten zu senken.

Da beim Workplace jedoch die Sachkosten den grössten Teil ausmachen, lohnt es sich in der Regel, die Personalkosten nicht zu reduzieren, sondern die Engineers zu beauftragen, möglichst kostengünstige Lösungen zu entwickeln und betreiben und so die Sachkosten zu senken.

Über alle untersuchten Firmen hinweg betreut eine Person im Bereich Workplace durchschnittlich 191 User. Bei einem hohen Outsourcing-Anteil steigt diese Zahl natürlich und falls alle Leistungen selbst erbracht werden, sinkt diese Zahl geringfügig.

Fazit: In der Regel lohnt es sich, die internen Spezialistinnen und Spezialisten nicht zu reduzieren, sondern diese zu beauftragen, möglichst gute und kostengünstige Lösungen zu entwickeln und betreiben.

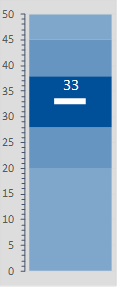

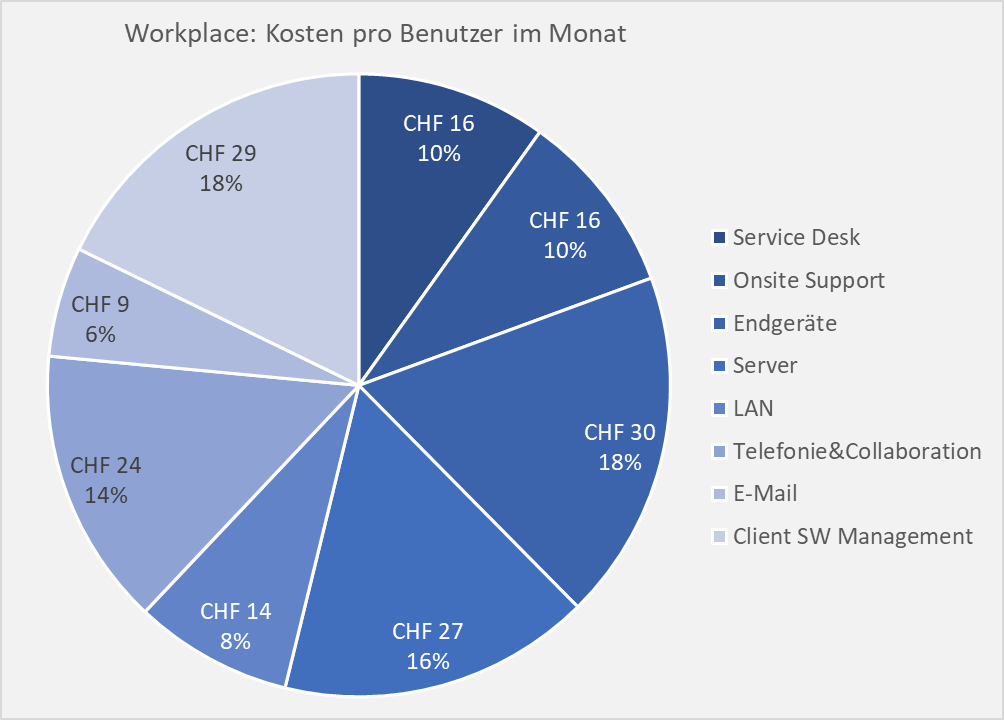

Der Support macht 20% der Workplacekosten aus

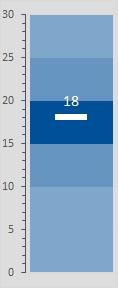

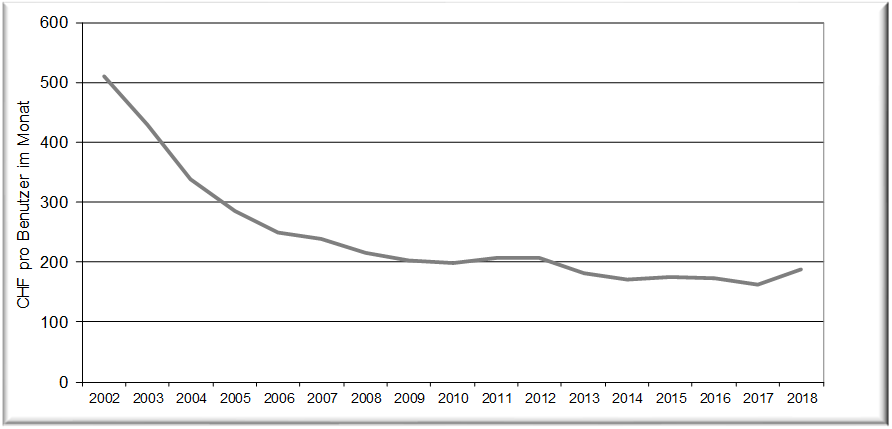

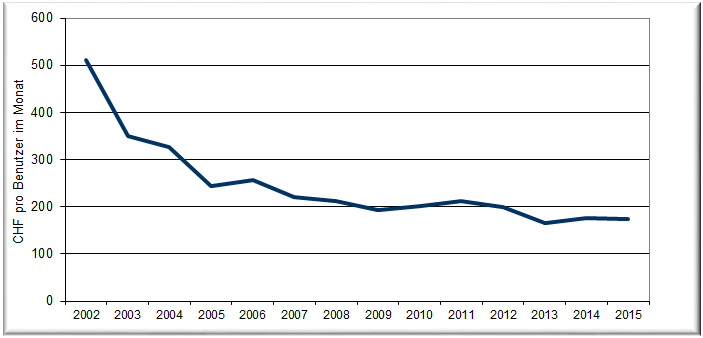

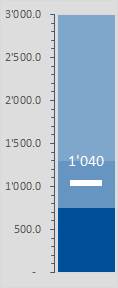

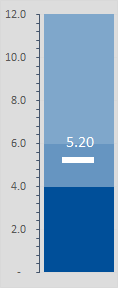

Workplacekosten pro Benutzer im Monat

Während der Workplace im Jahr 2002 noch rund CHF 500 pro Benutzer und Monat gekostet hat, sind diese Kosten bis im Jahr 2009 kontinuierlich auf CHF 200 gesunken. In den letzten 15 Jahren sind die Kosten weiter gesunken, aber nur noch marginal, so dass die Kosten pro Benutzer und Monat aktuell bei CHF 166 liegen.

In den Workplace-Kosten sind die folgenden Gebiete enthalten:

Workplace: Kosten pro Benutzer im Monat

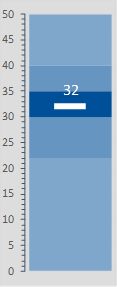

Die Supportkosten bestehend aus Service Desk und Onsite Support machen nur gerade 20% der gesamten Workplacekosten aus (total CHF 32 pro Benutzer im Monat). Weitere 18% resp. CHF 30 machen die Endgeräte wie Desktops, Notebooks, Monitore und Drucker als teuerstes Gebiet aus.

Das drittteuerste Gebiet ist mit CHF 27 die Workplace-Server. Hier sind einerseits die Fileserver enthalten (sofern noch vorhanden), aber auch die Infrastruktur-Server wie DNS, DHCP usw. Ebenfalls zu diesem Gebiet zählen die Citrix-Server (falls vorhanden). Nicht enthalten sind Applikations-Server.

Die LAN-Kosten machen mit nur gerade 8% nur einen kleinen Teil der Workplace-Kosten aus. Bewusst nicht enthalten in diesen Kosten sind die WAN-Verbindungen oder auch das LAN in den Rechenzentren.

Waren bis noch vor wenigen Jahren im Gebiet «Telefonie & Collaboration» die Festnetz-Telefoniekosten das dominierende Element, werden diese immer weniger relevant und durch die Collaboration-Lösungen (meist Teams) ergänzt oder mit der Zeit wohl auch ganz abgelöst.

Mit CHF 9 ist E-Mail das günstigste Gebiet. Hier geht die Entwicklung immer mehr von eigenen Exchange-Servern hin zu Office 365 (M365). Analog ist davon auszugehen, dass die Fileserver (siehe oben) mit der Zeit immer mehr durch SharePoint / OneDrive abgelöst werden.

Last but not least macht das Gebiet «Client Software Management» mit CHFF 29 den zweitteuersten Kostenblock aus. Die Kosten werden einerseits für die Aufwände der Software-Paketierung und -Verteilung, aber vor allem durch die Office-Lizenzen (M365) bestimmt. Konnten früher noch Office-Lizenzen gekauft und über mehrere Jahre genutzt (und abgeschrieben) werden, steigen diese Kosten mit M365 tendenziell wieder an und es ist davon auszugehen, dass wir hier in den kommenden Jahren noch einen weiteren Kostenanstieg sehen werden.

Fazit: Konnten die Workplace-Kosten in den vergangenen Jahren laufend gesenkt werden, dürfte das Kostenminimum wohl erreicht sein und es ist eher davon auszugehen, dass die Kosten wegen M365 wieder leicht steigen werden.

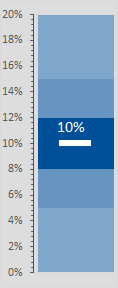

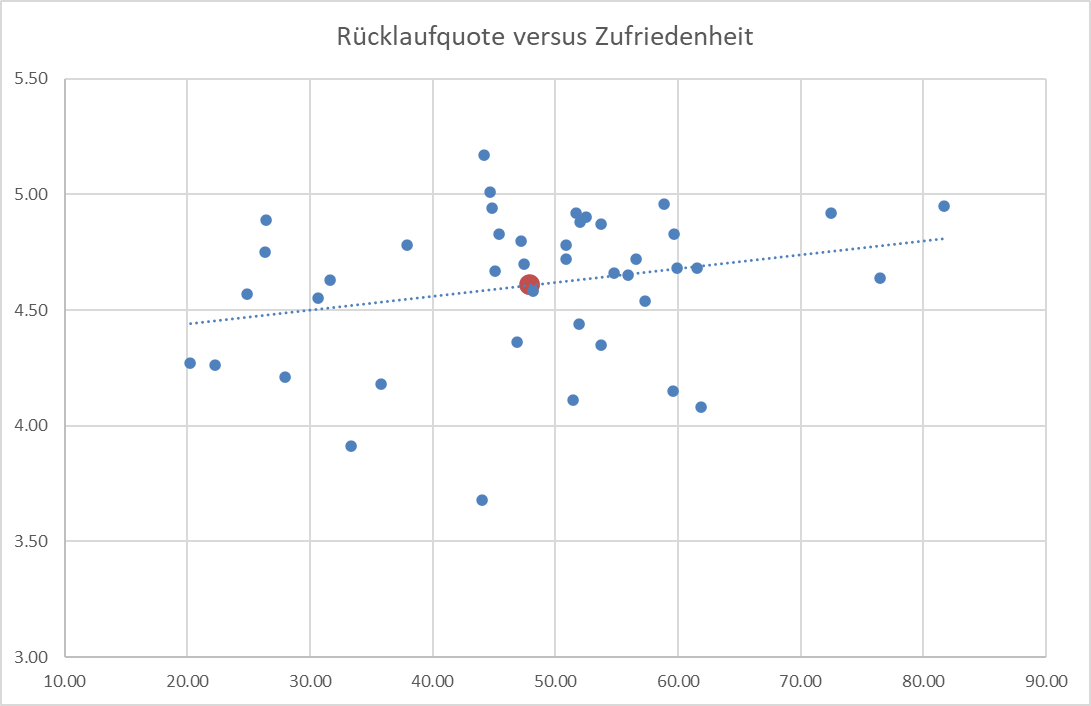

Eine hohe Rücklaufquote bedeutet nicht automatisch eine hohe Anwenderzufriedenheit

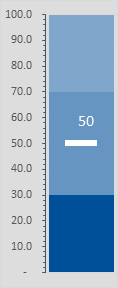

Korrelation zwischen Rücklaufquote und Anwenderzufriedenheit

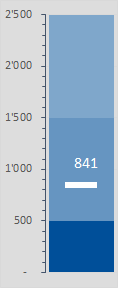

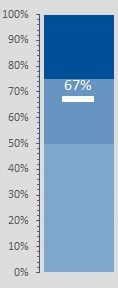

In vielen Projekten zur Erhebung der Benutzerzufriedenheit kommt die Frage auf, ob es nicht wichtig sei, eine möglichst hohe Beteiligung (Rücklaufquote) zu erzielen, um ein gutes Resultat zu erreichen. Wir haben deshalb in der untenstehenden Grafik die Zufriedenheit der Rücklaufquote gegenübergestellt:

Rücklaufquote versus Benutzerzufriedenheit

Der rote Punkt entspricht dem Datenbank-Durchschnitt mit einer Benutzerzufriedenheit von 4.61 (Schulnote) bei einer Rücklaufquote von 48%.

Die in der obigen Grafik dargestellte Trendlinie zeigt eine gewisse Korrelation zwischen der Rücklaufquote und der Benutzerzufriedenheit auf. Allerdings beträgt die Korrelation nur gerade 0.26 und wird damit als nicht sehr relevant eingestuft. Dies bedeutet, dass die beiden Werte eine gewisse Abhängigkeit aufweisen, diese aber nicht sehr gross ist.

So weist die IT mit der höchsten Zufriedenheit von 5.17 eine leicht unterdurchschnittliche Rücklaufquote auf und zwei IT-Abteilungen mit einer Rücklaufquote von rund 60% erreichen ein vergleichsweise tiefes Resultat von knapp über 4.

Ebenfalls ersichtlich in der obigen Grafik ist das enorme Spektrum der Rücklaufquoten: Die tiefste Quote liegt bei rund 20% und die höchste erreicht über 80%. Die Rücklaufquote hängt von verschiedenen Faktoren ab: Unter anderem von der Firmenkultur, der Qualität der Mailadressen (ungültige Mailadressen oder solche mit einem vollen Postfach senken die Rücklaufquote), der kommunizierten Massnahmen aus der letzten Umfrage, von Nachfassmails sowie der Qualität und dem Absender des Ankündigungsmails für die Umfrage.

Aber auch die Zufriedenheit schwankt stark: Von ungenügenden 3.68 bis zu exzellenten 5.17. Häufig (aber nicht immer) wird bei einer wiederholten Durchführung der Umfrage eine Steigerung der Zufriedenheit bemerkt.

Fazit: Es fällt auf, dass die Unternehmen mit einer hohen IT-Zufriedenheit in der Regel auch eine hohe Rücklaufquote erreichen. Die Korrelation ist jedoch verhältnismässig gering und eine hohe Rücklaufquote bedeutet noch lange keine hohe Zufriedenheit mit den IT-Leistungen.

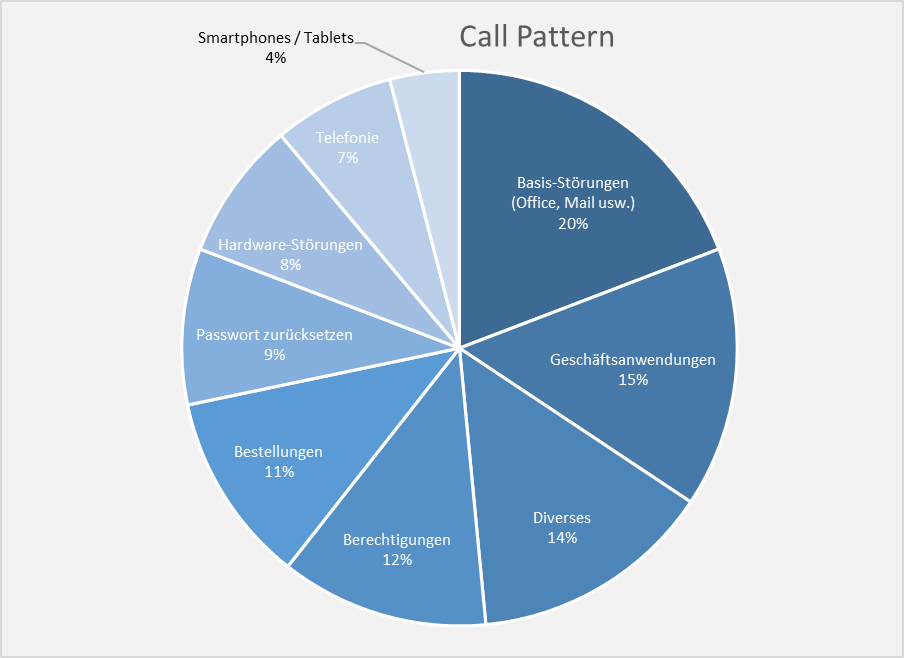

Automatisierungen im Service Desk für eine bessere Unterstützung der Geschäftsanwendungen

Optimierungsmöglichkeiten im Service Desk

Aus fast 100 gebenchmarkten Service Desks mit insgesamt über 350 000 Benutzern entsteht das folgende durchschnittliche Call Pattern (Verteilung der Anfragen auf die verschiedenen Themen):

Call Pattern im Service Desk

Selbstverständlich weichen die verschiedenen Firmen resp. Service Desks teilweise stark vom obigen Call Patter ab. Nichtsdestotrotz wollen wir die verschiedenen Kategorien etwas näher betrachten:

Basis-Störungen: Mit 20% sind die Frage und Probleme zu Office, Mail usw. die grösste Kategorie. Viele der Fragen können ohne oder mit nur wenig firmenspezifischem Wissen beantwortet werden und die Fragen könnten teilweise auch mit Google oder ChatGPT beantwortet werden.

Geschäftsanwendungen: An zweiter Stelle kommen mit 15% die Geschäftsanwendungen. Im Gegensatz zu den Basis-Störungen ist hier meistens viel Firmenwissen resp. Wissen zu den entsprechenden Applikationen gefragt. Häufig sind diese Fragen auch wesentlich aufwändiger zu lösen und bedingen ein entsprechendes Know-how im Service Desk.

Berechtigungen: Gleich nach den 14% Diverses folgen mit 12% die Berechtigungsthemen. Hier liesse sich vieles automatisieren, so dass diese Anfragen stark reduziert werden könnten. In der Regel sind solche Anfragen jedoch schnell beantwortet und eine Automatisierung entlastet das Service Desk weniger stark als angenommen werden könnte.

Bestellungen: Bestellungen werden in der Regel über einen Webshop abgewickelt und sind häufig entsprechend automatisiert. Wo noch kein Webshop zum Einsatz kommt, verfügt dieses Thema noch über entsprechendes Potenzial.

Passwort zurücksetzen: Auch hier besteht ein entsprechend hohes Automatisierungspotenzial. Noch ausgeprägter wie bei den Berechtigungen, sind Passwortrücksetzungen in der Regel aber entsprechend schnell erledigt und belasten das Service Desk weniger stark als allgemein angenommen wird.

Hardware-Störungen: In 8% aller Anfragen liegen Probleme mit der Hardware vor, die nur teilweise durch das Service Desk gelöst werden können. Häufig ist ein Vorort-Einsatz nötig und das Service Desk bildet nur die Schnittstelle zum Onsite Support.

Telefonie: 7% aller Anfragen betreffen die Telefonie. Dabei ist sowohl klassische VOIP-Telefonie als auch Telefonie über Kollaborations-Tools wie Teams usw. gemeint.

Smartphones / Tablets: Die Kategorie mit den wenigsten Anfragen (4%) betrifft die Smartphones und Tablets. Hier ist das Optimierungspotenzial auch dementsprechend gering.

Fazit: Die Kategorien Berechtigungen, Bestellungen und Passwort zurücksetzen können von der Natur her automatisiert werden. Zusammen macht dies 32% und damit rund ein Drittel aller Anfragen aus. Allerdings sind diese Kategorien in der Regel auch mit wenig Aufwand beantwortet resp. gelöst und damit fällt das Optimierungspotenzial geringer aus als auf den ersten Blick vermutet werden könnte.

Auf der anderen Seite des Spektrums stehen die Fragen zu den Geschäftsanwendungen. Diese machen im Schnitt nur 15% aller Anfragen aus, benötigen aber hohes Know-how und überdurchschnittlich viel Zeit zur Beantwortung resp. Lösung. Hier muss die Optimierung dahin gehen, dass das Service Desk möglichst viele dieser Anfragen selbst lösen kann, um die nachgelagerten Support- und Entwicklungsteams zu entlasten. Die Lösung im Service Desk kostet ein Bruchteil, als wenn das Problem im 2nd Level Support gelöst werden muss.

Am besten wird die Zeit, die durch Optimierungen frei wird, zur Behandlung von Geschäftsanwendungen eingesetzt. So profitieren alle davon: Die Anwender erhalten eine höhere Lösungsrate und damit eine schnellere Antwort, der Job der Service Desk Agenten wird anspruchsvoller und damit interessanter und die Applikationsteams werden von immer wiederkehrenden Anfragen entlastet.

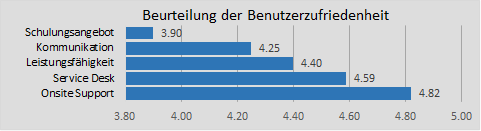

Wir hoch muss die Rücklaufquote sein bei Zufriedenheitserhebungen?

Schon geringe Rücklaufquoten ergeben statistisch belastbare Resultate

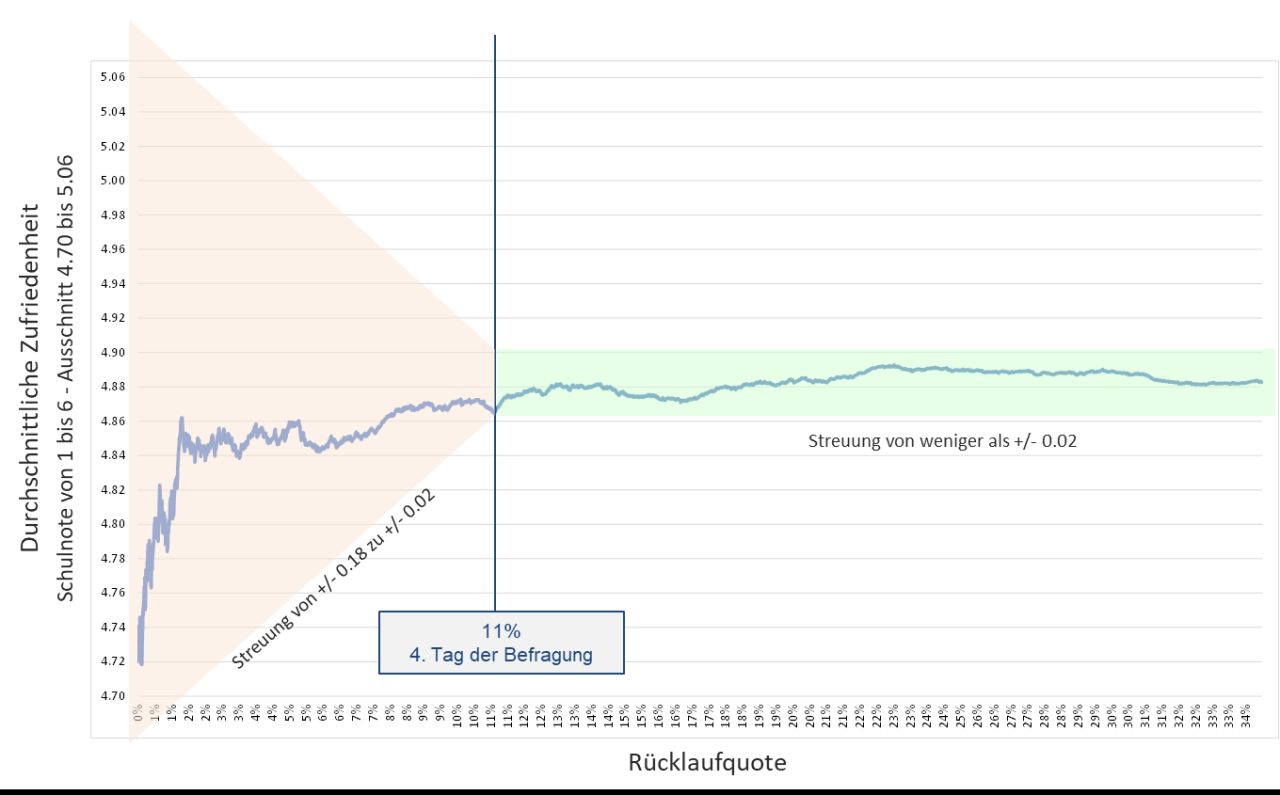

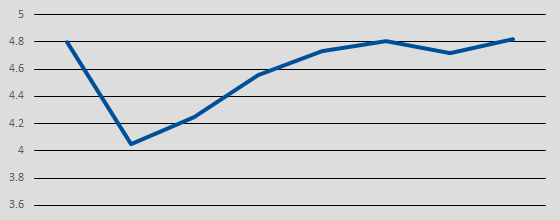

Viele Unternehmen denken, dass bei der Erhebung der Zufriedenheit mit den IT-Leistungen eine Rücklaufquote von möglichst über 50% nötig sei. Um zu zeigen, dass dies nicht so ist, haben wir bei einem grossen Kunden die Entwicklung der Bewertung analysiert:

Entwicklung der Bewertung über die Zeit resp. die eingegangenen Antworten

Für die Interpretation der obigen Ergebnisse ist es relevant zu wissen, dass nicht nur einige Hundert, sondern mehrere Tausend Anwenderinnen und Anwender befragt wurden. Nach knapp 3% aller eingegangenen Antworten stand das Resultat bereits mit einer verhältnismässig hohen Genauigkeit fest (4.84 resp. 4.85 versus dem Endresultat von 4.88). Am vierten Tag der Befragung war eine Rücklaufquote von 11% erreicht. Ab da schwankte das Resultat nur noch um +/- 0.02 Punkte. Veränderungen von 0.1 Punkten oder mehr, werden dabei von uns als signifikant eingeschätzt.

Die durchschnittliche Rücklaufquote all unserer Umfragen liegt bei 46%. Obwohl in der obigen Umfrage eine Rücklaufquote von nur gerade 34% erreicht wurde, ist die Anzahl der eingegangenen Antworten mehr als ausreichend und eine weitere Steigerung der Rücklaufquote hätte das Resultat in keiner Weise mehr verändert.

Häufig unterteilen wir die Resultate jedoch in sogenannte Erhebungskreise: Z.B. Abteilungen oder Berufsgruppen oder Personen, die mit einem Desktop oder einem Notebook arbeiten. Bei sehr kleinen Abteilungen oder Berufsgruppen kann die Rücklaufquote hingegen eine wichtige Rolle spielen, da hier je nachdem nur noch wenige Antworten eintreffen, die den entsprechenden Erhebungskreis betreffen. Die Erfahrung zeigt, dass bei weniger als 30 Antworten, die Aussagen zu stark von Einzelmeinungen beeinflusst werden und lieber 50 – 100 Antworten pro Erhebungskreis vorhanden sind.

In der obigen Auswertung steigert sich das Resultat über die Zeit deutlich von rund 4.72 auf den Endwert von 4.88. Häufig meinen unsere Kunden, dass zuerst die kritischen Personen antworten und erst danach die positiver gestimmten Mitarbeitenden. Dies scheint für die obige Grafik zutreffen. Je nach Kunde und Gebiet sehen wir jedoch auch das gegenteilige Bild, dass die Note zuerst höher ausfällt und dann auf den Endwert absinkt.

Damit sind allfällige Thesen, dass zuerst die negativ oder positiv eingestellten Mitarbeitenden antworten, hinfällig. Und auch wenn sie noch zutreffen würden, würde dies kaum verwertbare Hinweise geben. Man kann ja die Umfrage nicht einfach nach ein paar Antworten abbrechen, solange einem das Resultat noch gefällt…

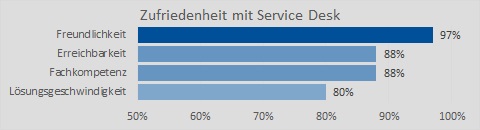

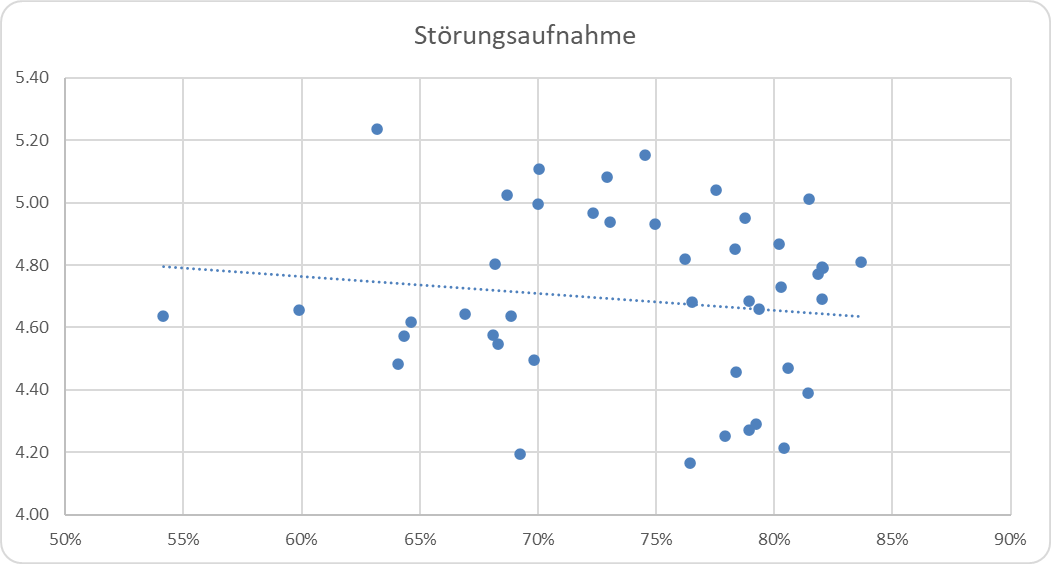

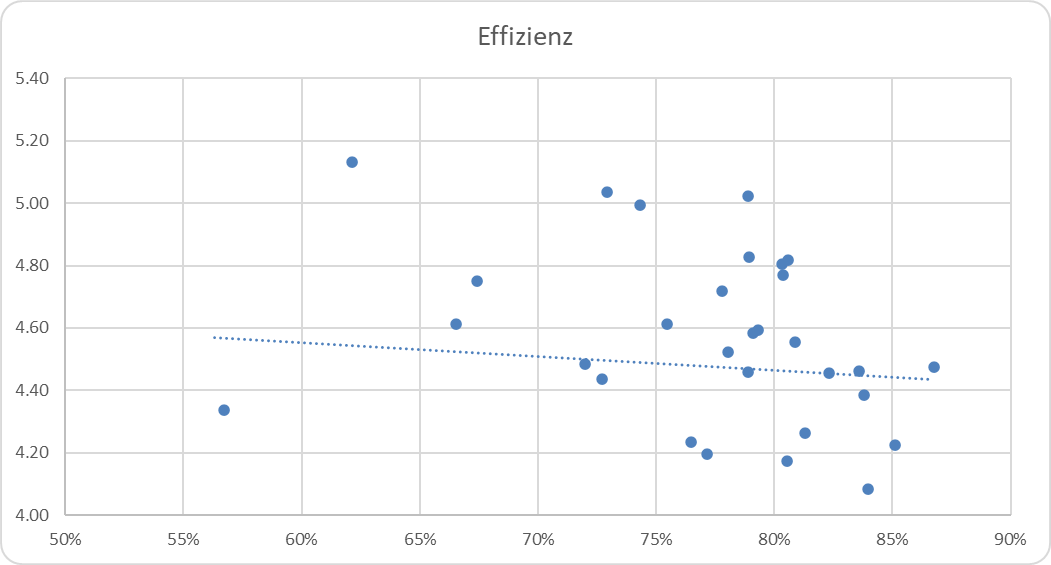

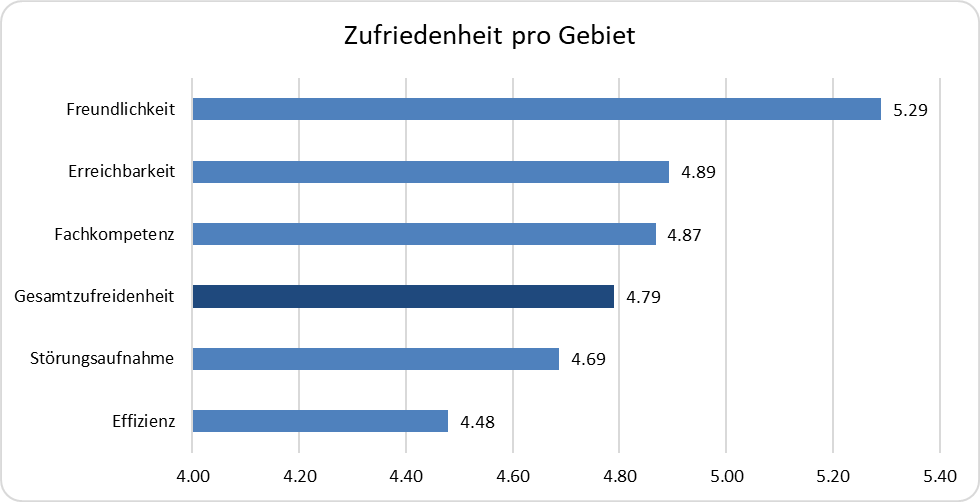

Die Effizienz wird beim Service Desk am schlechtesten beurteilt, hat aber die grösste Auswirkung

Die Effizienz ist auch im Service Desk am wichtigsten

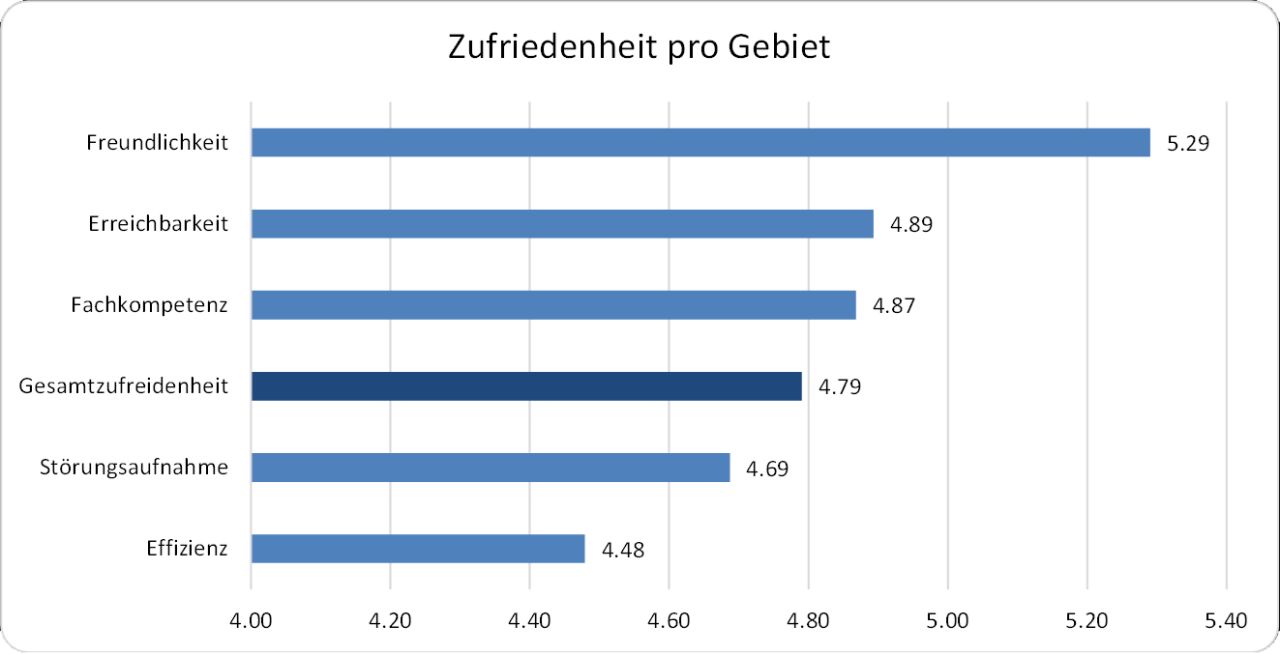

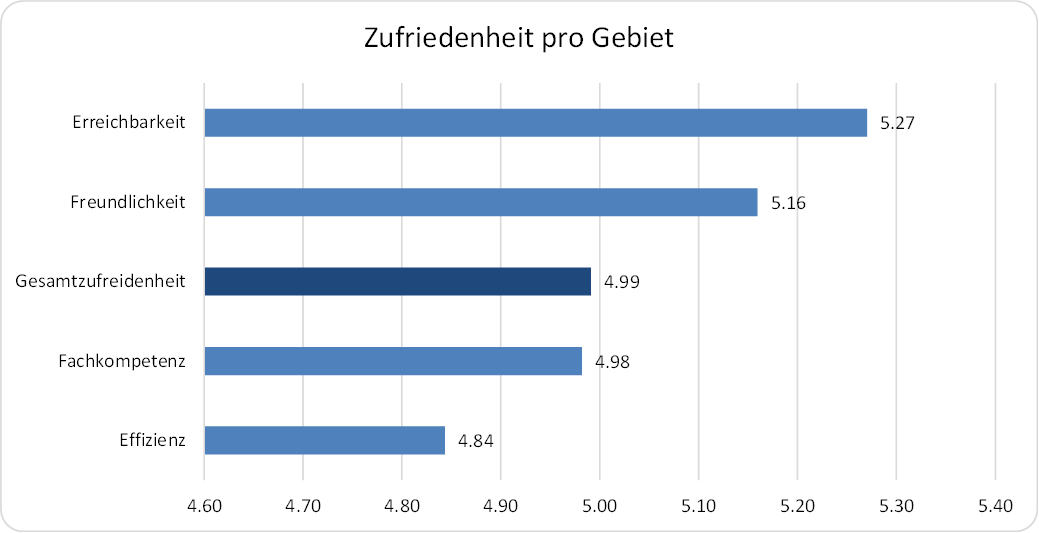

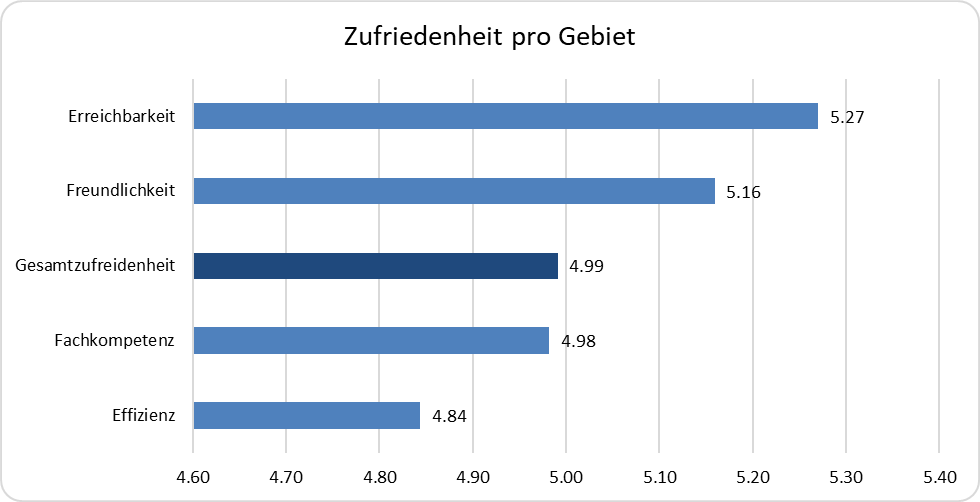

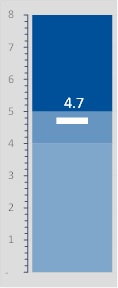

Im Service Desk wird die Freundlichkeit mit Abstand am besten beurteilt. Danach folgen die Erreichbarkeit und die Fachkompetenz:

Zufriedenheit pro Gebiet im Service Desk

Die Störungsaufnahme und vor allem die Effizienz werden hingegen schlechter als die Gesamtbeurteilung des Service Desk bewertet.

Nebst der Befragung der Gesamtzufriedenheit mit den Leistungen des Service Desks («Wie beurteilen Sie insgesamt die vom Servicedesk erbrachten Leistungen?») befragen wir üblicherweise ebenfalls die folgenden Teilgebiete des Service Desks:

- Freundlichkeit: Wie beurteilen Sie den Service Desk bezüglich der Freundlichkeit?

- Erreichbarkeit: Wie beurteilen Sie den Service Desk bezüglich der Erreichbarkeit?

- Fachkompetenz: Wie beurteilen Sie den Service Desk bezüglich der Fachkompetenz?

- Qualität der Störungsaufnahme: Wie beurteilen Sie den Service Desk bezüglich der Qualität der Störungsaufnahme (wird das Problem verstanden, bekomme ich Statusmeldungen, etc.)?

- Effizienz der Lösung: Wie beurteilen Sie den Service Desk bezüglich der Effizienz (Reaktionszeit, Lösungsgeschwindigkeit, etc.)?

Die Beurteilung erfolgt in Worten und wird in Schulnoten umgerechnet (sehr schlecht = 1 | schlecht = 2 | ungenügend = 3 | genügend = 4 | gut = 5 | sehr gut = 6)

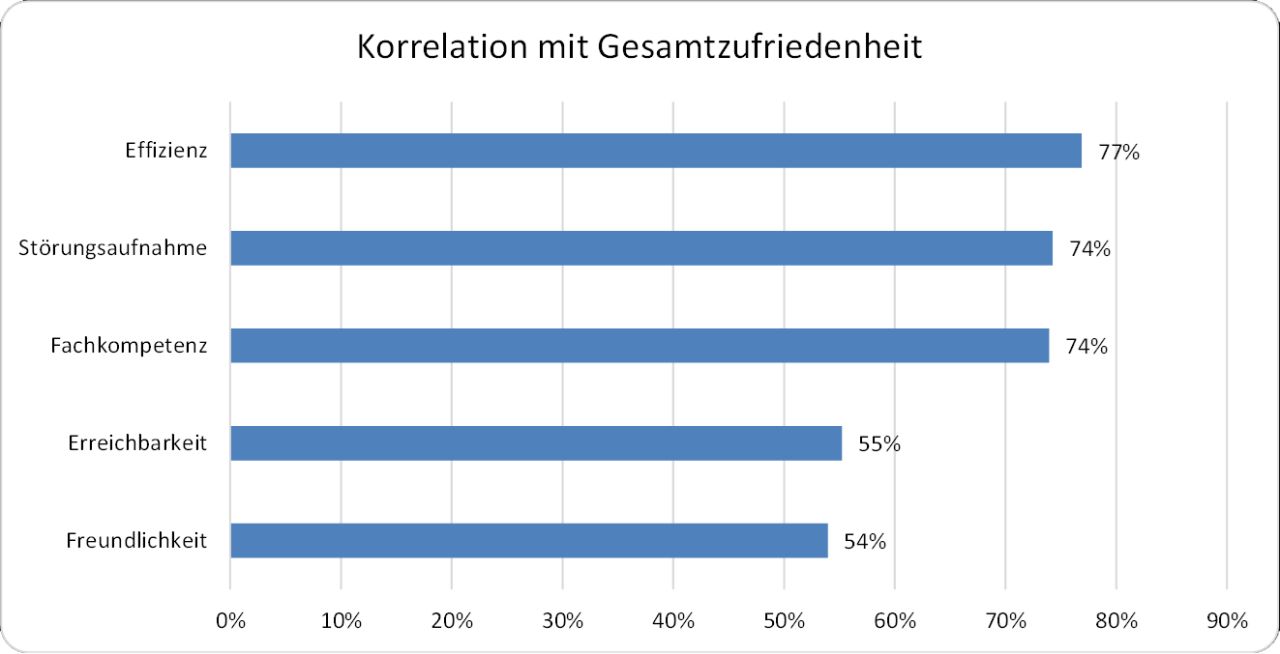

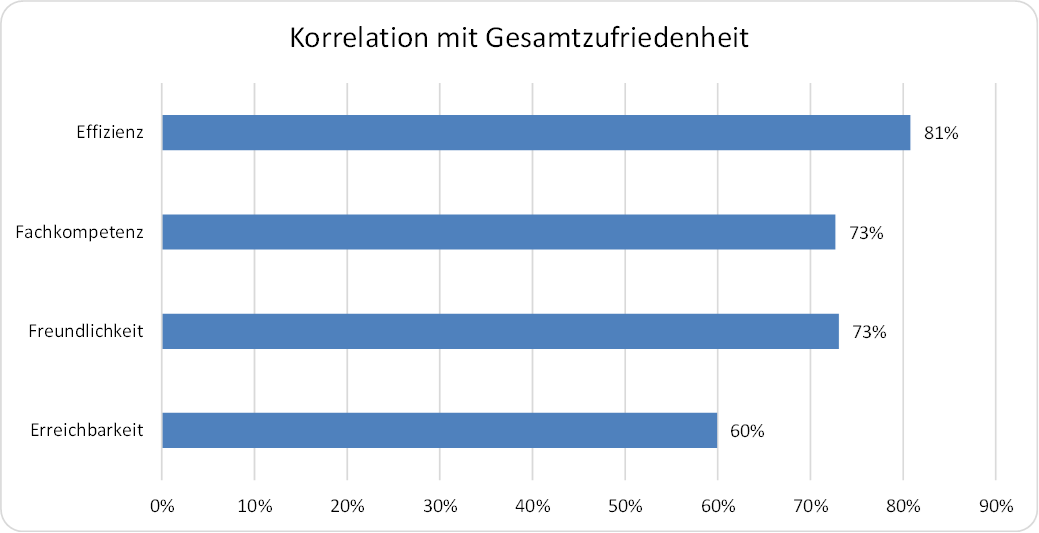

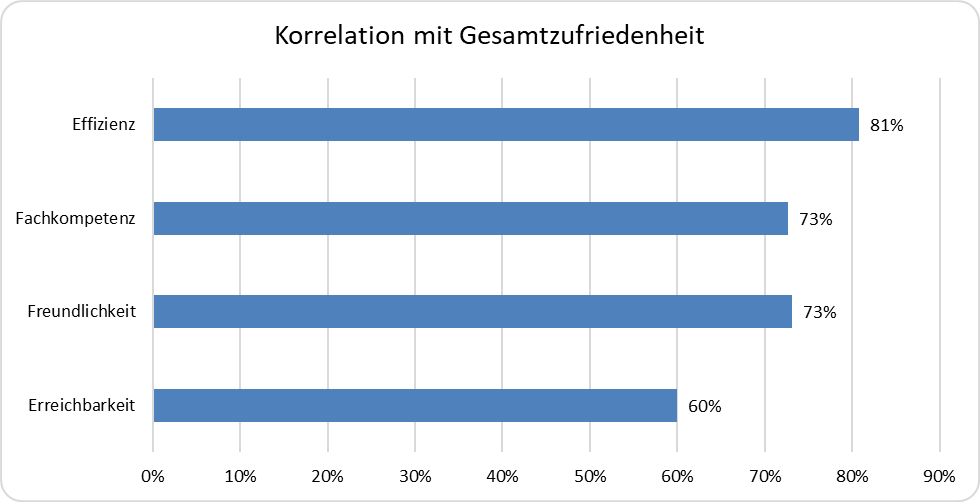

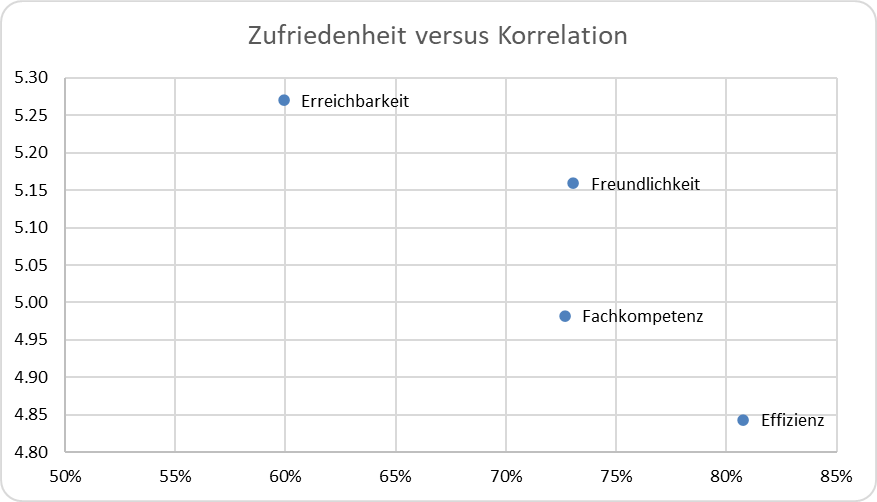

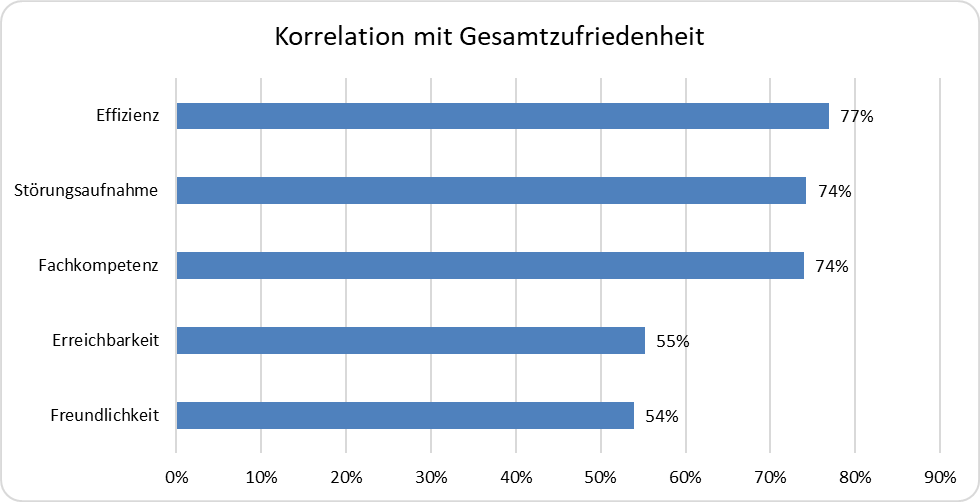

Wenn wir die Korrelation der obigen Teilgebiete mit der Gesamtzufriedenheit mit dem Service Desk betrachten, ergibt sich das folgende Bild:

Korrelation der Gebiete mit der Gesamtzufriedenheit im Service Desk

Interessanterweise weisen genau die am schlechtesten bewerteten Gebiete Effizienz und Störungsaufnahme die höchste Korrelation mit der Gesamtzufriedenheit auf. Und die am besten bewerteten Gebiete Freundlichkeit und Erreichbarkeit weisen die geringste Korrelation auf.

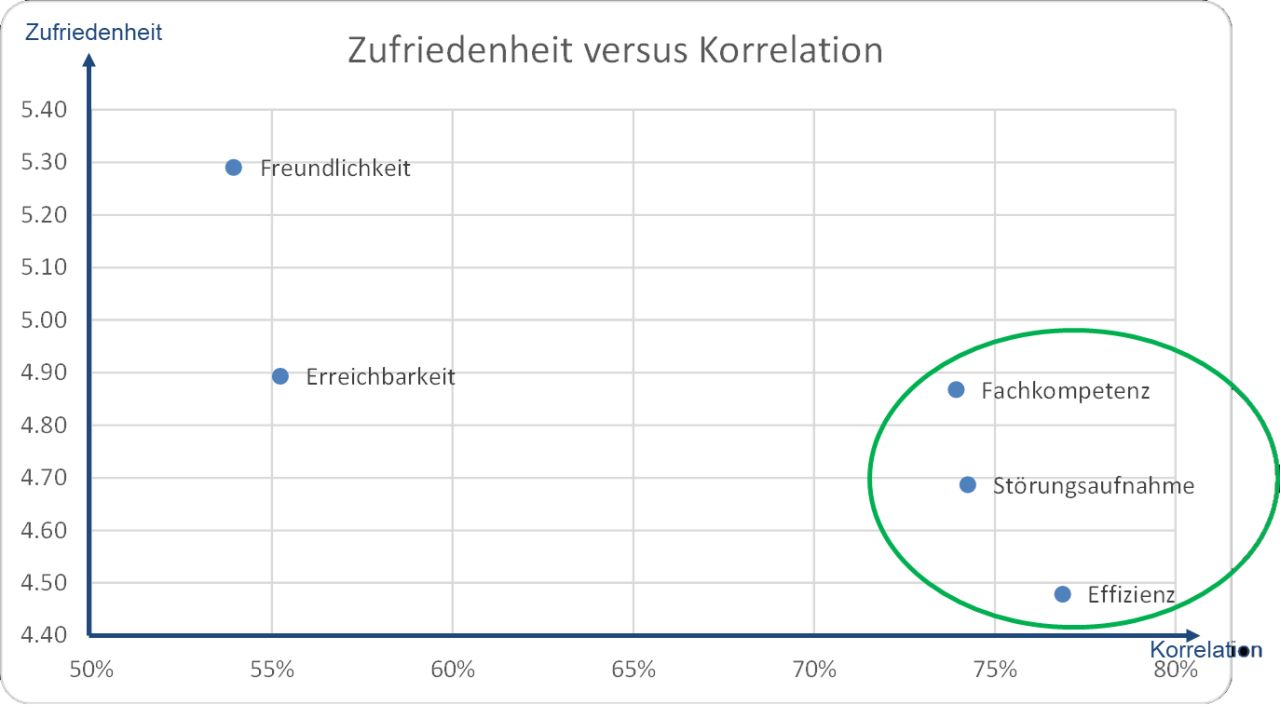

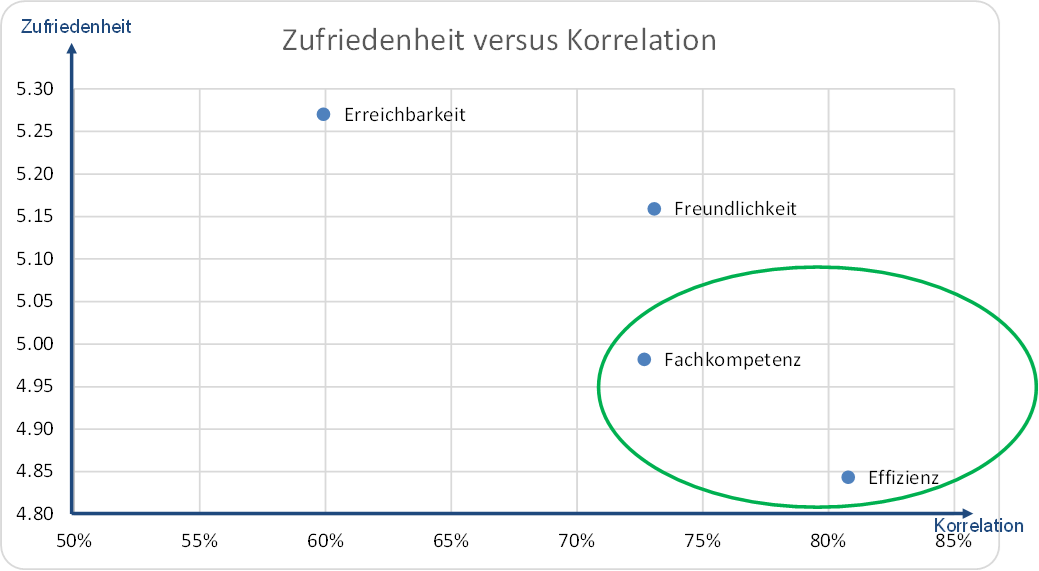

Wenn wir die Zufriedenheit der Korrelation gegenüberstellen, dann ergibt sich folgendes Bild:

Zufriedenheit versus Korrelation der Gebiete im Service Desk

Die Freundlichkeit erreicht zwar mit Abstand die beste Beurteilung, weist allerdings auch die geringste Korrelation mit der Gesamtzufriedenheit im Service Desk auf. Damit lohnt es sich nicht, noch mehr in die Freundlichkeit der Service Desk Agenten zu investieren.

Ähnlich verhält es sich mit der Erreichbarkeit, wenn auch etwas weniger ausgeprägt wie bei der Freundlichkeit.

Auf der anderen Seite wird die Effizienz (Reaktionszeit, Lösungsgeschwindigkeit) am schlechtesten beurteilt, weist dafür aber die grösste Korrelation auf. D.h. hier lohnt es sich am Meisten, zu investieren.

Die Fachkompetenz sowie die Störungsaufnahme weisen praktisch die gleiche Korrelation mit der Gesamtzufriedenheit auf. Da die Störungsaufnahme jedoch schlechter beurteilt wird wie die Fachkompetenz, lohnt es sich mehr, in die Störungsaufnahme zu investieren als die Fachkompetenz noch weiter zu steigern.

Fazit

Eine weitere Steigerung der Freundlichkeit und Erreichbarkeit wirkt sich nur wenig auf der Steigerung der Gesamtzufriedenheit mit dem Service Desk aus.

Viel mehr lohnt es sich, die Effizienz (Reaktionszeit, Lösungsgeschwindigkeit) sowie die Qualität der Störungsaufnahme (wird das Problem verstanden, bekomme ich Statusmeldungen, etc.) zu optimieren, da diese Parameter einen deutlich grösseren Einfluss auf die Gesamtzufriedenheit haben.

Dies kann wie folgt zusammen gefasst werden: Die Anwender wollen eine schnelle und effiziente Lösung ihrer gemeldeten Probleme durch kompetente Service Desk Mitarbeitende.

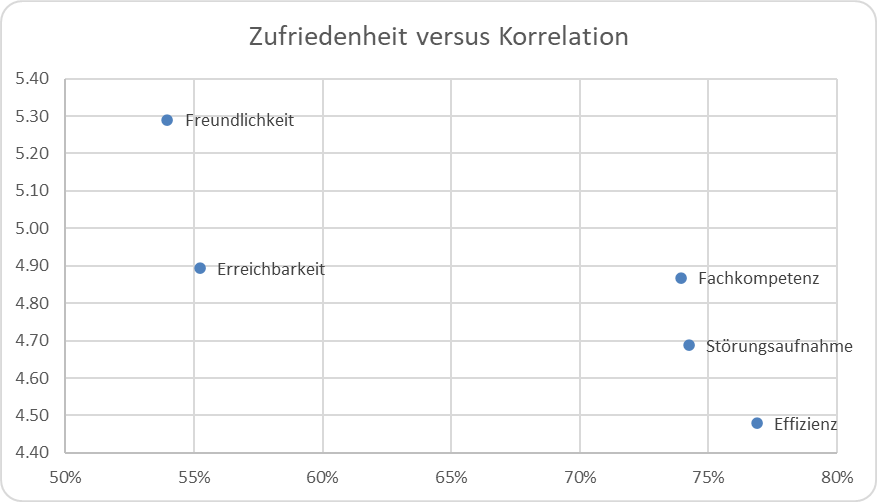

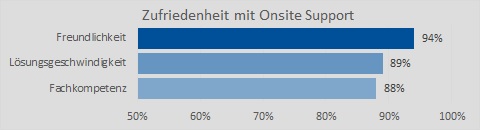

Die Effizienz ist im Vor-Ort-Support am wichtigsten

Die Effizienz wird beim Vor-Ort-Support am schlechtesten beurteilt, hat aber die grösste Auswirkung

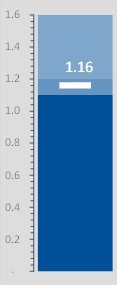

Im Vor-Ort-Support werden die Erreichbarkeit sowie die Freundlichkeit mit Abstand am besten beurteilt:

Zufriedenheit pro Gebiet im Vor-Ort-Support

Nebst der Befragung der Gesamtzufriedenheit mit den Leistungen des Onsite Supports («Wie beurteilen Sie insgesamt die vom Vor-Ort-Support erbrachten Leistungen?») befragen wir üblicherweise ebenfalls die folgenden Teilgebiete des Onsite Supports:

- Erreichbarkeit: Wie beurteilen Sie den Vor-Ort-Support bezüglich der Erreichbarkeit?

- Freundlichkeit: Wie beurteilen Sie den Vor-Ort-Support bezüglich der Freundlichkeit?

- Fachkompetenz: Wie beurteilen Sie den Vor-Ort-Support bezüglich der Fachkompetenz?

- Effizienz der Lösung: Wie beurteilen Sie den Vor-Ort-Support bezüglich der Effizienz (Reaktionszeit, Lösungsgeschwindigkeit, ...)?

Die Beurteilung erfolgt in Worten und wird in Schulnoten umgerechnet (sehr schlecht = 1 | schlecht = 2 | ungenügend = 3 | genügend = 4 | gut = 5 | sehr gut = 6)

Wenn wir die Korrelation der obigen Teilgebiete mit der Gesamtzufriedenheit mit dem Vor-Ort-Support betrachten, ergibt sich das folgende Bild:

Korrelation der Gebiete mit der Gesamtzufriedenheit im Vor-Ort-Support

Interessanterweise weisen genau die am schlechtesten bewerteten Gebiete (Effizienz und Fachkompetenz) die höchste Korrelation mit der Gesamtzufriedenheit auf. Und die am besten bewerteten Gebiete (Freundlichkeit und Erreichbarkeit) weisen die geringste Korrelation auf.

Wenn wir die Zufriedenheit der Korrelation gegenüberstellen, dann ergibt sich folgendes Bild:

Zufriedenheit versus Korrelation der Gebiete im Vor-Ort-Support

Die Erreichbarkeit erreicht zwar die beste Beurteilung, weist allerdings auch die geringste Korrelation mit der Gesamtzufriedenheit im Onsite Support auf.

Auf der anderen Seite wird die Effizienz (Reaktionszeit, Lösungsgeschwindigkeit) am schlechtesten beurteilt, weist dafür aber die grösste Korrelation auf.

Die Fachkompetenz sowie die Freundlichkeit weisen praktisch die gleiche Korrelation mit der Gesamtzufriedenheit auf. Da die Fachkompetenz jedoch schlechter beurteilt wird wie die Freundlichkeit, lohnt es sich mehr, in die Fachkompetenz zu investieren als die Freundlichkeit noch weiter zu steigern.

Fazit

Am meisten lohnt es sich, die Effizienz (Reaktionszeit, Lösungsgeschwindigkeit) und die Fachkompetenz zu verbessern, um die Zufriedenheit im Vor-Ort-Support zu steigern.

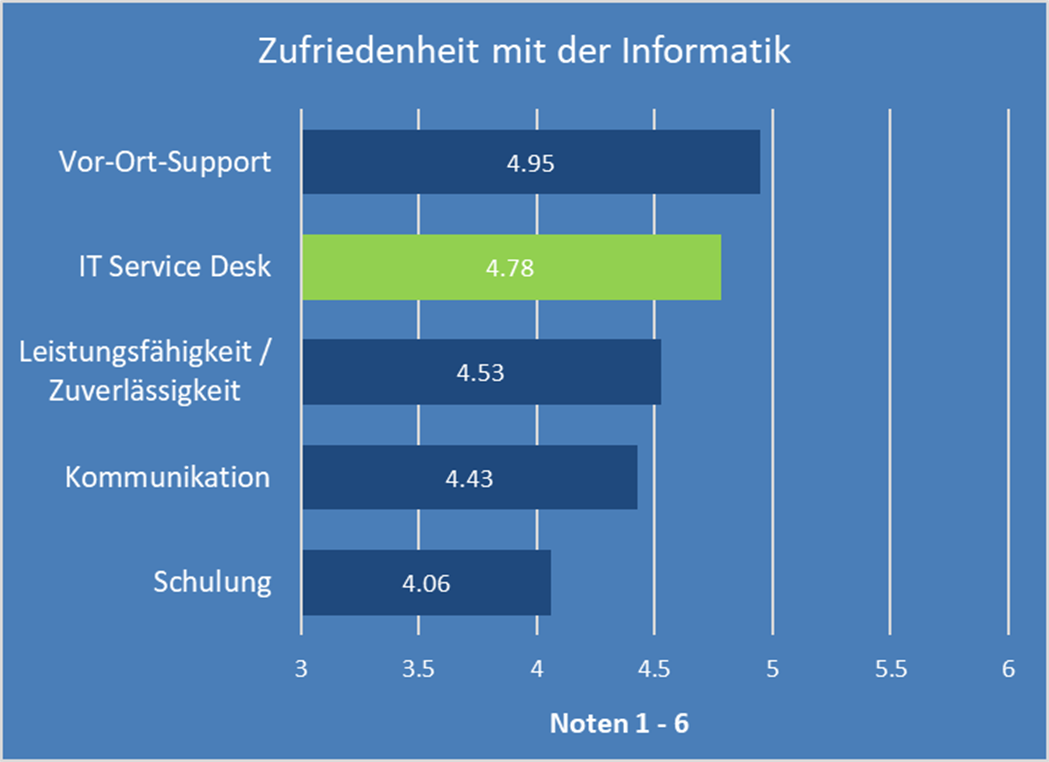

Am zufriedensten sind die User mit dem Vor-Ort-Support

Von allen Gebieten wird der Vor-Ort-Support am besten beurteilt

Standardmässig befragen wir bei unserer Erhebung der Anwenderzufriedenheit die folgenden Gebiete:

Vor-Ort-Support: Support vor Ort, bei dem ein Supporter am Arbeitsplatz der Anwenderinnen und Anwender vorbeikommt, um das Problem zu lösen (in der Regel Installation/Deinstallation/Austausch von Endgeräten).

IT Service Desk: Dem IT-Service Desk können Probleme und Störungen per Telefon, Mail, Intranet, Chat usw. gemeldet werden. Das Service Desk löst soviele Anfragen wie möglich und leitet die übrigen Probleme an nachgelagerte Supportstellen weiter.

Leistungsfähigkeit / Zuverlässigkeit: Performance (Geschwindigkeit) und Verfügbarkeit der IT-Systeme.

Kommunikation: Kommunikationsleistung der IT mit Fragen wie «Wie erfahren Sie von Neuerungen und Änderungen an den Informatik-Systemen?» oder «Wie beurteilen Sie die Häufigkeit und Umfang der Informationen aus der Informatik?».

Schulung: Beurteilung des Schulungsangebotes (nicht der Schulungen selbst): «Wie gut deckt das Angebot an internen Computerschulungen grundsätzlich Ihre Bedürfnisse ab?»

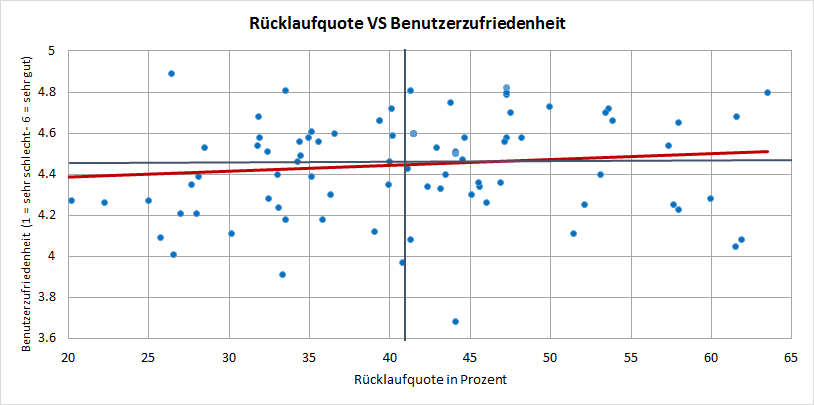

Über alle durchgeführten Umfragen ergeben sich die folgenden Beurteilungen pro Gebiet:

Durchschnittliche Anwenderzufriedenheit pro Gebiet

Bei den meisten Befragungen entspricht die Reihenfolge bezüglich der Zufriedenheit dem obigen Bild. Der Grund dürfte darin liegen, dass die Zufriedenheit umso grösser ist, je persönlicher der Kontakt ausfällt. Die Leute im Vor-Ort-Support kennt man häufig persönlich und tauscht sich mit diesen hin und wieder aus. Die Personen im Service Desk kennt man teilweise mit Namen (wenn man sich häufig an den Service Desk wendet), aber nicht persönlich vom Sehen.

Zudem helfen der Vor-Ort-Support sowie der Service Desk bei konkreten Problemen, was in der Regel positiv wahrgenommen wird. Dies dürfte ein weiterer Grund sein, wieso die Gebiete ohne persönlichen Kontakt wie Leistungsfähigkeit/Zuverlässigkeit, Kommunikation und Schulung tendenziell schlechter beurteilt werden.

Fazit

Der persönliche Kontakt zu den Anwenderinnen und Anwendern lohnt sich und wird mit einer höheren Zufriedenheit belohnt. Gebiete mit wenig oder keinem persönlichem Kontakt werden in der Regel schlechter beurteilt und es braucht hier umso intensivere Anstrengungen, um eine hohe Zufriedenheit zu erreichen. Dass dies aber auch in diesen Gebieten möglich ist, zeigt das Beispiel einer Firma, bei der das Schulungsangebot mit 4.94 bewertet wird und damit das Niveau der durchschnittlichen Beurteilung des Vor-Ort-Supports (4.95) erreicht.

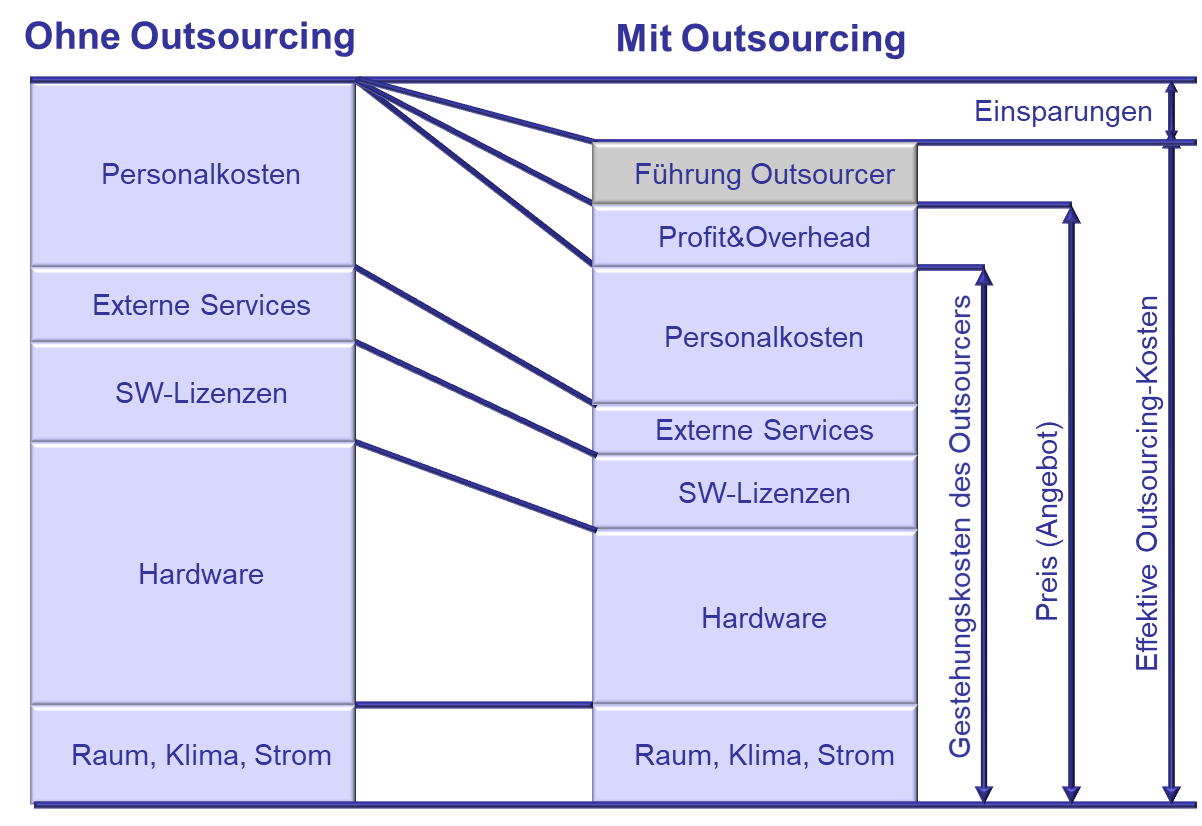

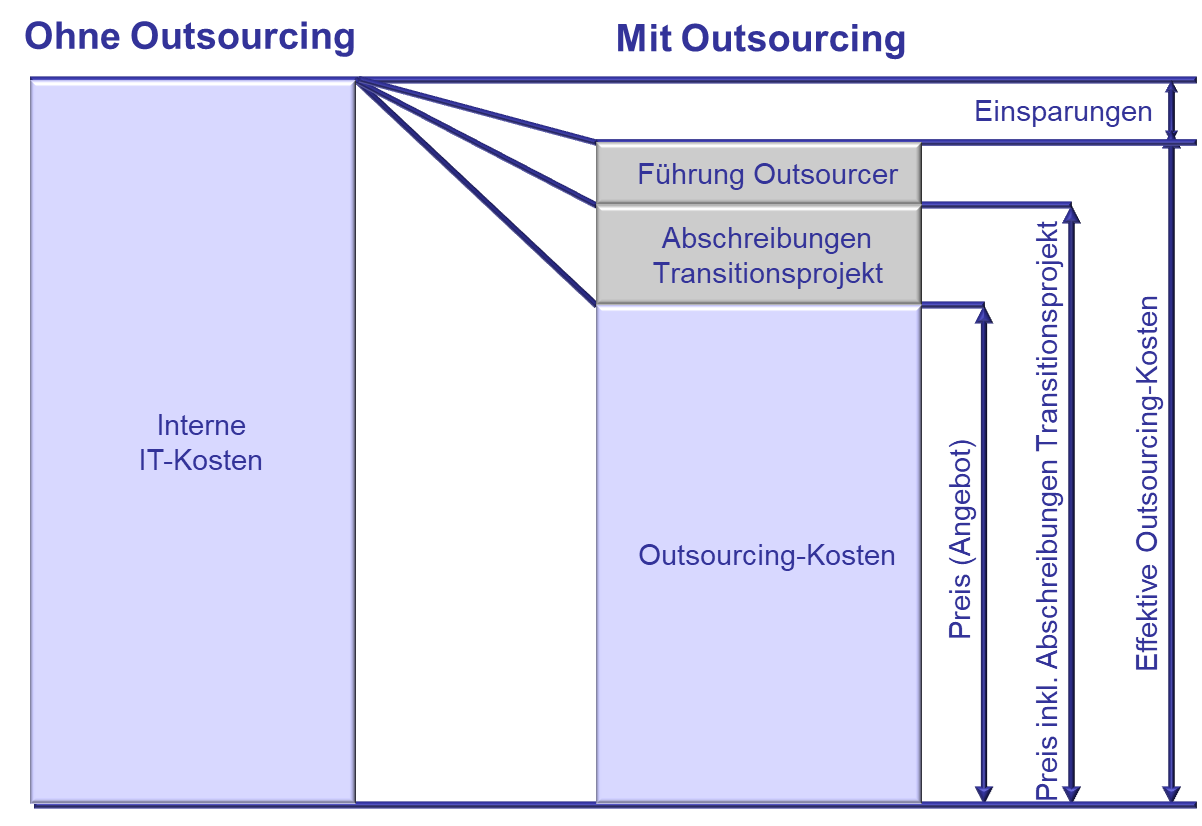

Ist Outsourcing besser als Insourcing?

Bei einem Out- oder In-Sourcing sinkt die Anwenderzufriedenheit zuerst einmal

Vor längerer Zeit hat uns eine Firma mit dem Outsourcing eines Teils ihrer IT beauftragt. Dazu hat auch der Service Desk gehört, der eine sehr gute Leistung erbracht hat. Wegen der hohen Zufriedenheit mit dem Service Desk haben wir die Anwenderzufriedenheit in das SLA mit dem Provider als bonusrelevantes Ziel aufgenommen:

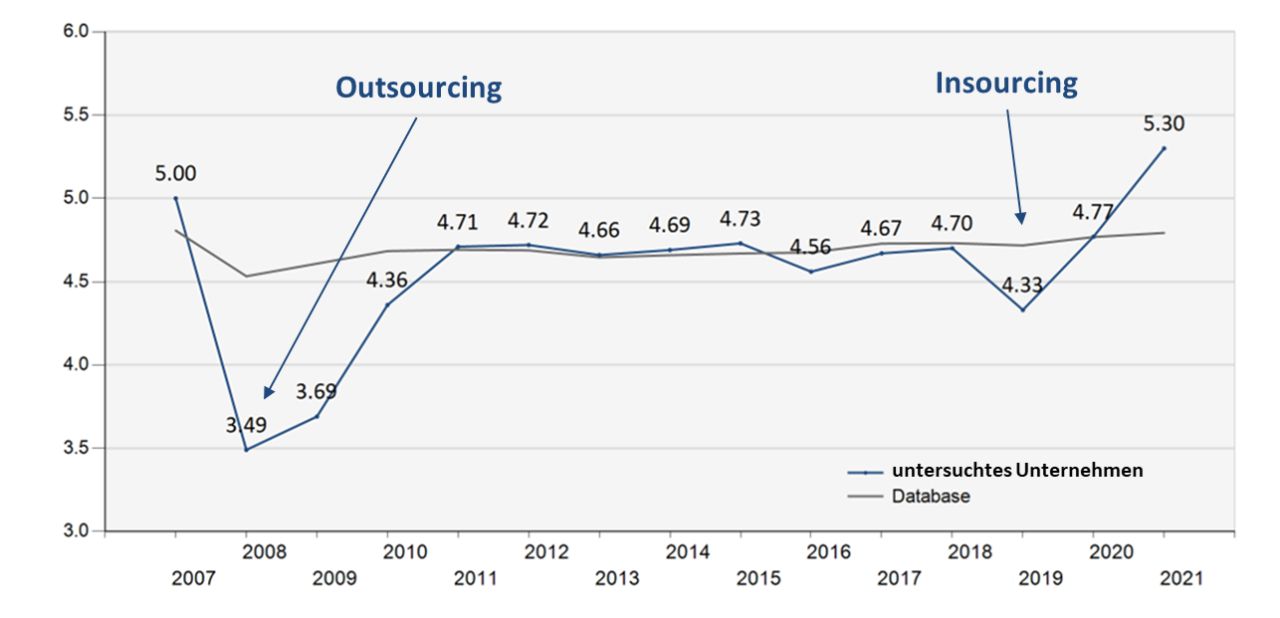

Anwenderzufriedenheit mit dem Service Desk

Erwartungsgemäss ist die sehr hohe Zufriedenheit gleich nach dem Outsourcing gesunken: Die Prozesse waren neu und noch nicht eingespielt und alle Erfahrungen, die das bisherige Service Desk über Jahr aufgebaut hatte, musste der Provider zuerst auch wieder machen. Im zweiten Jahr des Outsourcings konnte der Provider die Zufriedenheit leicht und im dritten Jahr deutlich steigern. Im vierten Jahr fand nochmals eine Steigerung auf das Niveau des Datenbankdurchschnitts von axeba statt.

Die kommenden Jahre stagnierte die Zufriedenheit auf der Höhe des Datenbankdurchschnitts, erreichte den guten Wert vor dem Outsourcing jedoch nicht mehr.

Im Jahr 2019 hat die Firma beschlossen, das Outsourcing zu beenden und die Leistungen des Service Desks wieder selbst zu erbringen. Daraufhin ist die Zufriedenheit erwartungsgemäss gesunken, da das neu aufgebaute interne Service Desk sich zuerst wieder organisieren und optimieren musste. Im Jahr darauf stieg die Beurteilung jedoch auf den Wert des Datenbankdurchschnitts und ein weiteres Jahr später wurde die hohe Zufriedenheit vor dem Outsourcing nicht nur erreicht, sondern deutlich übertroffen.

Fazit:

- Jede signifikante Veränderung wie ein Out- oder Insourcing wirkt sich im ersten Moment negativ auf die Anwenderzufriedenheit aus

- Auch wenn ein Outsourcing nicht zu schlechteren Leistungen führen muss (wie in diesem Beispiel), so ist es doch sehr anspruchsvoll, gute Leistungen durch ein Outsourcing noch zu übertreffen

- Waren die Leistungen jedoch vor dem Outsourcing schlecht, so hat der Outsourcer gute Chancen, die Prozesse zu optimieren und damit die Zufriedenheit zu steigern.

- Der Zeitraum für signifikante Verbesserungen wird nicht in Wochen oder Monaten, sondern in Jahren gemessen.

An welche Stellen wenden sich die Anwenderinnen und Anwender bei Fragen und Problemen?

53% aller Anwenderinnen und Anwender lösen ihre Fragen und Probleme in ihrem Umfeld und werden damit nie zu einem Supportfall

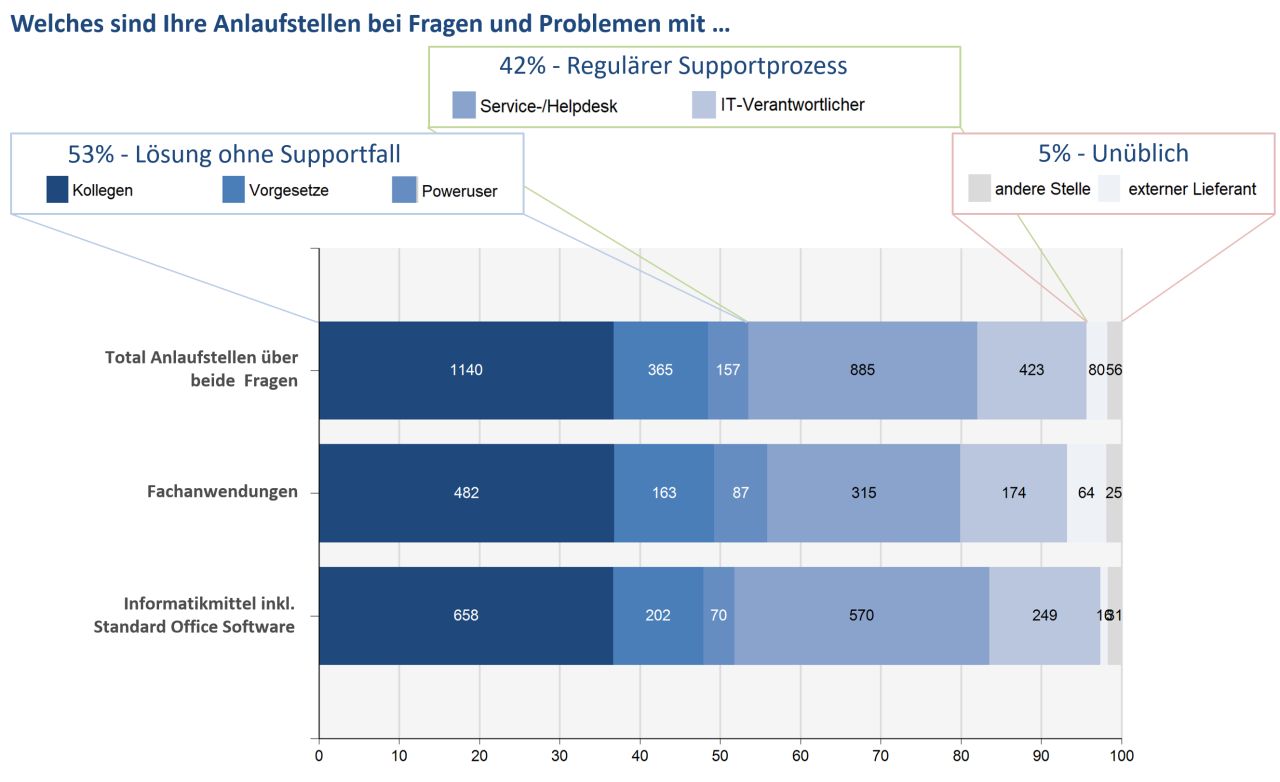

Eine unsere Standardfragen bei der Erhebung der Anwenderzufriedenheit ist «Welches sind Ihre Anlaufstellen bei Fragen und Problemen mit …». Dabei wird bei den Antwortmöglichkeiten unterschieden zwischen Fachanwendungen und dem PC-Arbeitsplatz (Informatikmittel inkl. Standard Office Software).

Die Auswahlmöglichkeiten gliedern sich in die folgenden Gruppen:

Lösungen ohne Supportfall: Dazu zählt die Lösung durch Kolleginnen und Kollegen, durch Vorgesetzte oder durch Poweruser (Superuser). Insgesamt geben 53% der befragten Personen an, dass sie sich für die Lösung von IT-Probleme an ihre Kollegen/Vorgesetzte/Poweruser und nicht an die IT wenden. Das heisst, diese Fragen und Probleme werden gar nie zu einem Supportfall.

Regulärer Supportprozess: 42% aller Anwenderinnen und Anwender nutzen den regulären Supportprozess, indem sie sich an den Service- resp. Helpdesk oder direkt an eine oder einen IT-Verantwortlichen wenden. Für Themen rund um den PC-Arbeitsplatz wenden sich die Hilfesuchenden dabei deutlich mehr an den Service- resp. Helpdesk als bei Fachanwendungen. Dies ist einfach erklärbar, da das Service Desk häufig weniger kompetent ist im Bereich der Fachwendungen als beim PC-Arbeitsplatz.

Unüblich: Insgesamt 5% wenden sich an andere Stellen resp. direkt an externe Lieferanten. Dies ist bei Fachanwendungen stärker ausgeprägt als beim PC-Arbeitsplatz:

Anlaufstellen bezüglich Fragen und Probleme mit den Fachanwendungen und dem PC-Arbeitsplatz

Fazit:

- Nur knapp die Hälfte aller befragten Personen wenden sich an die IT. Die andere Hälfte kontaktieren ihre Kolleginnen und Kollegen, ihre Vorgesetzte oder die zuständigen Poweruser.

- Nicht alle Anwenderinnen und Anwender, die sich an die IT wenden, kontaktieren den Service Desk. Ein signifikanter Anteil kontaktiert direkt Personen in der IT oder wendet sich direkt an externe Lieferanten (bei Fachanwendungen).

- Es wenden sich mehr Personen bei Problemen und Fragen mit dem PC-Arbeitsplatz an den Service Desk als bei Fachanwendungen.

Lösen Chatbots bald die Service Desk Agenten ab?

Gewünschte und effektiv genutzte Eingangskanäle beim Service Desk

Chatbots sind in aller Munde und kommen immer mehr zum Einsatz. Das eine oder andere Service Desk hat sich auch bereits überlegt, Chatbots einzusetzen. In der Praxis treffen wir Chatbots jedoch bis anhin kaum an bei internen Service Desks.

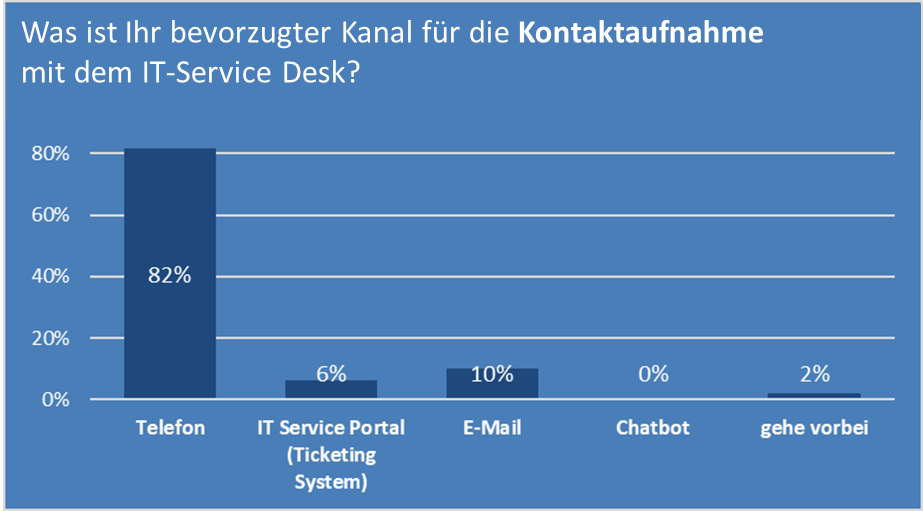

Bei der Erhebung der Anwenderzufriedenheit fragen wir in der Regel, welches der bevorzugte Kanal für die Kontaktaufnahme mit dem Service Desk ist:

Bevorzugter Kanal für die Kontaktaufnahme mit dem IT-Service Desk

82% aller befragt Personen wenden sich nach wie vor am liebsten per Telefon an das Service Desk. An zweiter Stelle kommt weit abgeschlagen mit 10% aller Nennungen E-Mail und mit 6% folgt das IT Service Portal. Eine Kontaktaufnahme per Chatbot wünscht (so gut wie) niemand und eine kleine Minderheit von 2% geht am liebsten persönlich beim Service Desk vorbei.

Chatbots scheinen eine Idee der Anbieter zu sein und nicht der Kunden, die sich an das Service Desk wenden. Allerdings muss bei dieser Aussage berücksichtigt werden, dass kaum ein internes Service Desk eine Kontaktmöglichkeit per Chatbot anbietet und damit dieser Kanal auch kaum bekannt ist.

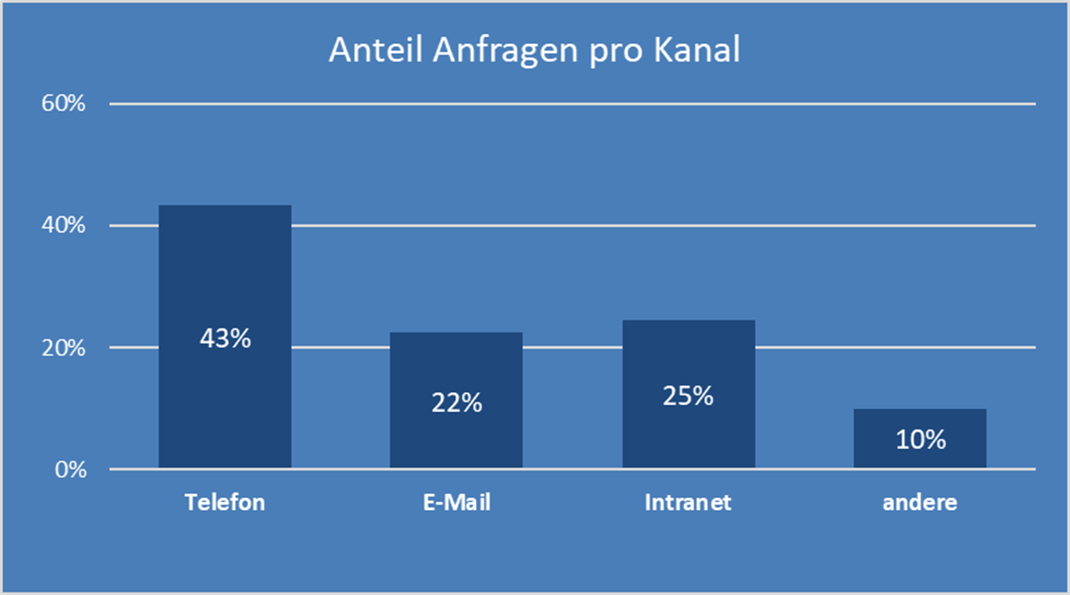

In den Benchmarks messen wir jeweils, wie viele Anfragen über welchen Kanal an das Service Desk gerichtet werden:

Anteil der Anfragen an das Service Desk pro Kanal

Interessanterweise wünschen zwar 82% der befragten Personen, das Service Desk telefonisch zu kontaktieren, in der Praxis gelangen jedoch nur 43% aller Anfragen per Telefon an das Service Desk. Je rund ein Viertel aller Anfragen gelangen über das Intranet (Service Portal) und E-Mail an das Service Desk. Dies liegt teilweise daran, dass einige Service Desks gar keinen Telefon-Kanal anbieten oder diesen nur rudimentär betreiben und die Anfragen elektronisch und nicht telefonisch forcieren wollen.

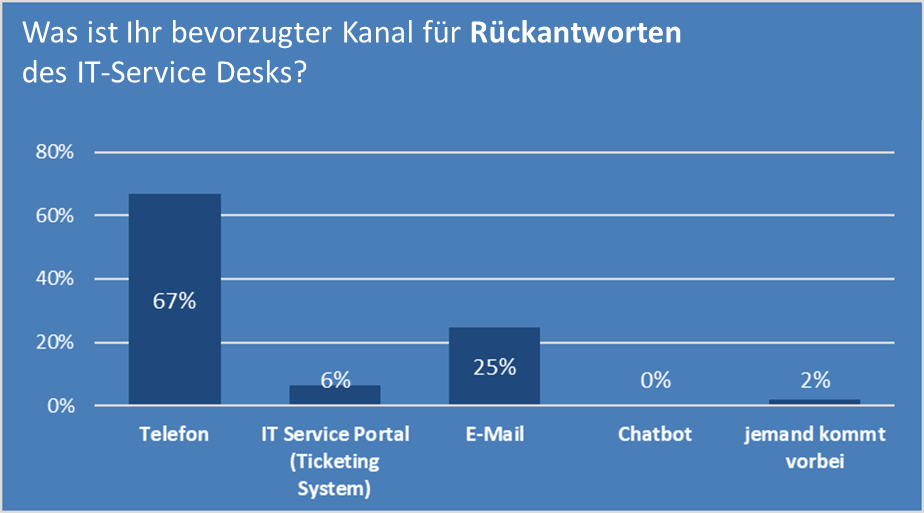

Auf die Frage, welches der bevorzugte Kanal für Rückantworten des IT-Service Desks ist, bevorzugen etwas weniger, aber immer noch viele Personen das Telefon:

Bevorzugter Kanal für Rückantworten des Service Desks

Das Telefon ist auch hier der beliebteste Kanal und ein persönliches Gespräch wird in zwei Dritteln der Fälle bevorzugt. Dahinter folgt E-Mail mit 25% aller Nennungen.

Fazit: Chatbots sind bis jetzt bei den (internen) IT-Service Desks kaum verbreitet und von den Anwenderinnen und Anwendern auch nicht gewünscht. Obwohl 82% aller befragten Personen angeben, das Service Desk am liebsten telefonisch zu kontaktieren, gehen in der Praxis nur 43% aller Anfragen auch per Telefon ein. Dies liegt zu einem Teil auch daran, dass einige Service Desks gar keine Möglichkeit bieten, um telefonisch mit ihnen in Kontakt zu treten. Dies ist in unseren Augen eine gewagte Strategie, da die Entscheidung den Anwenderinnen und Anwendern überlassen werden sollte, wie sie mit dem Service Desk interagieren wollen.

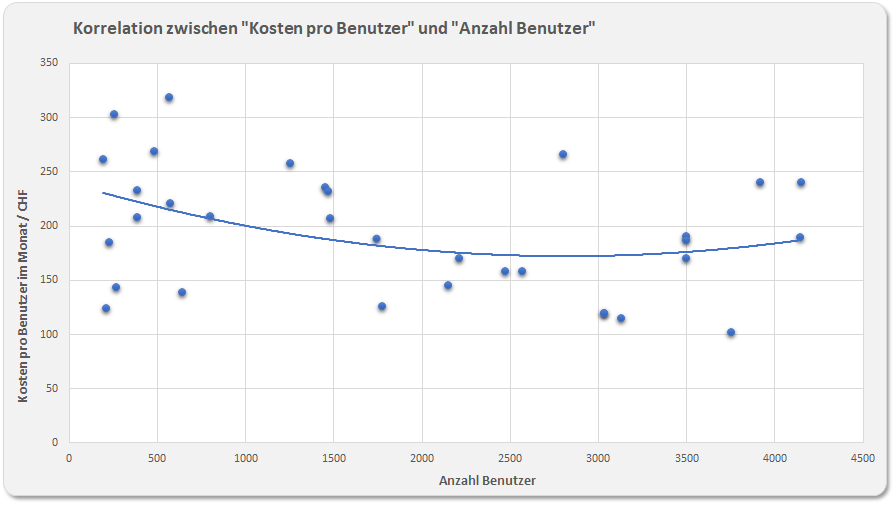

Was nichts kostet, ist nichts wert

Korrelation der Anwenderzufriedenheit mit den Workplacekosten

«Was nichts kostet, ist nichts wert». Dieses Zitat stammt von Albert Einstein und ist in vielen Köpfen. Ein gutes Auto kostet Geld. Und gutes Essen in der Regel ebenfalls. Gute Hotels sind teuer und schöne Möbel ebenfalls.

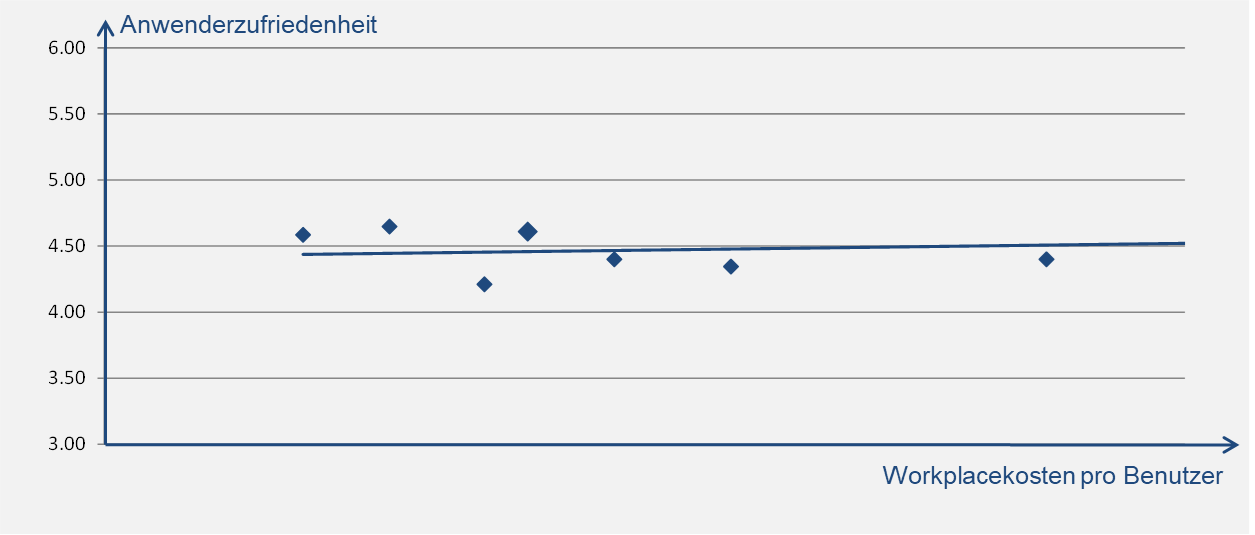

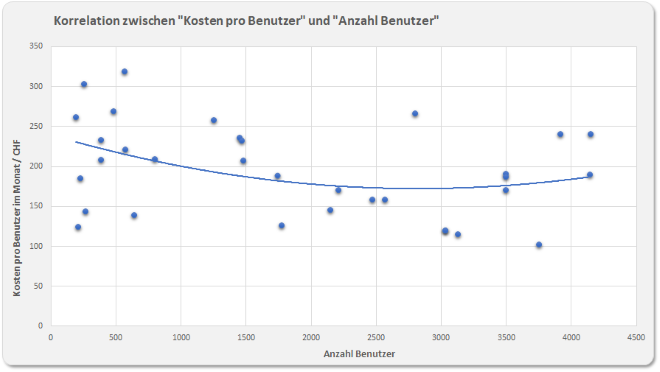

Aber ist das in der IT auch so? Ist eine gute IT teurer als eine schlechte? Wenn wir mit «gut» die Anwenderzufriedenheit meinen, dann können wir dies mit Daten belegen. Wir haben bei knapp 100 Firmen die Kosten für den Workplace in Benchmarks erhoben und bei 45 Firmen die Anwenderzufriedenheit gemessen. Bei einigen Firmen durften wir sowohl den Workplace benchmarken als auch die Anwenderzufriedenheit messen. Diese (zugegebenermassen wenigen) Daten schauen wir in diesem KPI of the month genauer an.

Um es vorwegzunehmen: Wir finden keine Korrelation zwischen der Anwenderzufriedenheit und den erhobenen Workplacekosten bei den Firmen und Verwaltungen, bei denen wir beides erheben durften:

Anwenderzufriedenheit versus Workplacekosten pro Benutzer

Die auf der y-Achse aufgetragene Anwenderzufriedenheit hat keinen Zusammenhang mit den auf der x-Achse aufgetragenen Workplacekosten pro Benutzer. Das heisst, dass Firmen mit hohen Workplacekosten nicht eine höhere Anwenderzufriedenheit aufweisen resp. dass ein günstiger Workplace nicht auf Kosten der Anwenderzufriedenheit geht.

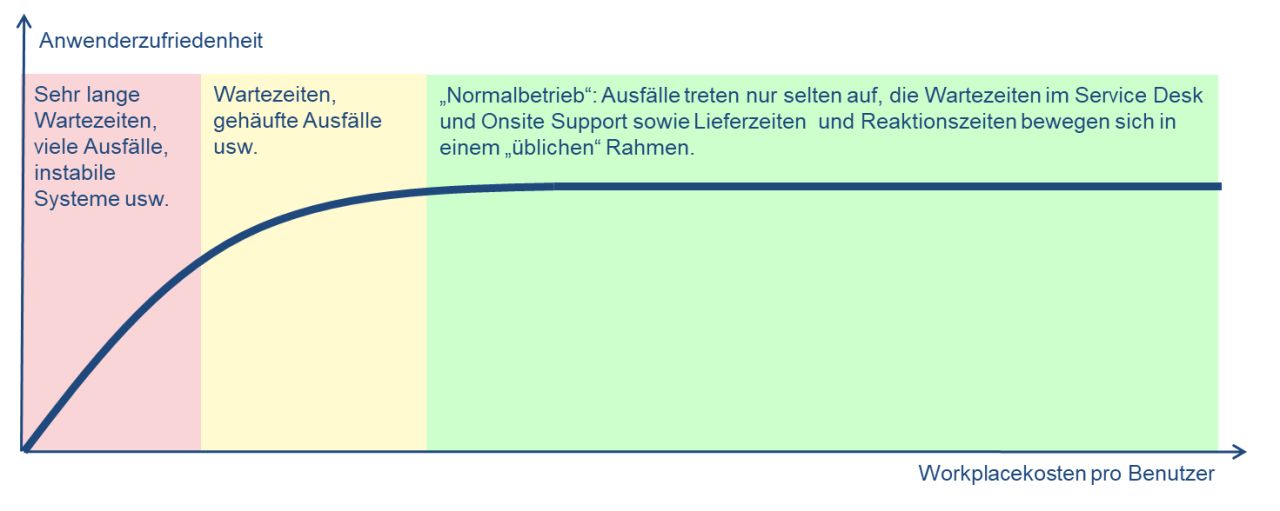

Die Kosten lassen sich jedoch kaum beliebig reduzieren, ohne dass dies Auswirkungen auf die Anwenderzufriedenheit hat. Werden die Kosten so weit gesenkt, dass sich die Ausfälle häufen und die Performance zusammenbricht, wird dies sehr wohl Auswirkungen auf die Zufriedenheit haben. Die untenstehende Grafik zeigt auf, was die Folgen sein dürften, falls die Kosten immer weiter gesenkt werden (linker Teil der Grafik):

Mutmassliche Entwicklung der Zufriedenheit, falls die Workplacekosten unter ein kritisches Mass hinaus reduziert werden (linker Teil der Grafik)

Werden die personellen Ressourcen so weit reduziert, dass man den Service Desk kaum noch erreicht und der Onsite Support Wochen benötigt, um Störungen zu beheben oder neue Geräte auszuliefern, wird auch die Anwenderzufriedenheit entsprechend sinken.

Und ab einem gewissen Punkt wird nicht nur die Zufriedenheit sinken, sondern die Anwender werden sich selbst helfen, indem sie selbständig PC und Software beschaffen oder externe Firmen beauftragen und damit eine Schatten-IT aufbauen. Die zentrale IT wird so zwar günstiger, aber die gesamten IT-Kosten steigen an, da die Kosten der Schatten-IT laufend zunehmen werden.

Fazit: Genügend finanzielle Mittel sind zwar Voraussetzung, aber nicht hinreichend für gute IT-Leistungen. Nur weil etwas teuer ist, ist es nicht automatisch gut. Und nur weil IT-Leistungen gut bewertet werden, müssen sie noch lange nicht teuer sein!

Für eine hohe Benutzerzufriedenheit sind einfache und schnelle Prozesse sowie vor allem die Leute mit ihrer Haltung verantwortlich. Freundliche und lösungsorientierte Mitarbeitende sind nicht teurer als unfreundliche und problemorientierte IT-Spezialisten.

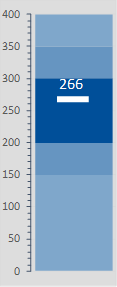

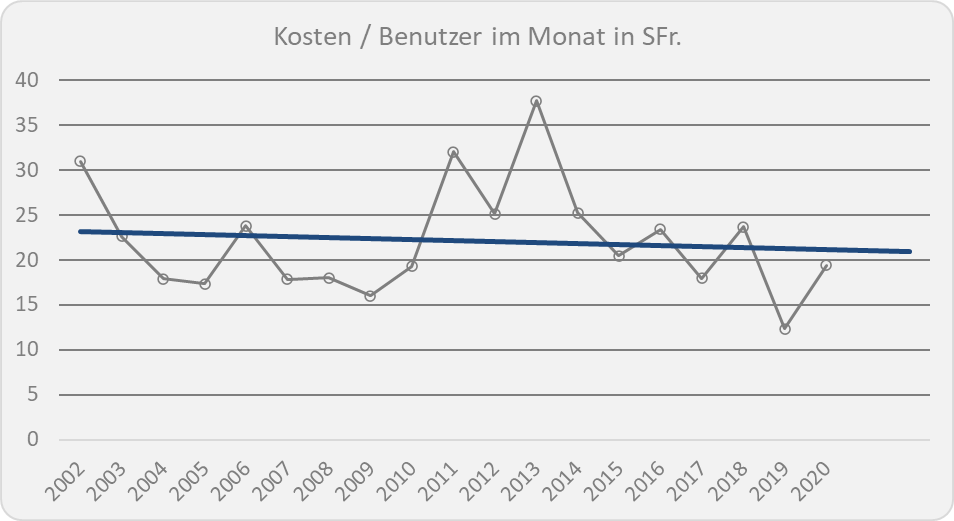

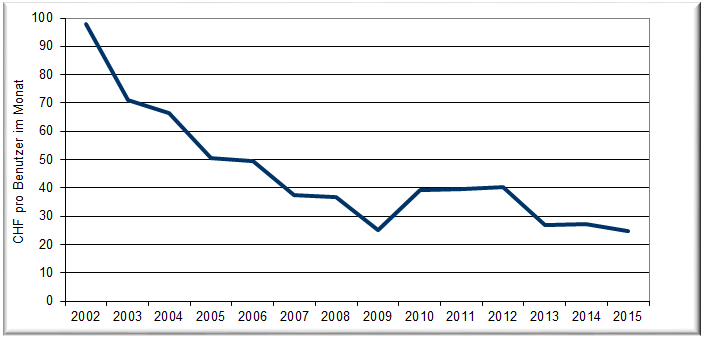

Gesunkene Kosten im Service Desk

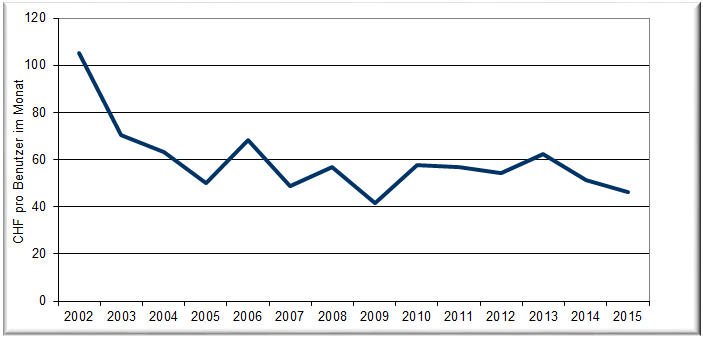

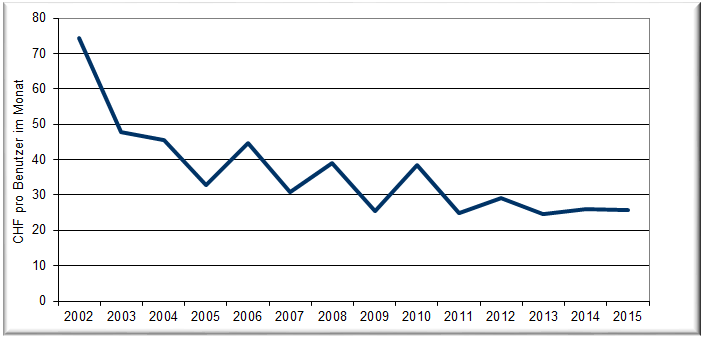

Entwicklung der Kosten im Service Desk

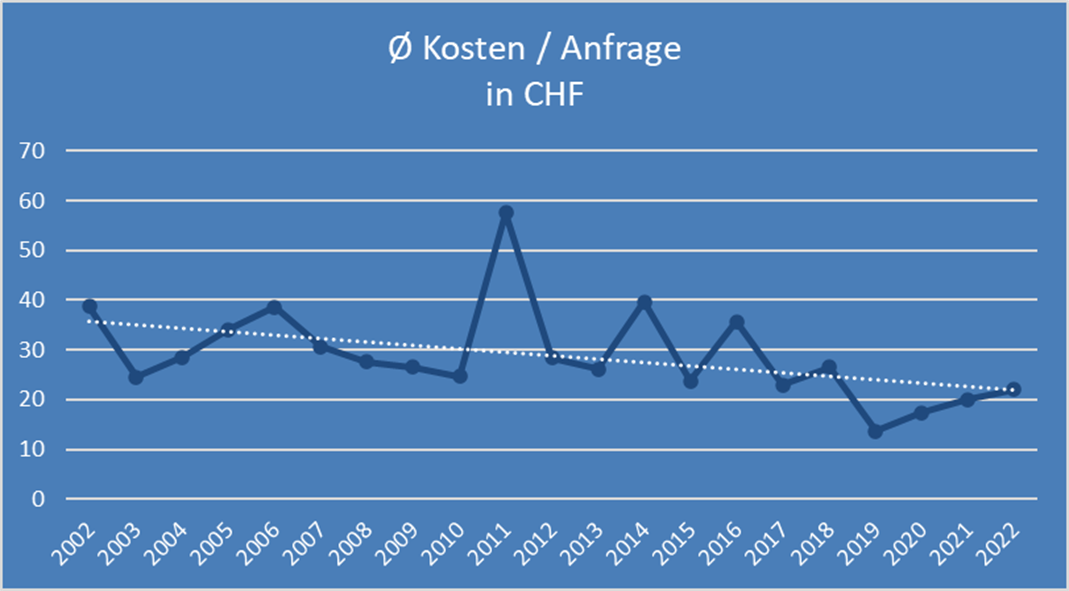

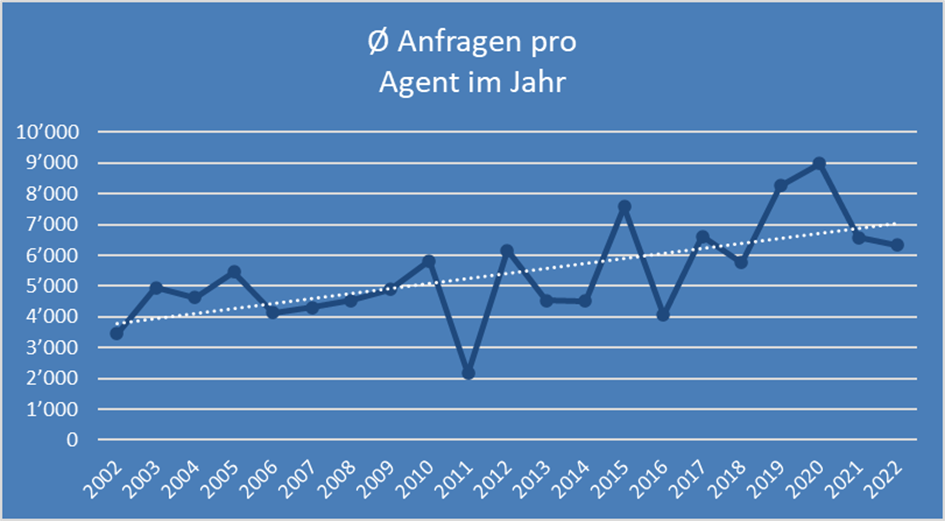

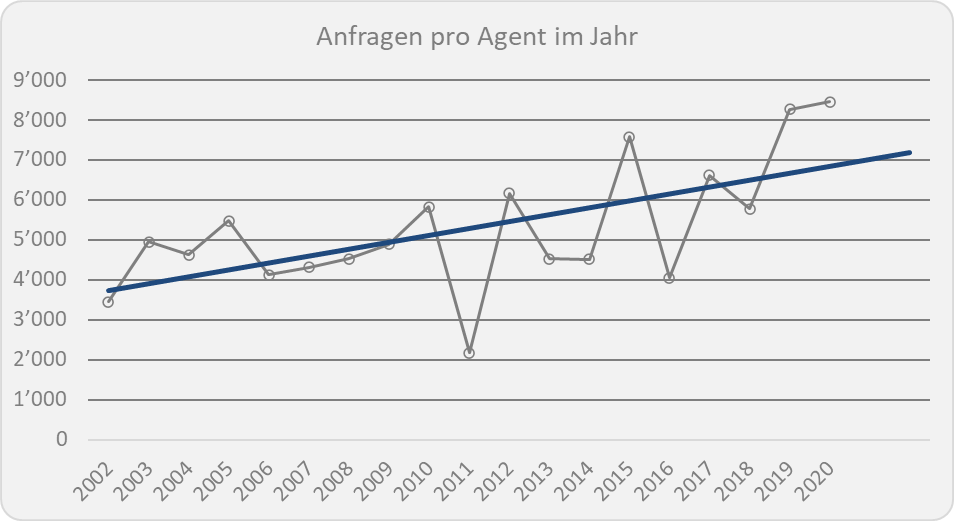

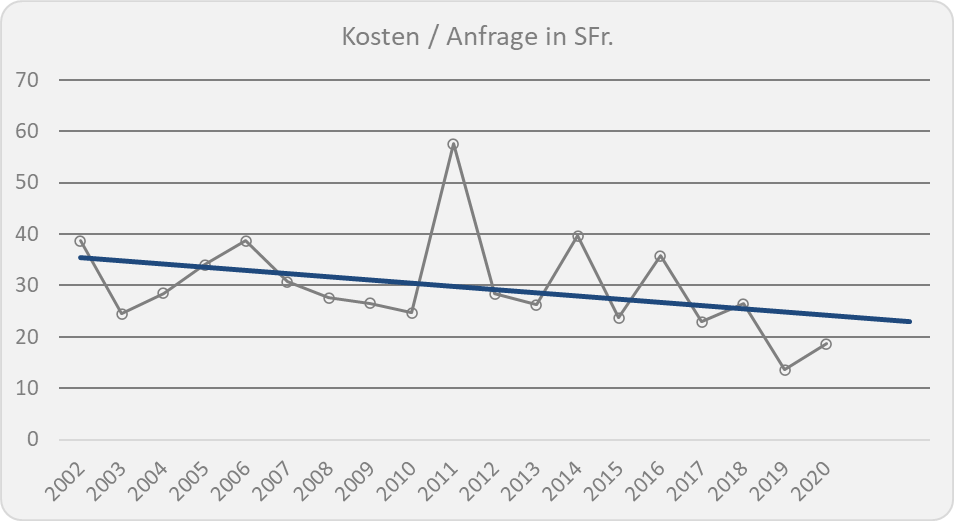

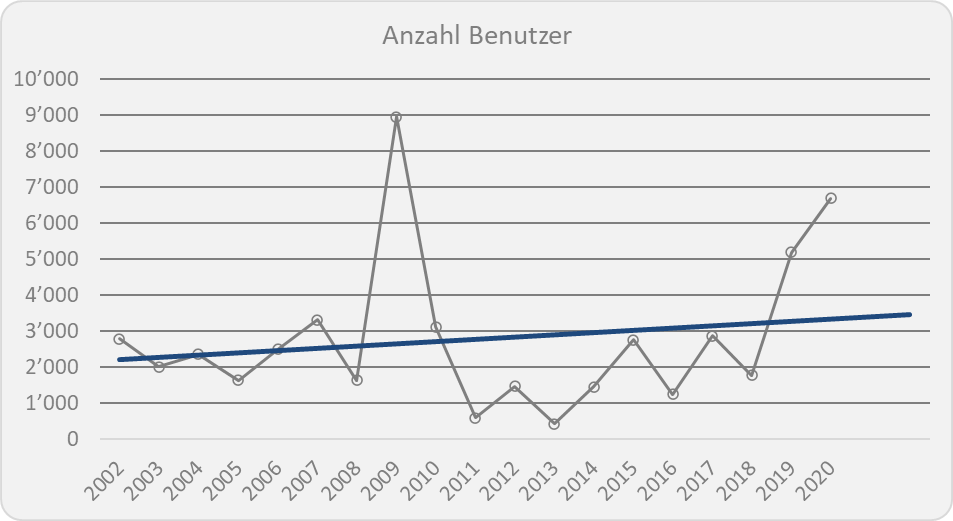

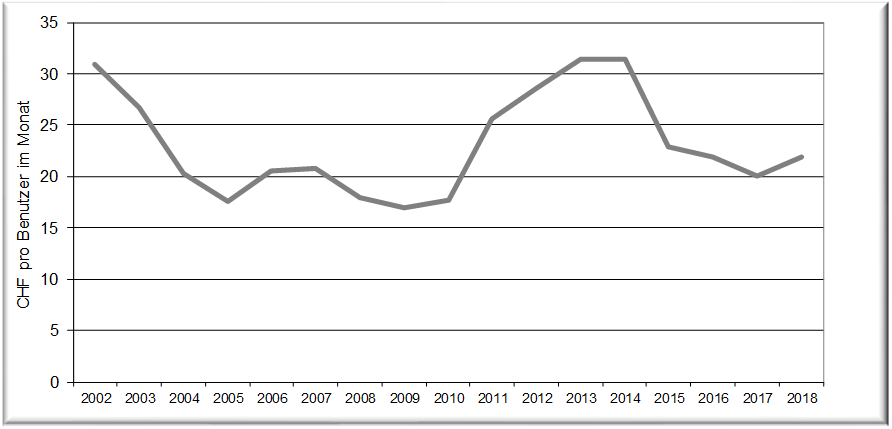

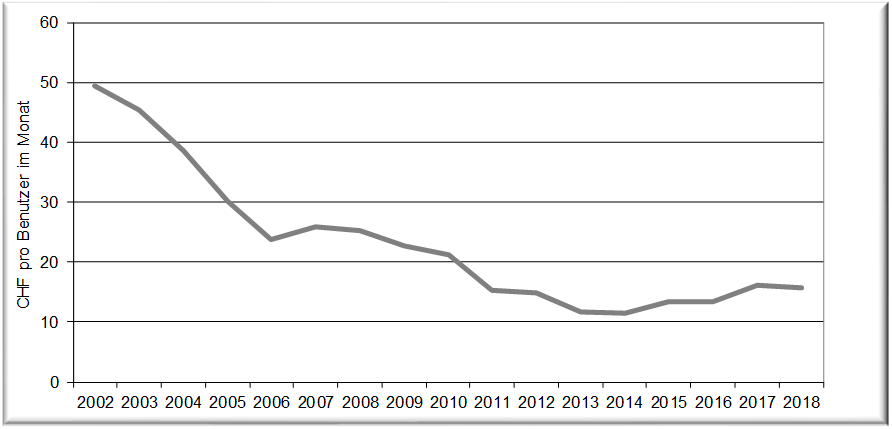

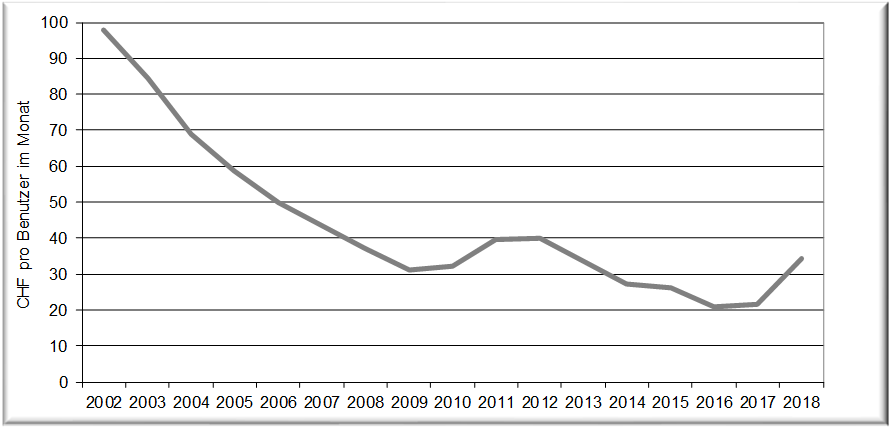

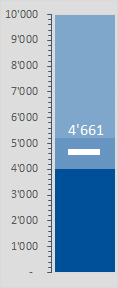

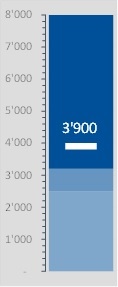

Durch die Steigerung von rund 4 000 Anfragen auf gut 7 000 Anfragen pro Jahr, die eine Agentin oder ein Agent im Service Desk behandelt, sinken die Kosten pro Anfrage entsprechend:

Durchschnittliche Kosten pro Anfrage in CHF im Service Desk

Dabei sinken die Kosten nicht ganz proportional zur Steigerung der Anfragen pro Service Desk Agent resp. Agentin, da in den vergangenen 20 Jahren die Löhne durch die Teuerung entsprechend gestiegen sind.

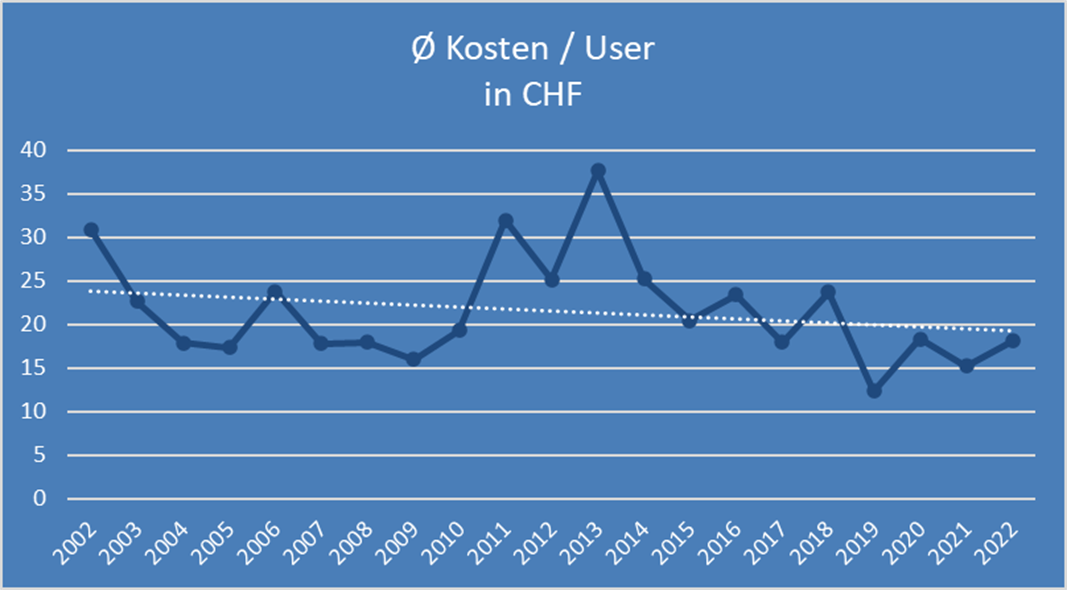

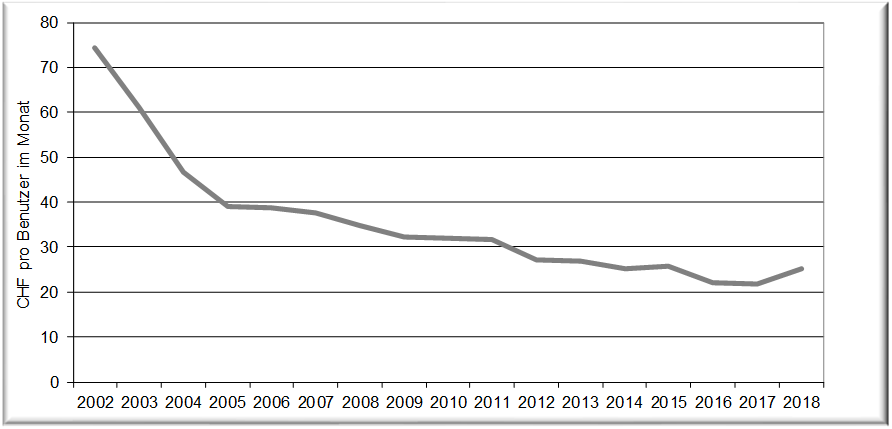

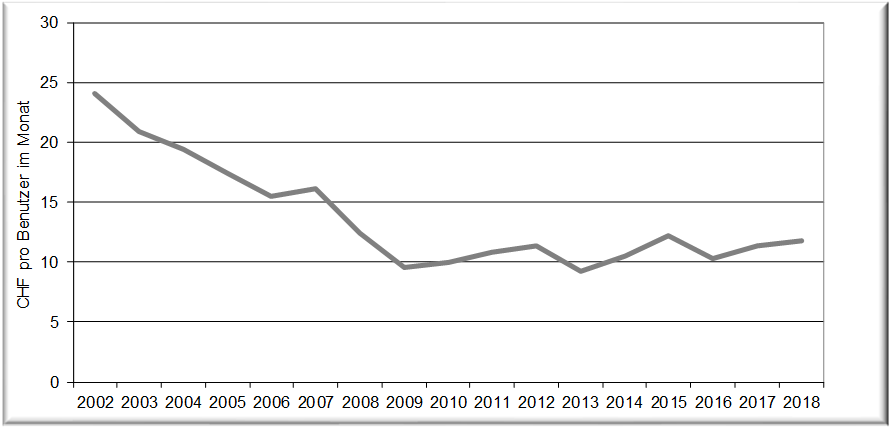

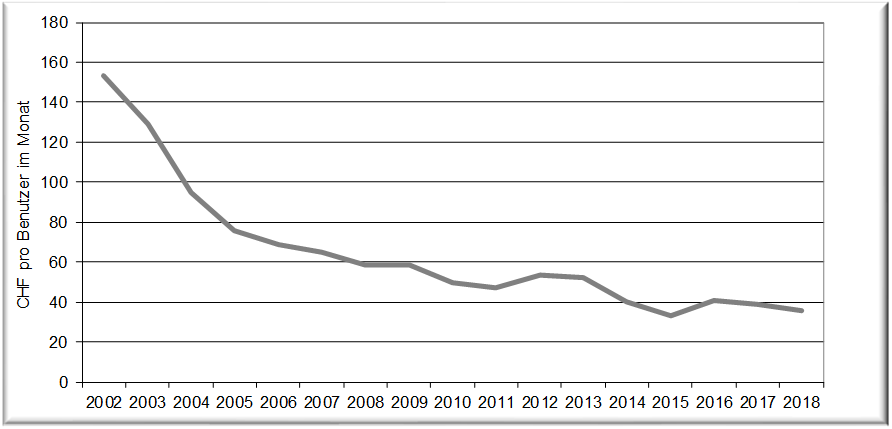

Die Kosten pro Benutzer sinken ebenfalls, allerdings weniger stark:

Durchschnittliche Kosten pro Benutzer im Monat im Service Desk

Die Anzahl Benutzer pro Service Desk Agent resp. Agentin konnte zwar von rund 500 auf über 800 um 60% gesteigert werden. Im gleichen Zeitraum konnten die durchschnittlichen Kosten pro Benutzer im Monat jedoch nur um rund 20% gesenkt werden. Die Diskrepanz lässt sich nur durch gestiegene Personalkosten erklären. Einerseits dürfte dies auf die Teuerung in den letzten 20 Jahren zurückzuführen sein und andererseits wohl auch auf ein höheres Niveau der Service Desk Agentinnen und Agenten und den damit einhergehenden höheren Salären.

Wer die eigenen Kosten den obigen Werten gegenüber stellen will: Die Kosten im Service Desk bestehen vor allem aus Personalkosten (inkl. Sozialleistungen) der Service Desk Agentinnen und Agenten inkl. der Leitung des Service Desks. Ebenfalls sind die Abschreibungen und Betriebskosten einer allfälligen Telefonieanlage sowie ein Teil des ITSM-Tools (Ticket-System) in den obigen Kosten eingerechnet.

Gleich hohe Lösungsrate trotz gestiegener Effizienz im Service Desk

Entwicklung der Benchmark-Werte im Service Desk

Bei einer Steigerung von rund 4 000 Anfragen im Jahr 2002 auf gut 7 000 Anfragen, die eine Agentin oder ein Agent im Service Desk behandelt, ist anzunehmen, dass die Lösungsrate entsprechen einbricht.

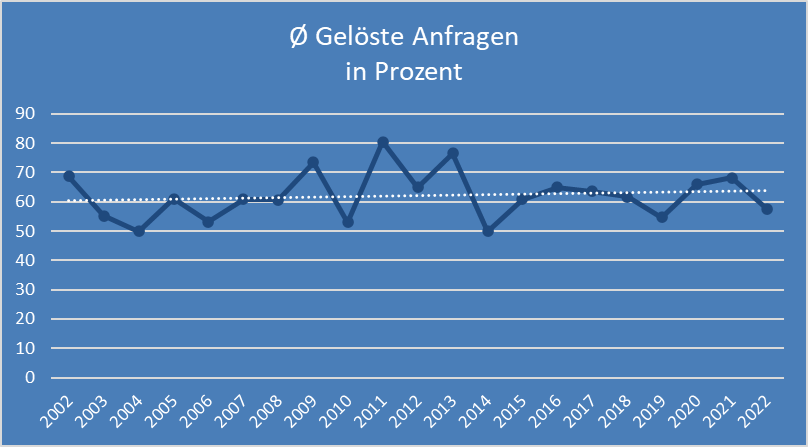

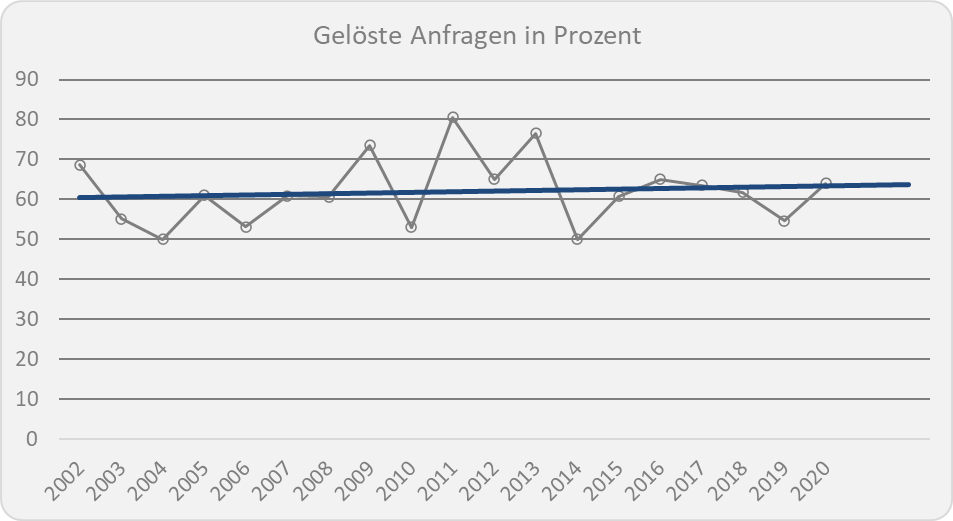

Dass dies nicht geschehen ist, überrascht und spricht für eine echte Effizienzsteigerung im Service Desk:

Lösungsrate im Service Desk

Die Lösungsrate konnte – trotz steigender Auslastung im Service Desk – konstant gehalten, resp. sogar noch leicht gesteigert werden. Mit gut 60% können beinahe zwei Drittel aller Anfragen an den Service Desk direkt gelöst werden und nur gut ein Drittel der Anfragen muss an die nachgelagerten Supportstellen weitergegeben werden.

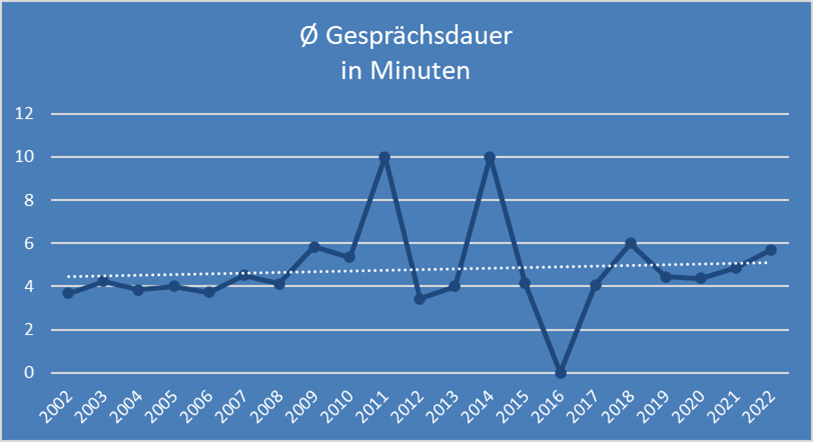

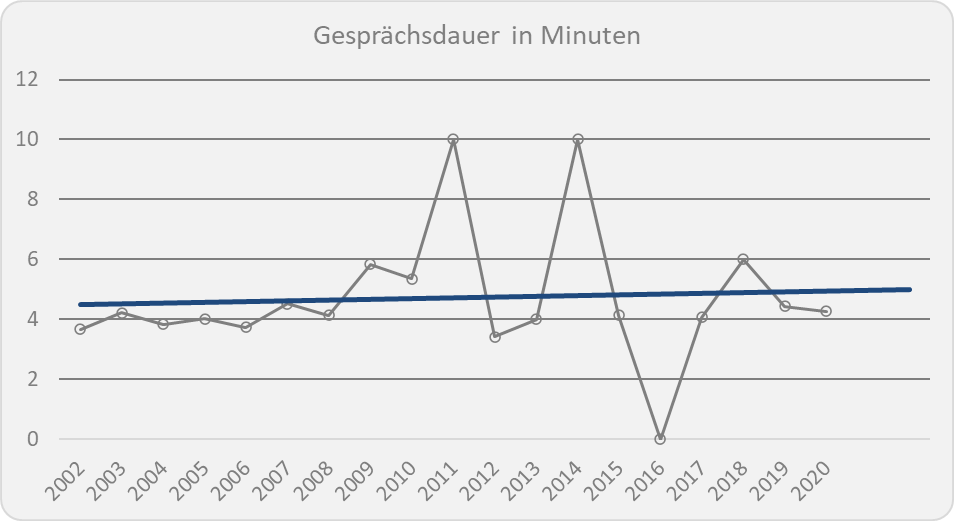

Eine (minimale) Steigerung der Lösungsrate bedingt in der Regel, dass auch die Gesprächsdauer entsprechend (minimal) ansteigt. Dies ist auch tatsächlich so geschehen:

Durchschnittliche Gesprächsdauer pro Anfrage im Service Desk

Die teilweise recht ausgeprägten Schwankungen kommen daher, dass in einigen Jahren jeweils sehr unterschiedliche Service Desks mit entsprechend unterschiedlichen Parametern gebenchmarkt wurde. Die gemittelte Entwicklung über die Zeit gleicht diesen Effekt aus.

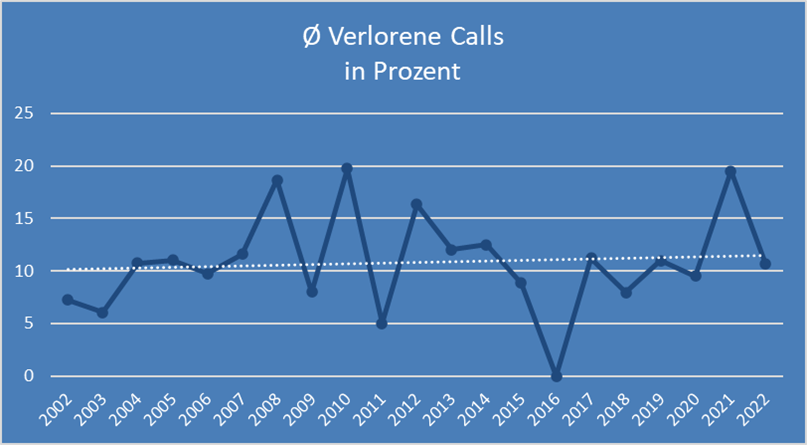

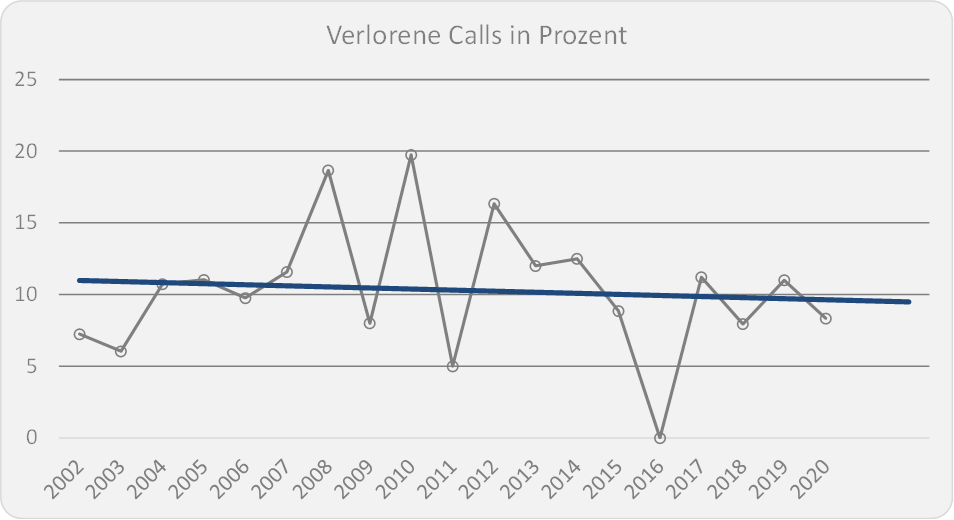

Einen negativen Einfluss hat die Steigerung der Anfragen pro Mitarbeitende im Service Desk jedoch auf die verlorenen Calls und auf die Wartezeit, bis ein Anruf entgegengenommen wird.

Die Rate der verlorenen Calls ist nur marginal schlechter geworden:

Verlorene Calls im Service Desk

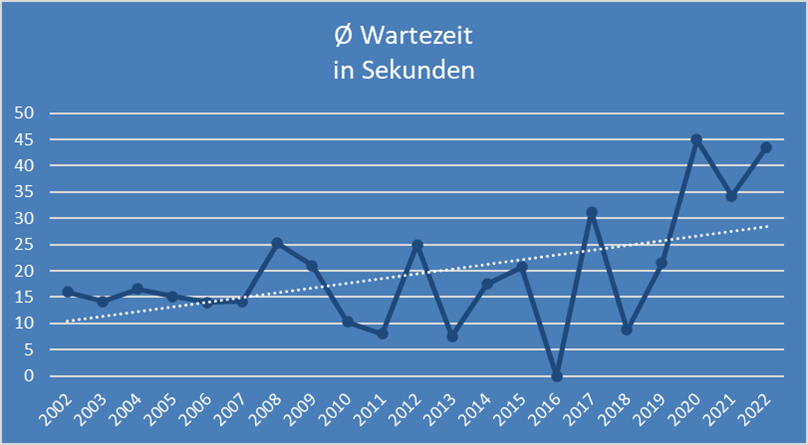

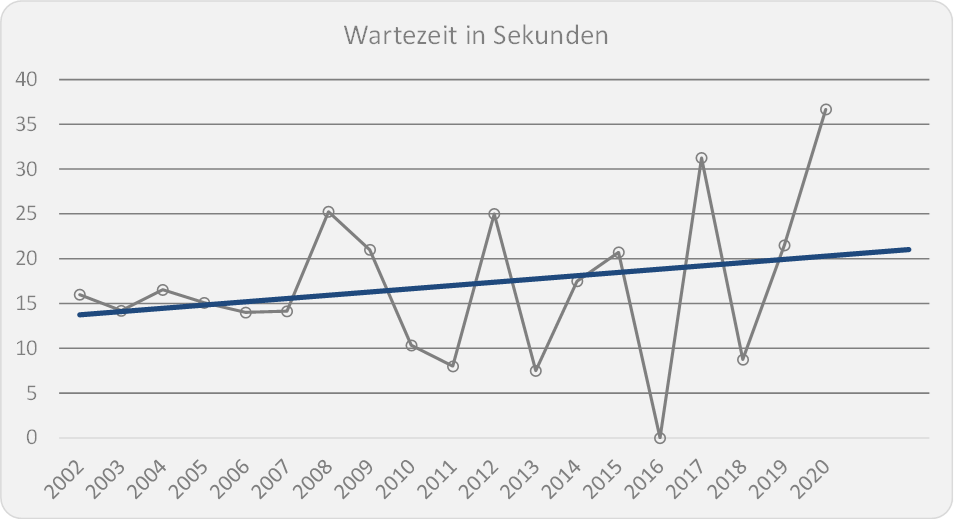

Die Wartezeit hat sich hingegen von sehr guten 15 Sekunden auf über 30 Sekunden verdoppelt:

Durchschnittliche Wartezeit im Service Desk

Zaubern kann leider auch der Service Desk nicht…

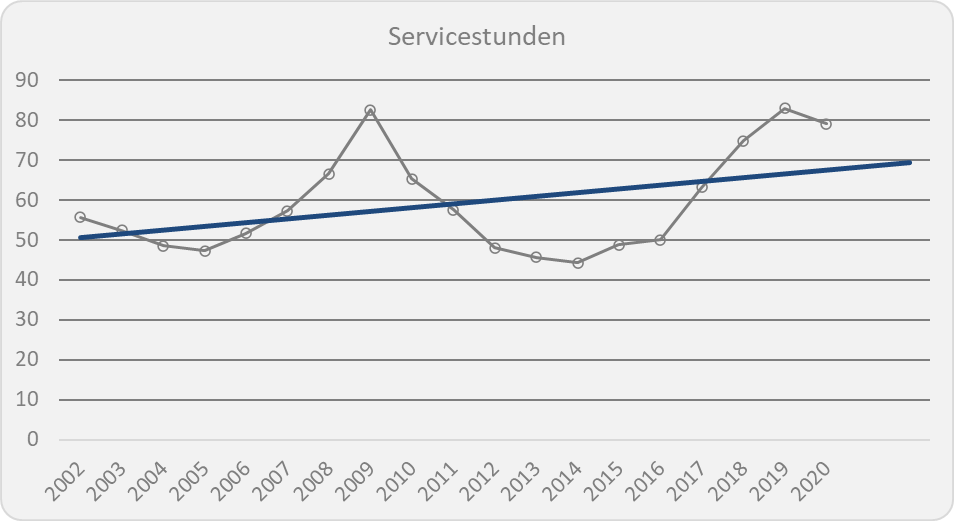

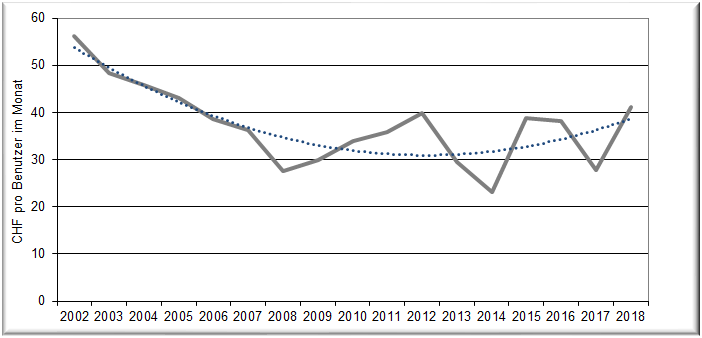

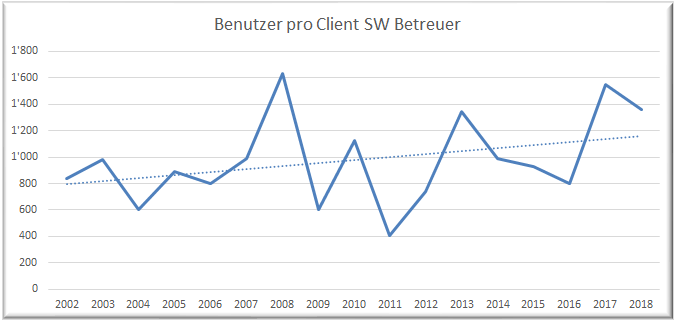

Stark gestiegene Effizienz im Service Desk

Entwicklung der Benchmark-Werte im Service Desk

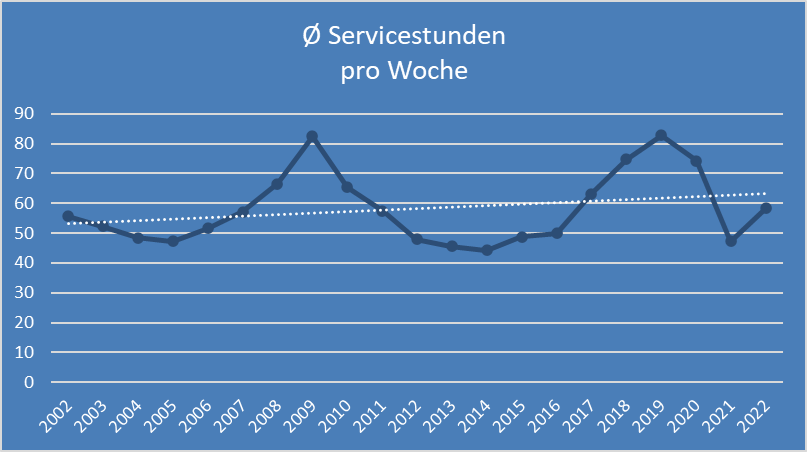

Die durchschnittliche Anzahl der Service Stunden pro Woche hat sich in den letzten 20 Jahren von gut 50 Stunden auf über 60 Stunden entwickelt. In den Durchschnittswerten sind auch Service Desks mit einem 7x24 Stunden Service enthalten. Daher treten bei den Jahreswerten immer wieder Spitzen auf. Lässt man diese weg, liegt der Durchschnitt 2022 bei knapp 50 Servicestunden pro Woche.

Da jedes Jahr unterschiedliche Unternehmen gebenchmarkt werden, schwanken die Werte von Jahr zu Jahr entsprechend. Deshalb ist in den Grafiken jeweils die weiss gestrichelte Trendlinie eingezeichnet, welche die Schwankungen ausgleicht.

Durchschnittliche Servicestunden pro Woche im Service Desk

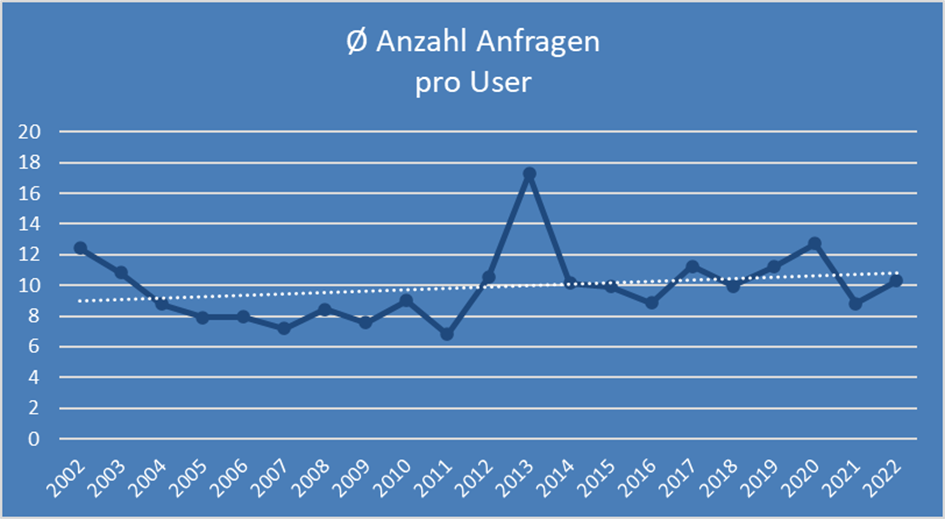

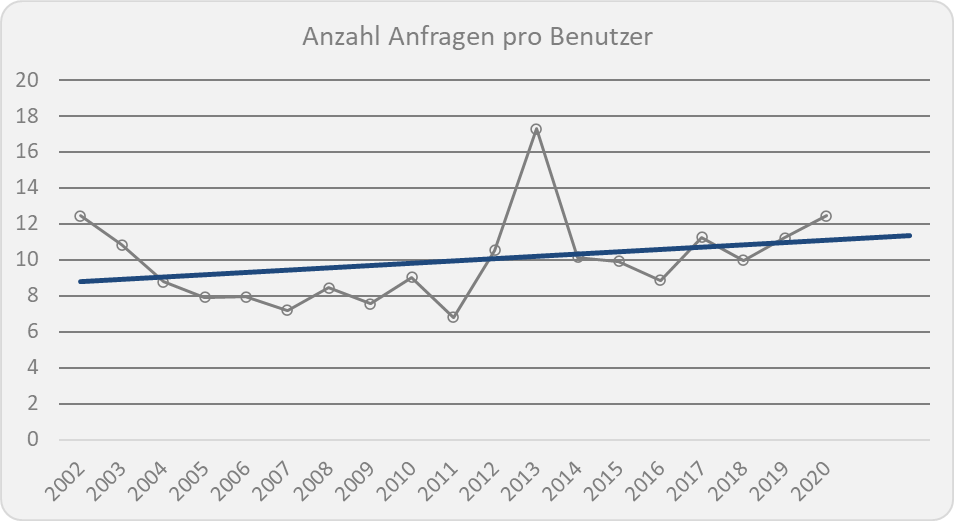

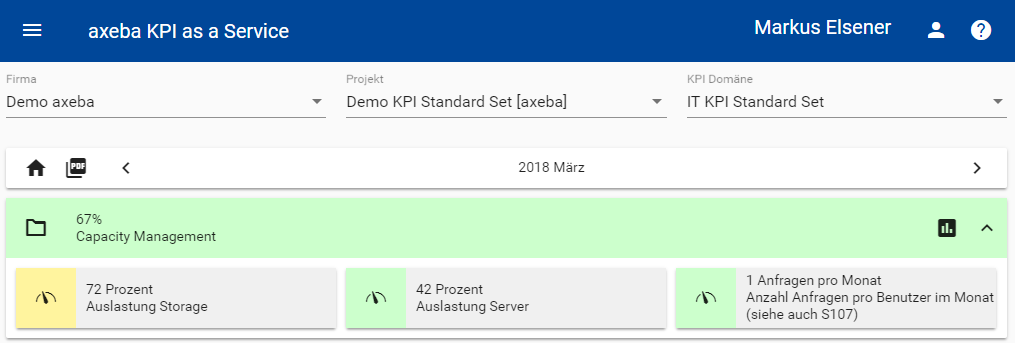

Nebst der Servicestunden ist auch die Anzahl der Anfragen pro Benutzer leicht gestiegen in den letzten 20 Jahren:

Durchschnittliche Anzahl Anfragen pro Benutzer im Jahr

Von knapp 10 Anfragen pro Benutzer im Jahr (Trendlinie links) ist das Anfragevolumen im Jahr 2022 auf gut 10 Anfragen pro Jahr gestiegen. Eine Anfrage kann dabei per Telefon, E-Mail, Serviceportal usw. gestellt werden.

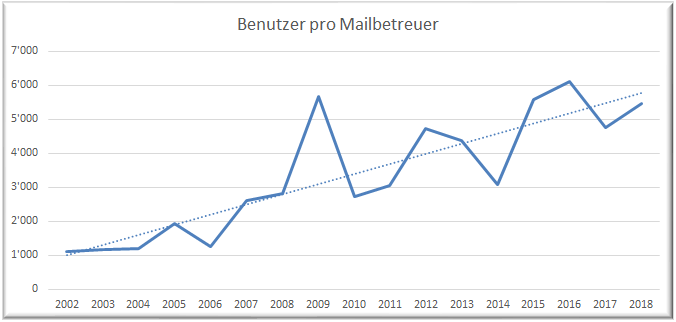

Wie die nachfolgende Grafik zeigt, wurde das gestiegene Anfragevolumen nicht durch zusätzliche Agenten im Service Desk kompensiert:

Entwicklung der Anzahl Mitarbeitende für Entwicklung und Betrieb bei 20% Wartungs-&Betriebsaufwände / 5% Betriebsoptimierung

Hat eine Agentin oder ein Agent im Service Desk im Jahr 2002 noch rund 4 000 Anfragen pro Jahr behandelt, sind dies inzwischen rund 7 000 Anfragen pro Jahr. Beinahe eine Verdoppelung.

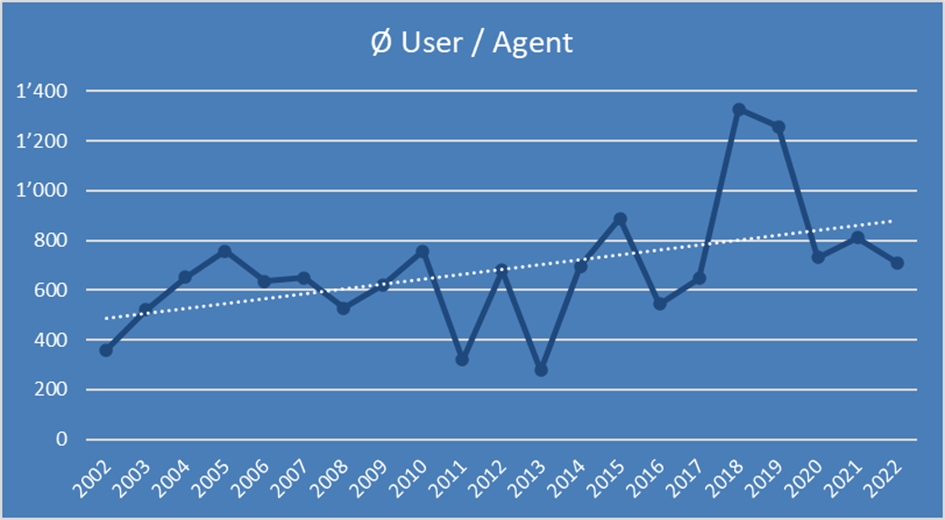

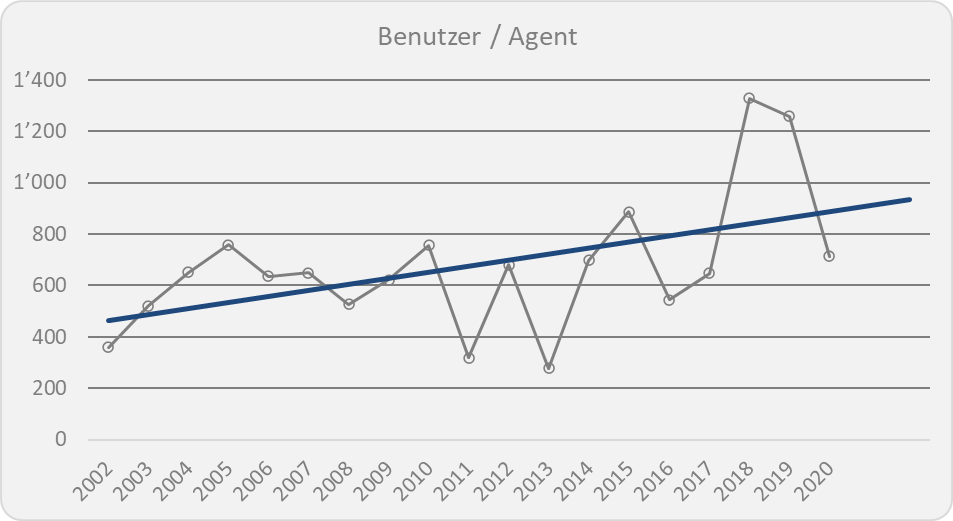

Da die Anzahl bearbeiteter Anfragen pro Service Desk Agent stark zunimmt, die Anzahl Anfragen pro Benutzer aber nur leicht steigt, steigt auch die Anzahl User pro Service Desk Agent. Die Anzahl User pro Agenten liegt aktuell bei 711 Usern:

Durchschnittliche Anzahl Benutzer pro Agent

Mit einer Steigerung von rund 500 Benutzern pro Service Desk Agent (linker Teil der Trendlinie) auf über 800 Benutzer pro Agent (rechter Teil der Trendlinie), konnte die Effizienz im Service Desk stark gesteigert werden. Insbesondere wenn man bedenkt, dass die erweiterten Servicezeiten sowie das höhere Anfragevolumen die Situation zusätzlich verschärfen.

Ob mit dieser anspruchsvollen Situation die Lösungsrate gehalten werden kann, sehen wir im nächsten KPI of the month.

Sinn und Unsinn von Kennzahlen (KPI)

Goodharts Gesetz

Im Magazin (DAS MAGAZIN) vom 18. Februar 2023 ist ein interessanter Artikel über KPI erschienen (Paywall), der das Goodharts Gesetz beschreibt. Dieses heisst «As soon as the government attempts to regulate any particular set of financial assets, these become unreliable as indicators of economic trends» und meint, dass eine Kennzahl aufhört eine gute Kennzahl zu sein, sobald sie zum alleinigen Ziel wird.

Goodharts bezieht dies auf die finanzielle Regulierung von Aktivposten durch eine Regierung und sagt, dass solche Indikatoren für ökonomische Trends unbrauchbar werden, sobald sie als Ziel vorgegeben werden, da Investoren versuchen werden, derart zu investieren, dass sie von den möglichen Effekten einer Regulation finanzieller Aktivposten profitieren (Wikipedia).

Im Artikel des Magazins wird dies illustriert mit der Kobraschlangenplage in Indien während der britischen Kolonialherrschaft. Um diese zu bekämpfen, hat die Regierung ein Kopfgeld für jede getötete Kobra ausgesetzt, was dazu geführt hat, dass geschäftstüchtige Leute damit begonnen haben, Kobras zu züchten und dann zu töten, um die Prämie zu erhalten. Damit wurde die Kennzahl unbrauchbar, da die Leute Kobras gezüchtet haben, anstatt die vorhandene Kobraschlangenplage zu bekämpfen.

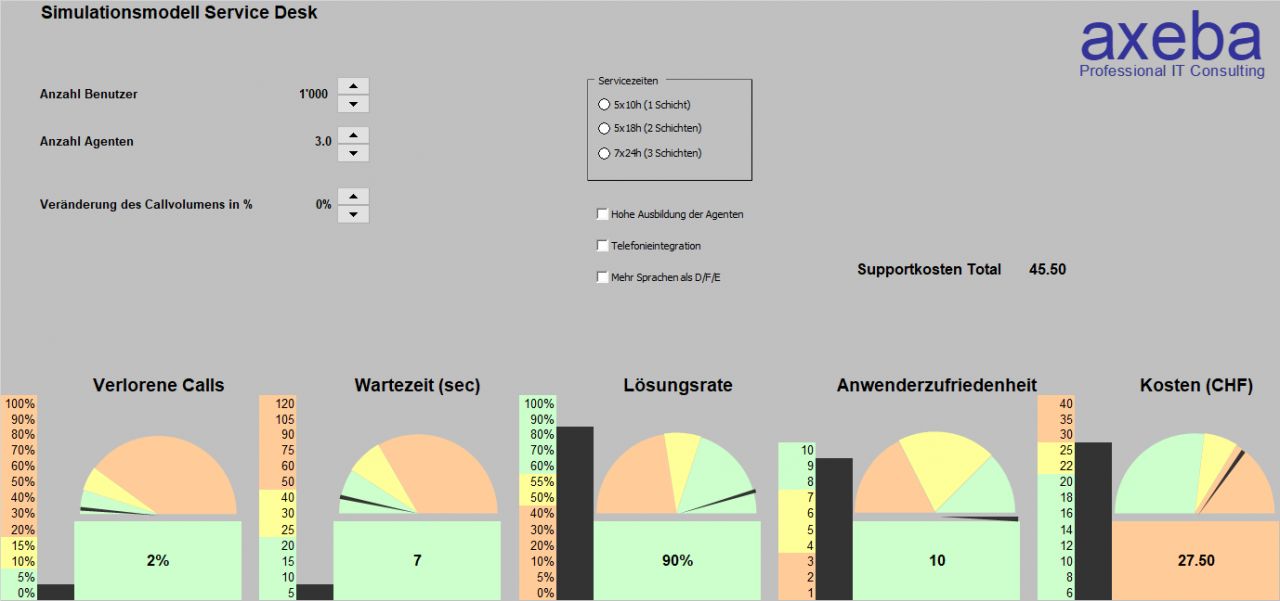

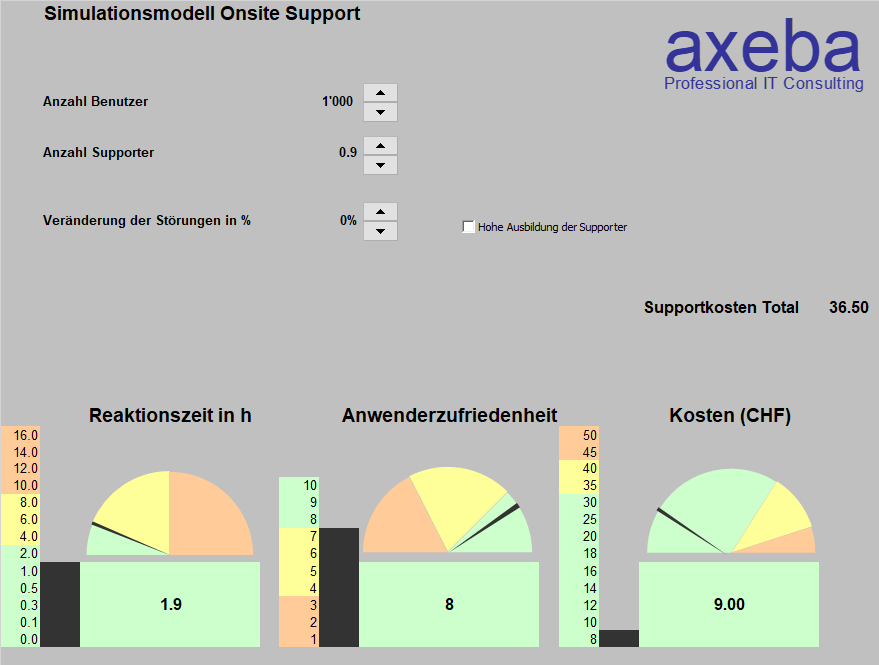

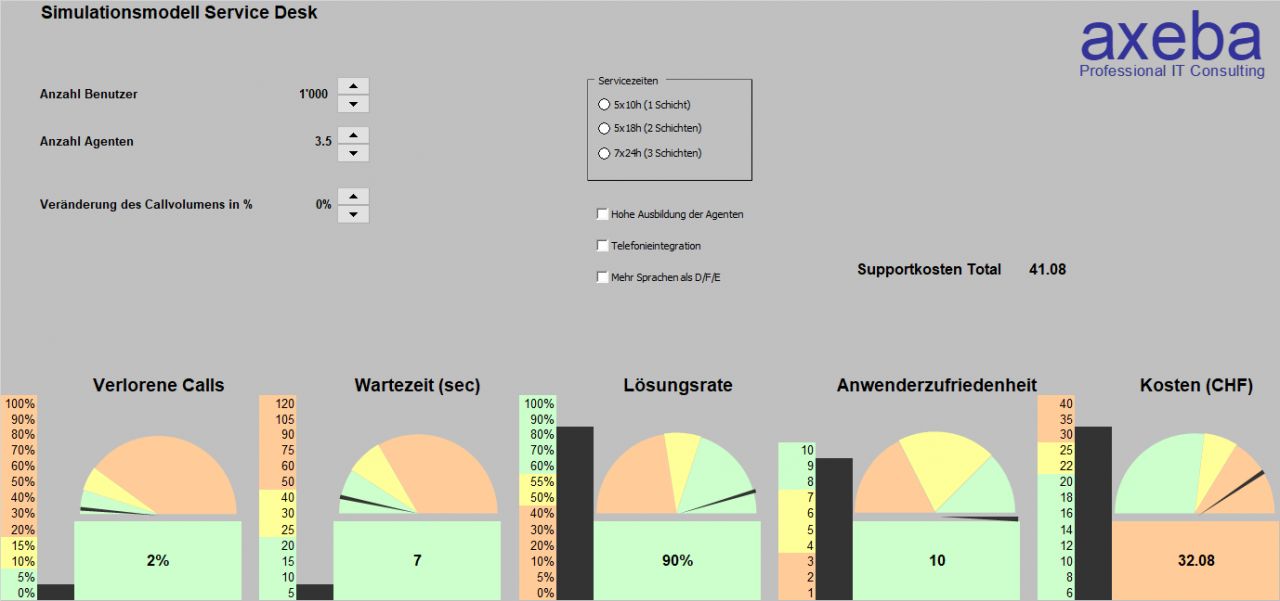

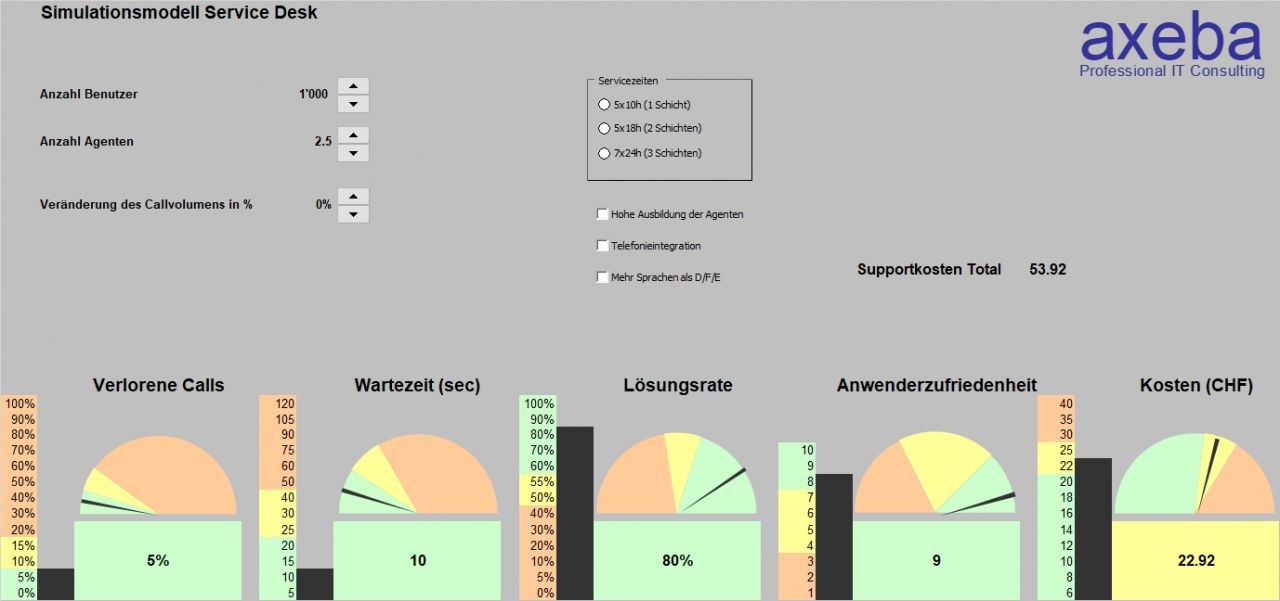

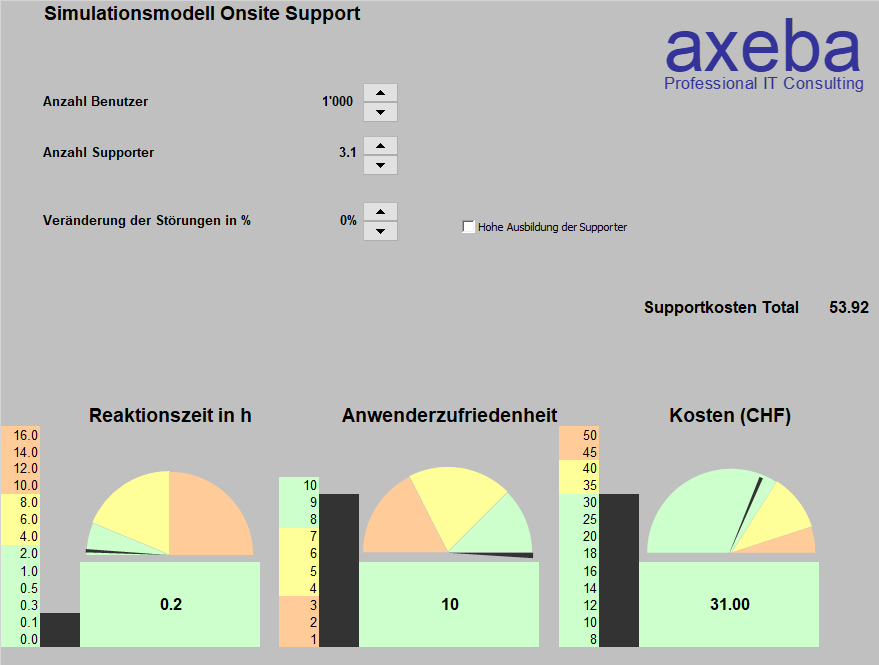

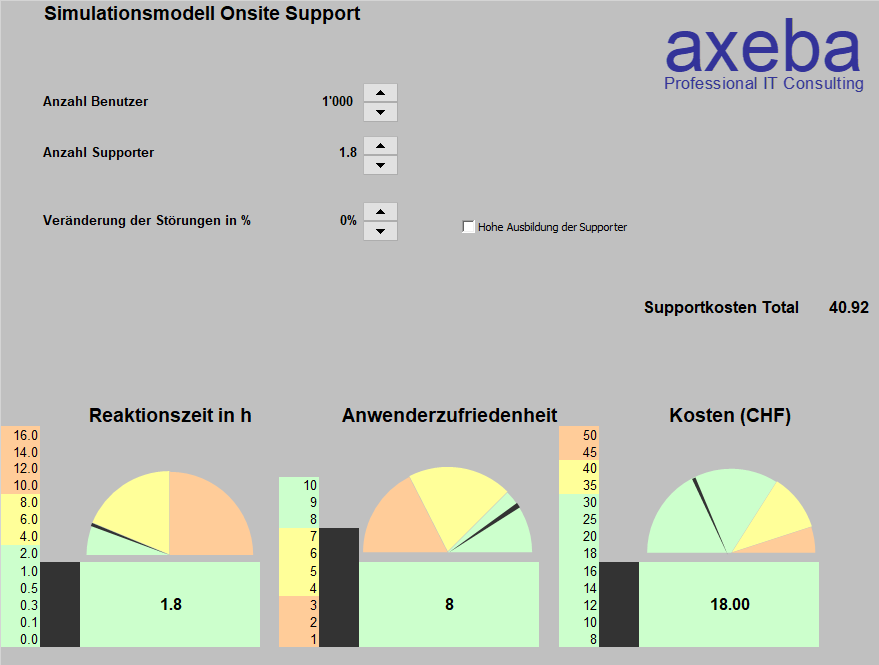

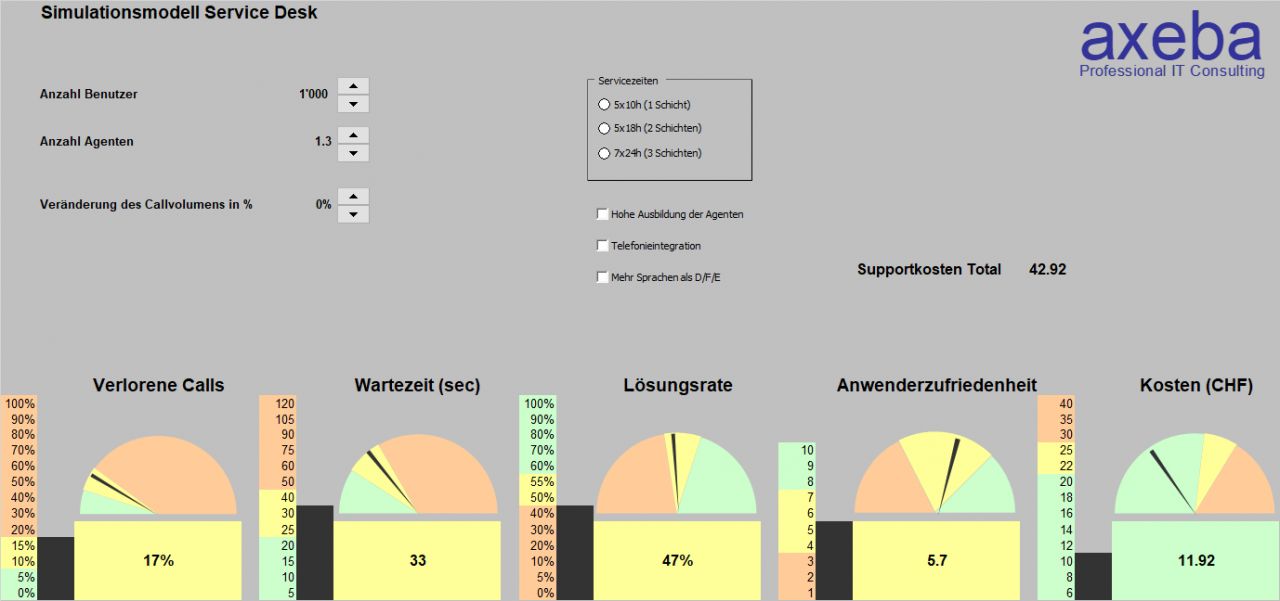

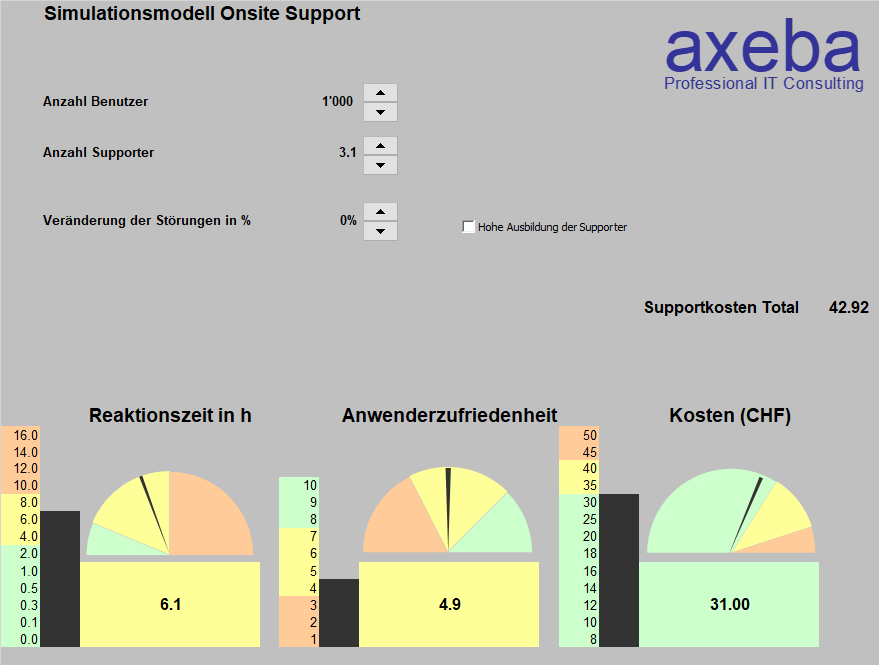

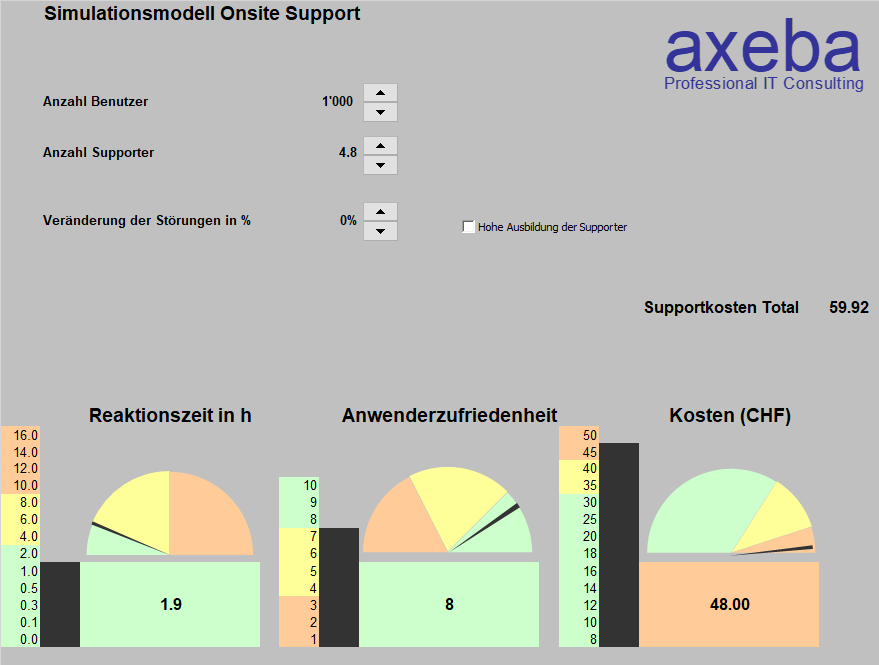

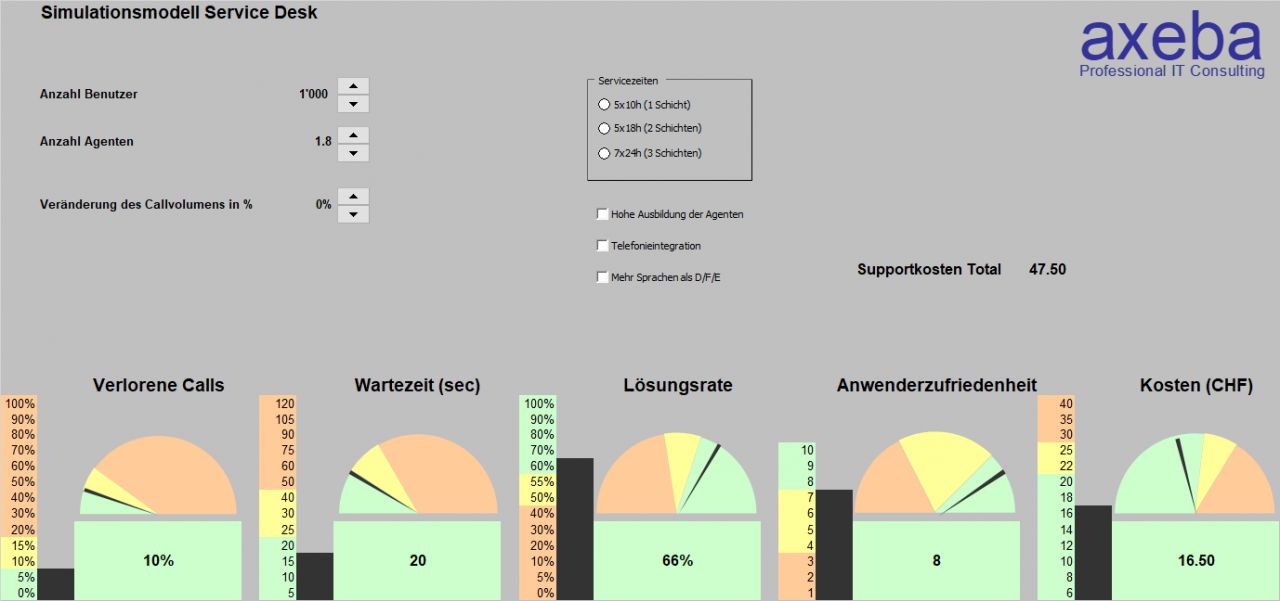

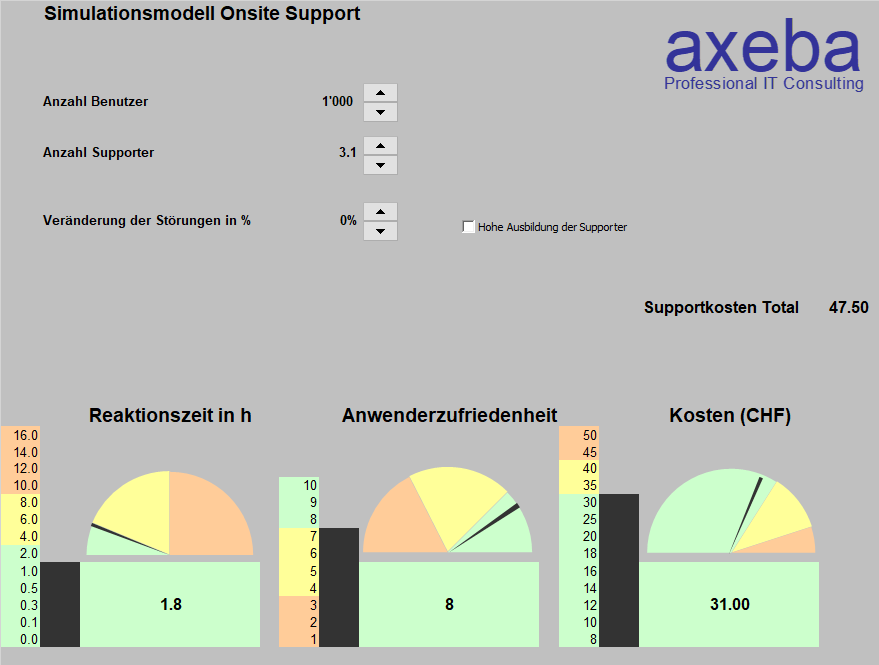

In der IT ist dies nicht anders: Wenn nur ein KPI optimiert wird, kommt selten etwas Brauchbares heraus. Nehmen wir als Beispiel die Kosten des Service Desks, die optimiert (resp. minimiert) werden sollen. Wie baut man ein günstiges Service Desk? Ganz einfach: Mit möglichst wenigen und schlecht ausgebildeten (=günstigen) Leuten im Service Desk. Damit werden zwar tiefe Kosten erreicht, aber auch:

- Eine geringe Lösungsrate und damit höhere Kosten in den nachgelagerten Supportstellen

- Längere Wartezeiten für die Anwender

Daher betrachten wir in unseren Benchmarks die Kosten immer als Letztes. Als Erstes wird immer die Last auf den Service Desk betrachtet. Im Durchschnitt sind dies rund 10 Anfragen pro Benutzer im Jahr. Falls diese wesentlich höher sind, liegt das Problem nicht im Service Desk, sondern in einer instabilen IT-Infrastruktur.

Als nächstes betrachten wir die Lösungsrate. Diese beträgt im Schnitt 60%. Falls sie wesentlich höher liegt, benötigt der Service Desk mehr Agenten als andere Service Desks, entlastet dafür die nachgelagerten Supportstellen. Liegt die Lösungsrate deutlich unter 60% werden auch weniger Ressourcen im Service Desk benötigt.

Mit einem durchschnittlichen Anfragevolumen und einer durchschnittlichen Lösungsrate (bei «normalen» Servicezeiten) wird ein Service Desk Agent pro 1 000 Benutzer benötigt. Daraus resultiert eine Wartezeit am Telefon von rund 25 Sekunden und rund 10% verlorene Anrufe.

Mit diesen Parametern können die Kosten weitestgehend vorausgesagt werden und sind praktisch nur noch das Resultat der Auslegung des Service Desks.

Wie das Beispiel des Service Desks schön zeigt, sind praktisch immer mehrere KPI nötig, die in Balance stehen müssen. Wird nur ein einzelner KPI vorgegeben (und damit optimiert) resultiert meistens eine einseitige Optimierung, die selten das gewünschte Gesamtresultat ergibt.

Die Kobras existieren aber auch im Service Desk. Immer wenn in unseren Umfragen zur Erhebung der Anwenderzufriedenheit oder in Gesprächen mit Anwendern der Vorwurf aufkommt, dass das Service Desk Tickets schliesst, obwohl das Problem noch nicht gelöst ist, wissen wir, dass hier die ein KPI vorhanden ist, mit dem gemessen wird, wie lange die Tickets offen sein dürfen.

Der Betrieb nimmt den Projekten die Ressourcen weg

Abhängigkeiten zwischen Projekt- und Betriebskosten

Die IT verfügt immer über zu wenig Spezialistinnen und Spezialisten. Vor allem für die Realisierung von Projekten stehen permanent zu wenig Leute zur Verfügung und der Backlog wächst stetig.

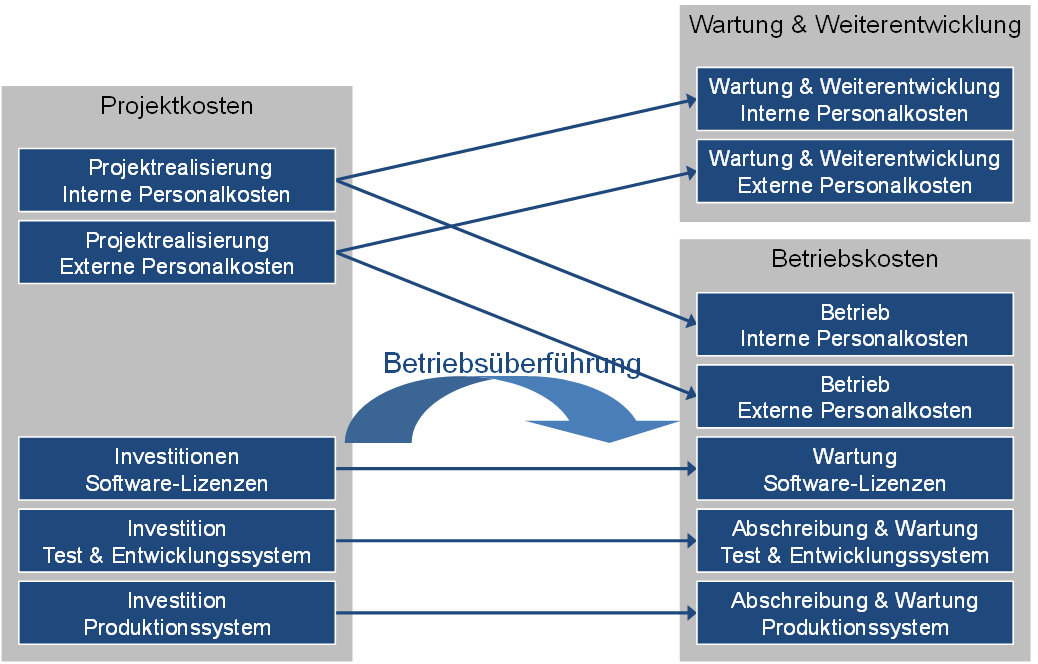

Schauen wir uns die Situation und Abhängigkeiten zwischen den Projekten und der Wartung & Weiterentwicklung sowie den Betriebskosten näher an. Viele Leute meinen, dass nach dem Abschluss eines Projektes keine Kosten mehr anfallen. Dabei geht es dann erst richtig los:

Abhängigkeit der Kosten für Wartung & Weiterentwicklung sowie Betrieb von den Projektklosten

- Ein Teil der internen und externen Mitarbeitenden, die das Projekt realisiert haben, entwickeln das System weiter resp. betreiben es.

- Aus den Investitionen in Software-Lizenzen werden nun Abschreibungen und Kosten für die SW-Wartung.

- Die Investitionen in Test-, Entwicklungs- und Produktionssysteme werden abgeschrieben und erscheinen in den Betriebskosten.

Damit entstehen auch nach Abschluss eines Projektes noch Kosten. Nur wie hoch fallen diese aus und wie können sie beeinflusst werden? Um dies näher zu betrachten, konzentrieren wir uns auf die personellen Aufwände und betrachten nur die Anzahl Personen in den Bereichen Projekte sowie Wartung & Weiterentwicklung und Betrieb. Dabei gehen wir davon aus, dass die Summe der IT-Mitarbeitenden konstant ist und nicht ansteigen kann.

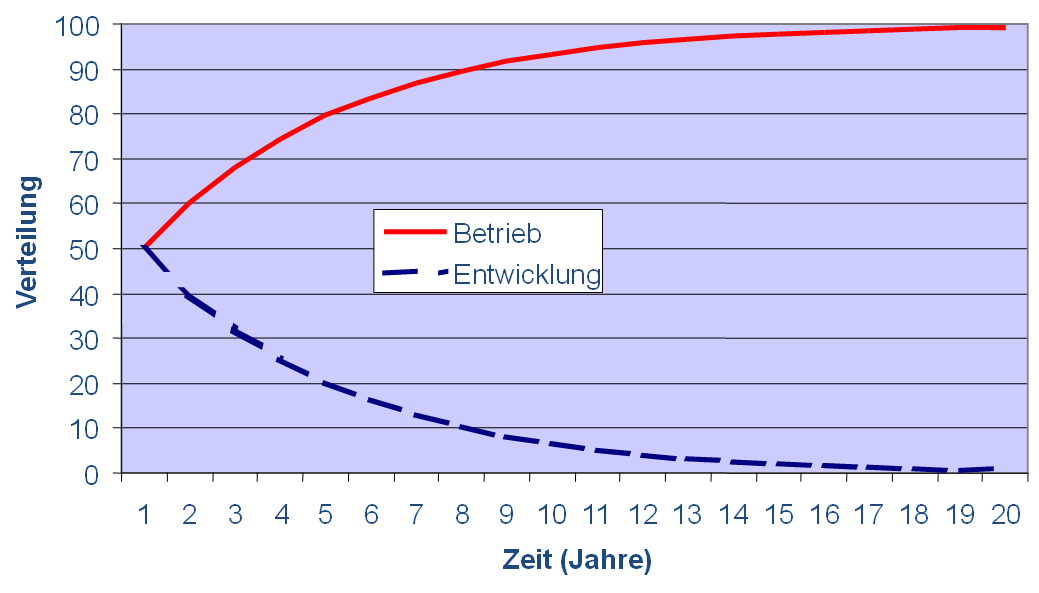

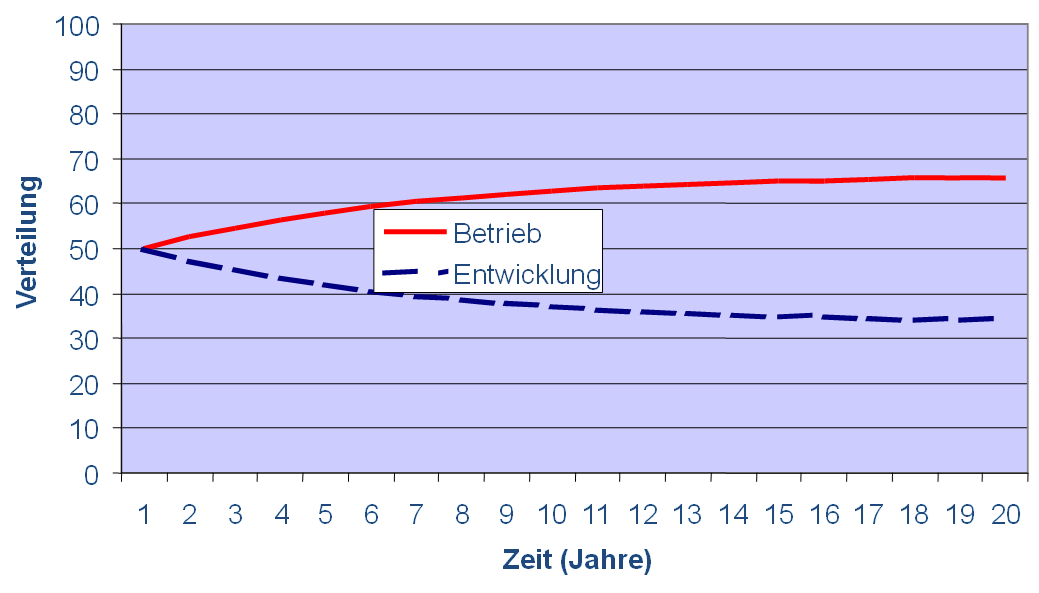

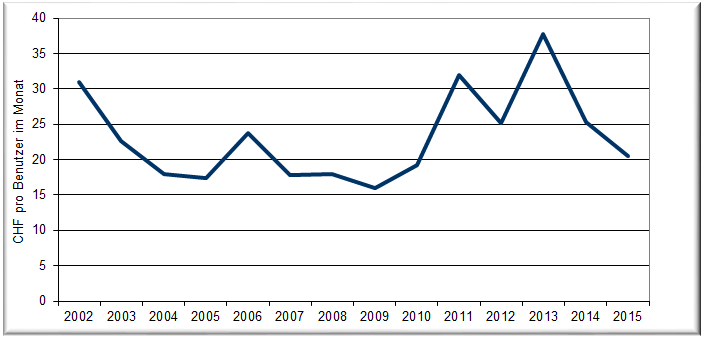

Szenario 1: 20% Wartungs-&Betriebsaufwände

Wird davon ausgegangen, dass mit jedem Projekt, das realisiert wird, 20% der Projektaufwände (pro Jahr) für den Betrieb (Wartung & Weiterentwicklung) benötigt werden, so nimmt die Anzahl der Betriebs-Mitarbeitenden laufend zu.

Da die Gesamtzahl der IT-Mitarbeitenden vorgegeben ist, muss daher die Anzahl der Entwickler (Projektmitarbeitende) abnehmen:

Entwicklung der Anzahl Mitarbeitende für Entwicklung und Betrieb bei 20% Wartungs-&Betriebsaufwänden

Nach einigen Jahren existieren damit nur noch Betriebs-Mitarbeitende in der IT und alle Entwickler wurden abgebaut. Da dies in der Praxis ja so nicht vorkommt, führen wir im nächsten Szenario eine Optimierung des Betriebs ein, um der Realität näher zu kommen.

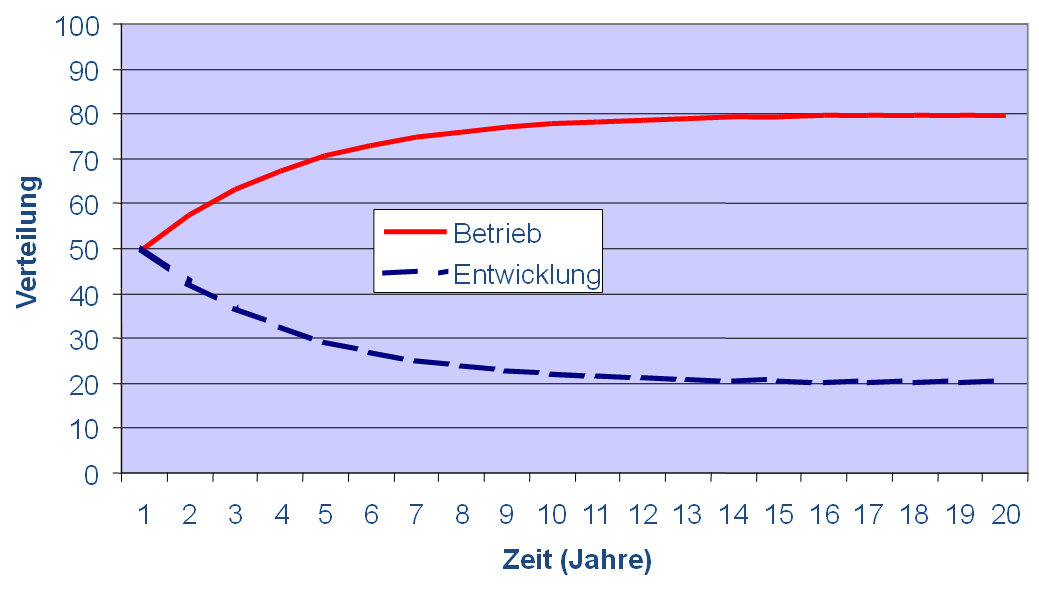

Szenario 2: 20% Wartungs-&Betriebsaufwände / 5% Betriebsoptimierung

In einer ersten Schätzung wird angenommen, dass sich der IT-Betrieb jedes Jahr um 5% optimiert, das heisst mit 5% weniger Mitarbeitenden auskommt. Diese Zahl ist mehr oder weniger willkürlich gewählt und mag auf den ersten Blick niedrig erscheinen. Kurzfristig kann sie durchaus auch wesentlich höher sein. Eine Kosteneinsparung von 5% über mehrere Jahre zu realisieren ist jedoch eine recht anspruchsvolle Aufgabe. Im Szenario 3 wird dann die Optimierung probehalber auf 10% gesetzt, um zu prüfen, wie sich das Bild mit höheren Einsparungen verändert.

Ebenfalls wird angenommen, dass pro Jahr 20% der Mitarbeitende, die neue Lösungen realisieren, für deren Überwachung, Betrieb, Fehlerkorrektur und Anpassungen benötigt werden. Auch dies ist eine erste Annahme, die in den folgenden Beispielen ebenfalls variiert wird.

Durch die verhältnismässig große Anzahl an Entwicklern werden viele Applikationen entwickelt. Dadurch entstehen jedoch entsprechende Aufwendungen für den Betrieb dieser Applikationen, so dass der Betrieb laufend ausgebaut werden muss. Da die Gesamtzahl der IT-Mitarbeitende konstant gehalten werden soll, nehmen die Entwickler laufend ab, bis sich das Verhältnis zwischen IT-Mitarbeitenden im Betrieb und in der Entwicklung bei 80:20 einpendelt:

Entwicklung der Anzahl Mitarbeitende für Entwicklung und Betrieb bei 20% Wartungs-&Betriebsaufwände / 5% Betriebsoptimierung

Szenario 3: 10% Wartungs-&Betriebsaufwände / 5% Betriebsoptimierung

Bis anhin sind wir (willkürlich) davon ausgegangen, dass 20% der Projektaufwände für den späteren Betrieb und die Wartung der Lösung aufgewendet werden müssen.

In diesem Szenario reduzieren wir diesen Wert auf 10%. Das heisst, dass eine Person für den Betrieb und die Weiterentwicklung der Lösung benötigt wird, falls 10 Personen für die Projektrealisierung tätig waren.

Wenn sich der Betrieb nach wie vor um 5% pro Jahr optimiert, resultiert in diesem Szenario eine Verteilung von ⅔ Betriebspersonal zu ⅓ Projektmitarbeitenden (Entwickler):

Entwicklung der Anzahl Mitarbeitende für Entwicklung und Betrieb bei 10% Wartungs-&Betriebsaufwände / 5% Betriebsoptimierung

Szenario 4: 10% Wartungs-&Betriebsaufwände / 10% Betriebsoptimierung

Im vierten Szenario werden sowohl die Aufwände für die Wartung und den Betrieb auf 10% der Projektaufwände als auch die Betriebsoptimierungen auf jährlich 10% gesetzt.

Entwicklung der Anzahl Mitarbeitende für Entwicklung und Betrieb bei 10% Wartungs-&Betriebsaufwände / 10% Betriebsoptimierung

Ob die Betriebsaufwände tatsächlich über mehrere Jahre jeweils um 10% gesenkt werden können, sei dahin gestellt.

Nur in dieser anspruchsvollen Kombination der Werte gelingt es durch laufende Optimierungen des Betriebs, die durch die neuen Applikationen zusätzlich dazukommenden Aufwendungen wieder zu kompensieren, so dass das Verhältnis zwischen Betriebsmitarbeitenden und Entwicklern aufrechterhalten werden kann.

In der Regel sind die Mitarbeitenden nicht nur für die Entwicklung neuer Systeme zuständig, sondern warten und betreiben die Systeme auch gleich noch. Gerade mit DevOps verschwimmen diese Grenzen immer mehr. D.h. es kann nicht einfach im Organigramm gezählt werden, wie viele Personen in welchem Bereich arbeiten. Vielmehr muss für jede IT-Spezialistin und jeden IT-Spezialisten das entsprechende Verhältnis von Entwicklung zu Betrieb betrachtet werden.

Und was ist mit Cloud-Lösungen? Bei SaaS-Lösungen wird die Problematik einfach zum Provider verlagert. Sie bleibt im Grundsatz bestehen, ist jedoch nicht mehr (oder nur noch in kleinerem Ausmass) das Problem der IT-Abteilung. Die Thematik hat sich nicht geändert, sondern wurde nur verschoben.

Frohe Festtage...

... und es guets Nois

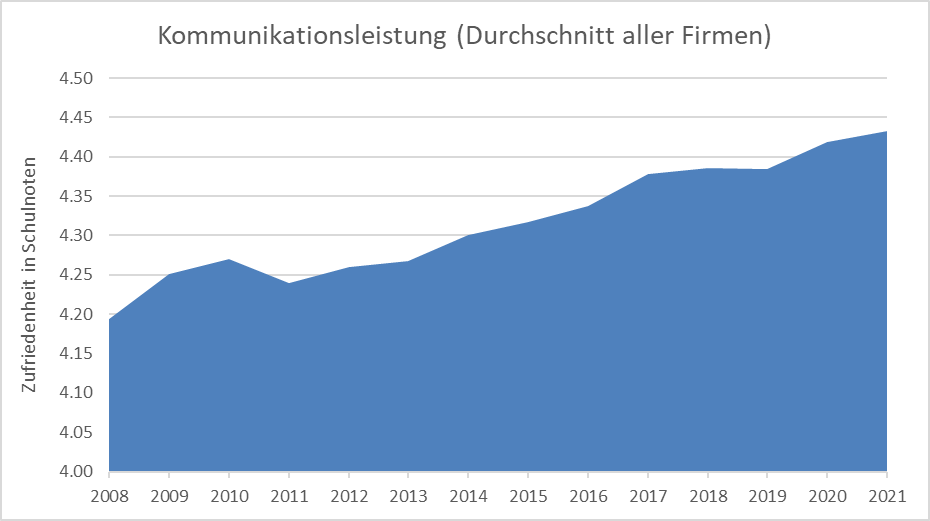

Die IT kommuniziert immer besser

Steigerung um eine Viertelnote in 14 Jahren

Die Kommunikation zu den Kunden und Anwendern der Informatik ist häufig ein stiefmütterlich behandeltes Thema. Umso positiver ist es, dass bei den von uns untersuchten Firmen und öffentlichen Verwaltungen die Zufriedenheit mit der Kommunikation der IT laufend gesteigert werden konnte:

Entwicklung der Zufriedenheit mit der Kommunikationsleistung

Die Bewertung erfolgt jeweils mit sehr schlecht / schlecht / eher schlecht / eher gut / gut / sehr gut und wird in Schulnoten dargestellt (sehr schlecht = 1, sehr gut = 6).

Von der Note 4.19 im Jahr 2008 konnte die Zufriedenheit mit der Kommunikation der IT auf 4.43 im Jahr 2021 gesteigert werden. Dies zeigt, dass die IT-Abteilungen konsequent Verbesserungsmassnahmen aus den Umfrageresultaten erarbeitet und umgesetzt haben. Dass bei den Durchschnittswerten noch Luft nach oben vorhanden ist, zeigt der Bestwert von 5.09, der im Jahr 2020 von einer IT erreicht wurde, dessen CIO und Leitungsteam stark auf eine gute Kommunikation setzen.

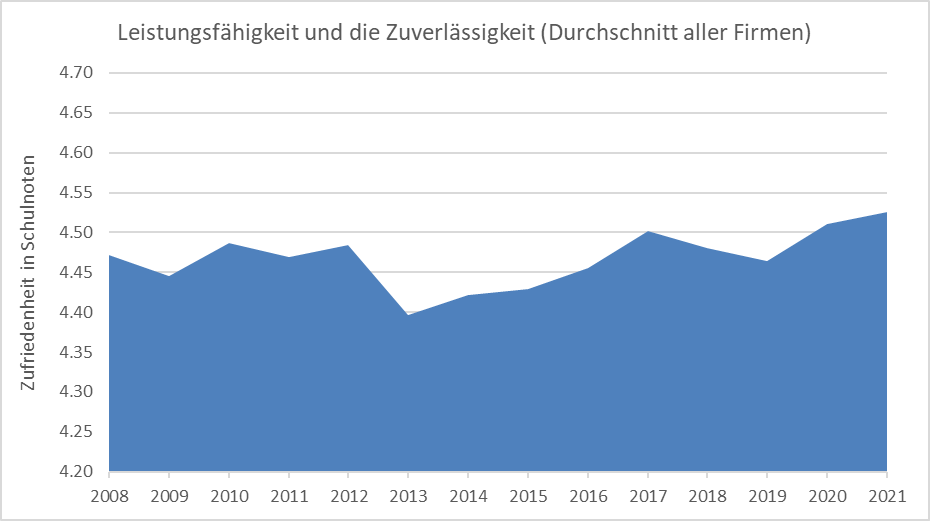

Bei der Leistungsfähigkeit und Zuverlässigkeit (Performance und Verfügbarkeit) hat sich hingegen in den vergangenen Jahren nicht viel getan und die Zufriedenheit hat sich marginal von 4.47 auf 4.53 erhöht:

Entwicklung der Zufriedenheit mit der Leistungsfähigkeit und Zuverlässigkeit

Das gleich Unternehmen, das die Bestnote in der Kommunikation erreicht hat, erzielt auch bei der Leistungsfähigkeit und Zuverlässigkeit mit 5.07 eine Note, die weit über dem Durchschnitt liegt. Die Spitzenwerte zeigen, dass in allen Gebieten sehr gute Noten über 5 erreichbar sind.

IT-Abteilungen mit sehr guten Werten zeichnen sich in der Regel dadurch aus, dass sie die Anwenderzufriedenheit alle ein bis drei Jahre erheben und diese laufend mit verschiedenen Massnahmen steigern. In der Regel kosten solche Massnahmen kein oder nur wenig Geld und sind weniger eine Frage der finanziellen Mittel, sondern viel mehr der Ambitionen der IT-Leitung und aller Mitarbeitenden in der IT.

Zufriedenheit mit Service Desk stetig gestiegen

Steigerung um eine Viertelnote in 14 Jahren

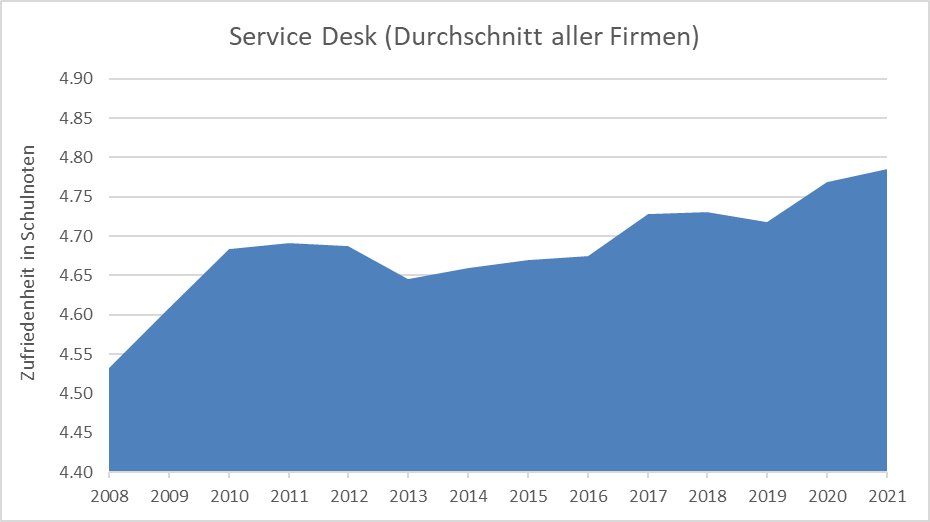

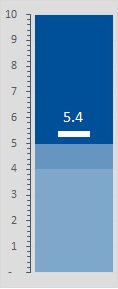

Ähnlich wie die Gesamtzufriedenheit ist auch die Zufriedenheit mit dem Service Desk über die Jahre gestiegen:

Entwicklung der Zufriedenheit mit dem Service Desk

Die Bewertung erfolgt jeweils mit sehr schlecht / schlecht / eher schlecht / eher gut / gut / sehr gut und wird in Schulnoten dargestellt (sehr schlecht = 1, sehr gut = 6).

Insgesamt ist die Zufriedenheit mit dem Service Desk von 4.53 im Jahr 2008 auf 4.78 im Jahr 2022 gestiegen. Die zwischenzeitlichen Rückschläge in den Jahren 2013 und 2019 dürften auf statistische Schwankungen zurückzuführen sein, da wir nicht jedes Jahr bei den gleichen Unternehmen und öffentlichen Verwaltungen die Anwenderzufriedenheit erheben.

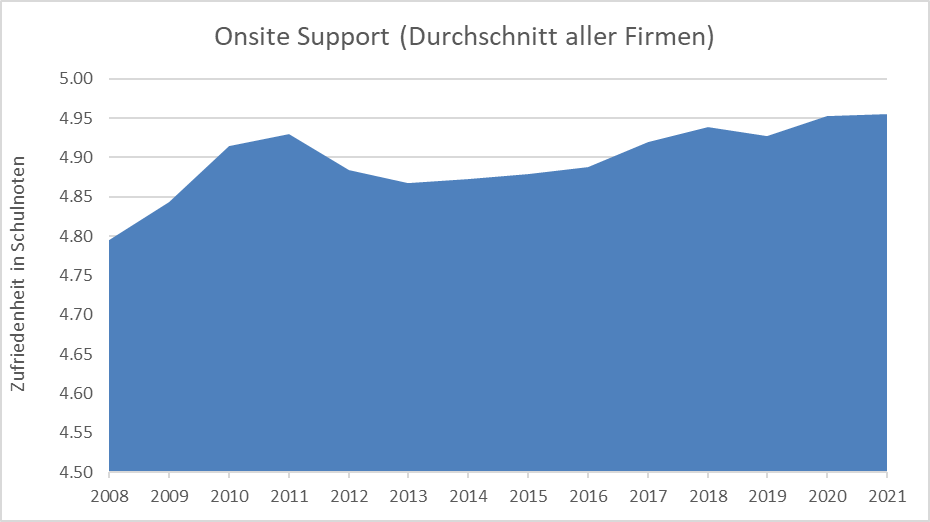

Im mit dem Service Desk eng verwandten Gebiet Onsite Support konnte die Zufriedenheit über die Jahre ebenfalls gesteigert werden:

Entwicklung der Zufriedenheit mit dem Onsite Support

Allerdings fällt die Steigerung geringer aus als im Service Desk. Dies dürfte darauf zurückzuführen sein, dass die Zufriedenheit mit dem Onsite Support ein höheres Niveau aufweist wie der Service Desk.

Der Onsite Support wird übrigens bei praktisch allen Umfragen am besten beurteilt. Dies dürfte daran liegen, dass hier der direkteste und vor allem auch persönlichste Kontakt stattfindet und die Anwender die Personen im Onsite Support teilweise persönlich kennen.

Wie wir bereits bei der Gesamtzufriedenheit im letzten KPI of the month gesehen haben, steigt diese über die Jahre an. Ein wesentlicher Beitrag zur Steigerung der Anwenderzufriedenheit haben sicherlich die Unternehmen und öffentlichen Verwaltungen geleistet, die wir regelmässig untersuchen. In den meisten Fällen ist bei der wiederholten Durchführung eine Steigerung zu beobachten, da entsprechende Massnahmen aus der letzten Erhebung erarbeitet und umgesetzt worden sind.

Gesamtzufriedenheit mit IT-Leistungen stetig gestiegen

Steigerung um eine Viertelnote in 14 Jahren

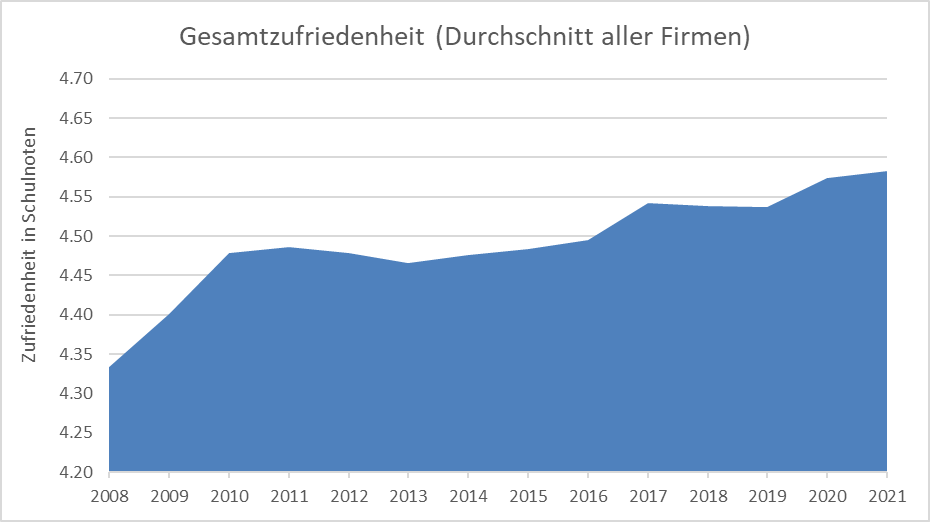

Durch die Erhebung der Gesamtzufriedenheit mit den IT-Leistungen kann auf einen Blick beurteilt werden, wie die Leistungen der IT bei den Anwendern ankommen. Die Gesamtzufriedenheit ist ein berechneter Wert, der sich aus der Zufriedenheit der folgenden Gebiete zusammensetzt:

- Service Desk

- Onsite Support

- Leistungsfähigkeit und Zuverlässigkeit (Performance und Verfügbarkeit)

- Kommunikation der IT

- Schulungsangebot

Die Bewertung erfolgt jeweils mit sehr schlecht / schlecht / eher schlecht / eher gut / gut / sehr gut und wird in Schulnoten dargestellt (sehr schlecht = 1, sehr gut = 6).

Entwicklung der Gesamtzufriedenheit

Die Gesamtzufriedenheit mit den IT-Leistungen hat sich in den vergangenen Jahren kontinuierlich gesteigert und sich von 4.33 im Jahr 2008 auf 4.58 im Jahr 2021 entwickelt. Die Steigerung um eine Viertelnote (0.25) in 14 Jahren mag gering erscheinen und zeigt, dass es nicht einfach ist, die Zufriedenheit signifikant zu steigern.

Ein wesentlicher Beitrag zur Steigerung der Anwenderzufriedenheit haben sicherlich die Unternehmen und öffentlichen Verwaltungen geleistet, die wir regelmässig untersuchen. In den meisten Fällen ist bei der wiederholten Durchführung eine Steigerung zu beobachten, da entsprechende Massnahmen aus der letzten Erhebung erarbeitet und umgesetzt worden sind.

Aber auch bei IT-Abteilungen, deren Zufriedenheit wir zum ersten Mal erheben, treten zum Teil sehr gute Resultate auf.

Auch hier gilt: Keine Regel ohne Ausnahme. Bei einigen Firmen sinkt die Zufriedenheit mit den IT-Leistungen auch wieder. Dies ist häufig zu beobachten bei einem Technologiewechsel, bis die neue Technologie wieder stabil und performant läuft oder nach einem Wechsel im IT-Management oder nach einem Outsourcing.

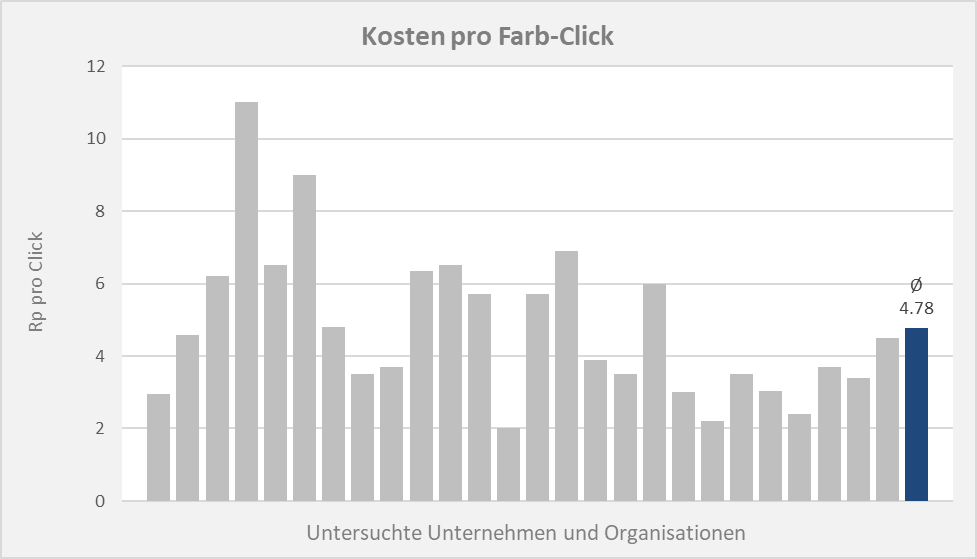

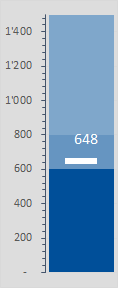

Farb-Clicks fast siebenmal teurer als schwarz-weiss Clicks

4.78 Rappen für einen Farb-Click

Die im Rahmen der durchgeführten Benchmarks erhobenen Clickpreise für Farb-Seiten schwanken zwischen 2 und 11 Rappen und damit um mehr als einen Faktor 5:

Kosten pro Farb-Click in Rappen

Im Durchschnitt kostet ein Click für eine Farb-Seite 4.78 Rappen.

Gemäss KPI of the month vom Mai 2022 werden pro Drucker gut 43 000 Seiten pro Jahr gedruckt. Falls alle Seiten farbig ausgedruckt würden (was eher unrealistisch sein dürfte), fallen damit pro Jahr Tonerkosten von CHF 2 055 an, im Gegensatz zu CHF 300, falls alle Seiten nur schwarz/weiss gedruckt werden.

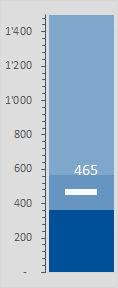

300 Franken Tonerkosten pro Jahr und Drucker

0.72 Rappen für einen schwarz/weiss Click

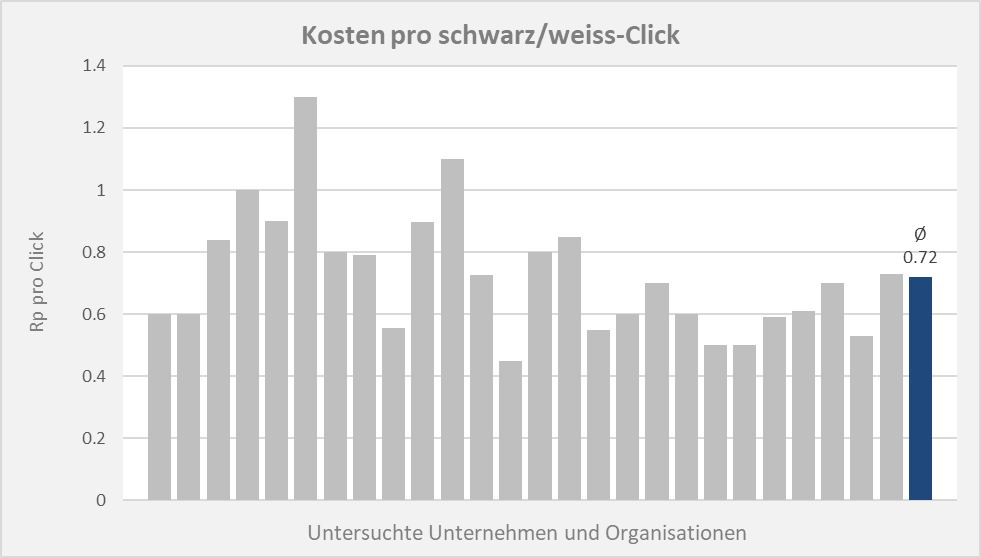

Die im Rahmen der durchgeführten Benchmarks erhobenen Clickpreise für schwarz/weiss Seiten schwanken beinahe um den Faktor drei zwischen 0.45 Rappen und 1.3 Rappen pro Seite:

Kosten pro schwarz/weiss Click in Rappen

Im Durchschnitt kosten ein Click für eine schwarz/weiss Seite 0.72 Rappen.

Wie wir im KPI of the month Mai 2022 gesehen haben, werden pro Drucker gut 43 000 Seiten pro Jahr gedruckt. Damit fallen pro Drucker im Jahr gut CHF 300 für Tonerkosten an, falls alle Seiten nur schwarz/weiss und nicht in Farbe gedruckt werden.

Farbseiten weisen einen wesentlich höheren Clickpreis auf. Dies werden wir im nächsten KPI of the month beleuchten.

Immer mehr Mail-Speicherplatz

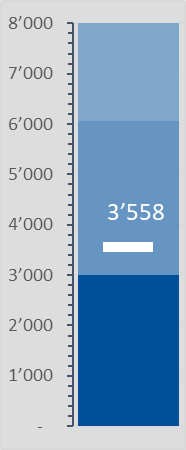

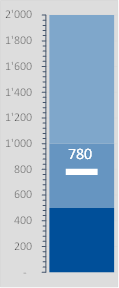

3.5 GB Mail-Speicherplatz pro Benutzer

|

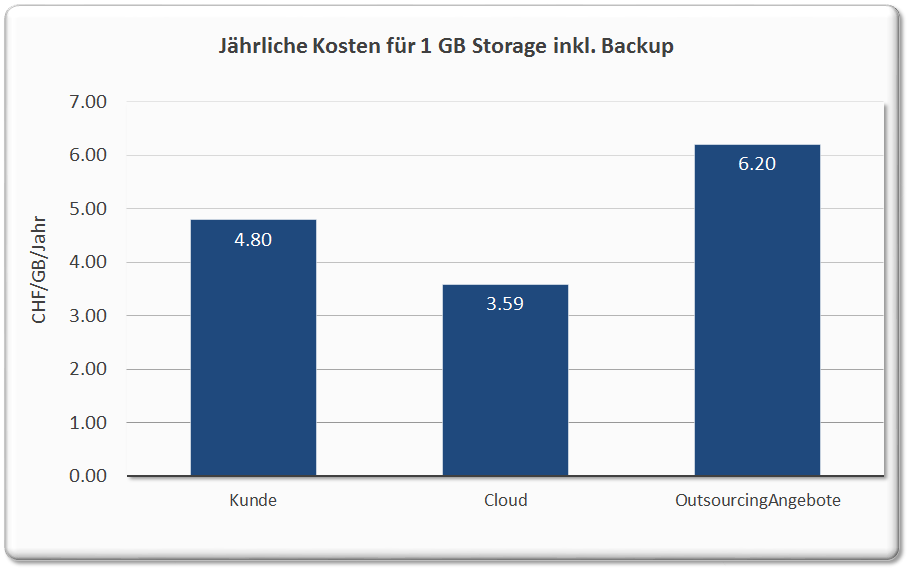

Im KPI of the month vom März 2015 haben wir geschrieben, dass jeder Benutzer im Durchschnitt 780 MB Mail-Speicherplatz benötigt. 7 Jahre später sind es gut 3.5 GB. Damit ist der belegte Speicherplatz für E-Mail in 7 Jahren um beinahe den Faktor 5 gewachsen. Verglichen mit den 50 GB Speicherplatz von Office 365 sind 3.5 GB jedoch immer noch lächerlich und es stellt sich die Frage, ob der Mailspeicher heute immer noch limitiert werden soll. Die Storage-Preise sind so stark gesunken, so dass die Kosten für den Speicherplatz kaum noch relevant sind.

PS: Auf dem Storagesystem stehen im Schnitt sogar gut 6 GB Speicherplatz für E-Mails zur Verfügung. Damit sind die vorhandenen Reserven beinahe gleich gross wie der belegte Speicherplatz. |

|

Hohes Druckvolumen

43 000 Seiten pro Drucker (MFP) im Jahr

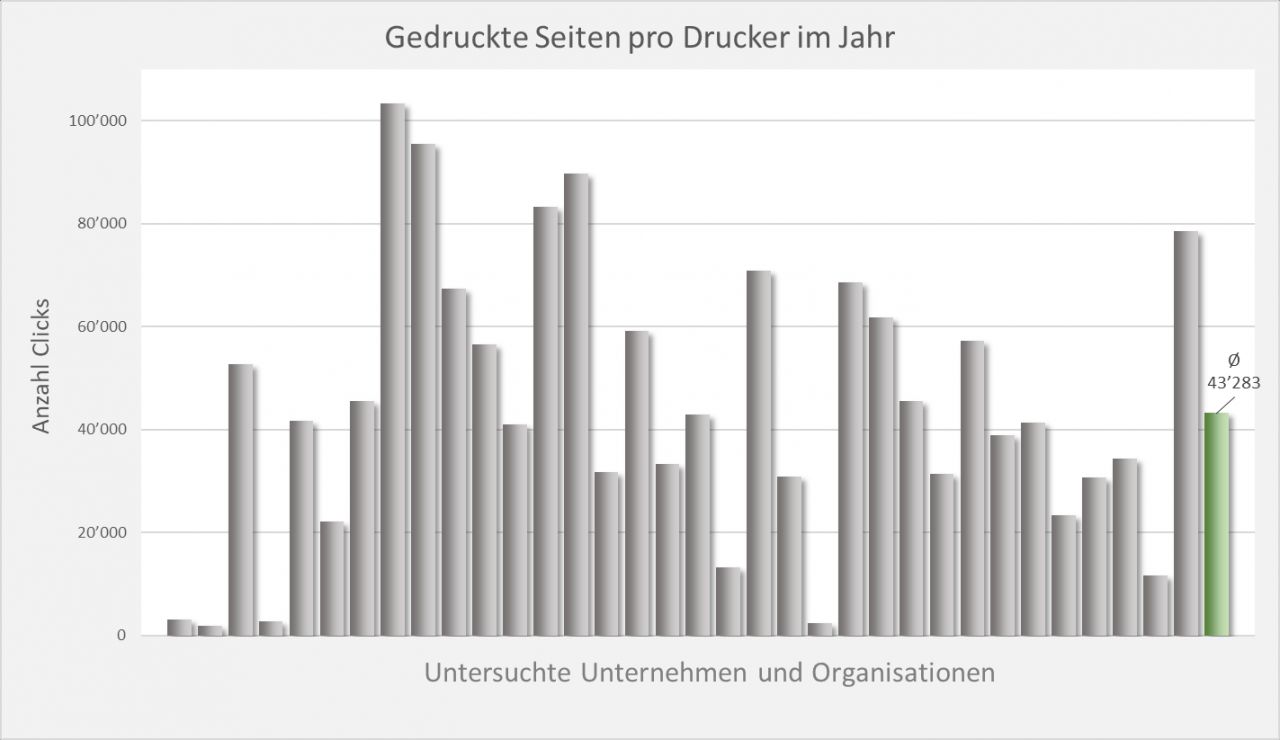

Das jährliche Druckvolumen pro MFP (Multi Funktions Printer) schwankt je nach untersuchter Organisation sehr stark:

Gedruckte Seiten pro Drucker (MFP)

Während die MFP bei einigen Organisationen kaum genutzt werden, drucken andere Einheiten gegen oder über 100 000 Seiten pro Jahr pro MFP. Das durchschnittliche Druckvolumen pro MFP beträgt dabei gut 43 000 Seiten.

Dies bedeutet, dass die meisten Organisationen ihre Drucker noch stärken auslasten könnten. Im Durchschnitt teilen sich 7.5 Benutzer einen Drucker. Rein von der Kapazität her könnten daher die Drucker noch deutlich stärker ausgelastet werden. Häufig setzt jedoch das Gebäude-Layout der Druckerkonsolidierung Grenzen: Während sich in Grossraumbüros sehr viele Personen einen Drucker teilen können, ist dies in verwinkelten und kleineren Gebäuden hingegen viel schwieriger.

Dabei stellt sich natürlich die Frage, ob überhaupt noch so viel gedruckt werden muss. Die Pandemie und die damit einhergehende Homeoffice-Pflicht oder Empfehlung haben gezeigt, dass es auch mit deutlich weniger Drucken geht.

Die IT-Infrastruktur wird häufig nicht rund um die Uhr überwacht

Unüberwachte Zeit von 43 Stunden pro Woche

Die Betriebszeiten der IT-Infrastruktur (Server, Storage, Netzwerk usw.) teilen sich wie folgt auf:

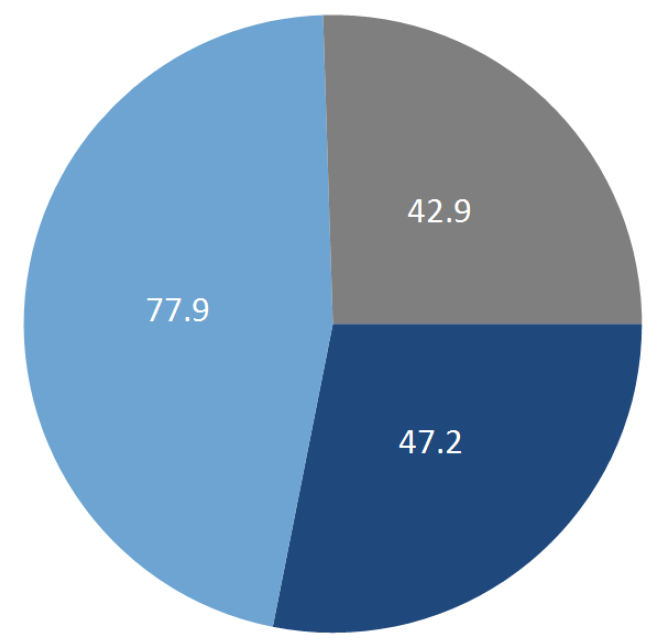

![]()

Verteilung der Betriebszeiten

Bedienter Betrieb: Im Durchschnitt wird die IT-Infrastruktur während 47.2 Stunden in der Woche überwacht. Dies entspricht knapp 9.5 Stunden pro Tag oder z.B. von 8.00 bis 17.30 Uhr. Das bedeutet, dass während der üblichen Bürozeiten auch die IT-Spezialisten vor Ort sind und bei einem Problem unmittelbar eingreifen können.

Überwachter Betrieb: Einige Unternehmen überwachen ihre IT-Infrastruktur rund um die Uhr und können ausserhalb der Betriebszeiten über eine Pikett-Organisation bei Problemen und Ausfällen reagieren. Im Schnitt sind dies pro Woche knapp 78 Stunden oder 15.5 Stunden pro Tag, falls das Wochenende nicht berücksichtigt wird. Zusammen mit den 9.5 Stunden für den bedienten Betrieb, ergibt dies 25 Stunden pro Tag… Das heisst, dass bei einigen wenigen Unternehmen die Systeme ebenfalls noch am Wochenende überwacht werden.

Unüberwachter Betrieb: Über alle gebenchmarkten Unternehmen werden die Systeme an knapp 43 Stunden pro Woche gar nicht überwacht. D.h. es findet auch keine Alarmierung statt und es steht auch keine Pikett-Organisation zur Verfügung, die bei einem Ausfall automatisch alarmiert wird.

IT-Abteilungen mit einem echten 24/7 Betrieb treffen wir bei unseren Benchmarks praktisch keine an. Dies liegt daran, dass die Firmen selbst auch keinen 24/7 Betrieb aufweisen. Teilweise werden die Systeme rund um die Uhr überwacht, damit bei einem Ausfall automatisch die Pikett-Organisation aufgeboten werden kann. Bei einem erstaunlich grossen Anteil werden die Systeme jedoch nicht überwacht und die IT-Organisation steht nur während der Bürozeiten zur Verfügung. Natürlich wird bei Problemen ausserhalb der üblichen Arbeitszeiten trotzdem versucht, die entsprechenden IT-Spezialisten aufzubieten, aber dies erfolgt dann auf gut Glück und nicht über eine systematische Überwachung der Systeme und einer entsprechenden Pikett-Organisation.

Dort, wo eine Pikett-Organisationen vorhanden ist, verfügt diese in der Regel über eine Reaktionszeit von 30 oder 60 Minuten. Im Durchschnitt beträgt sie 43 Minuten.

Lange Incident-Lösungszeiten

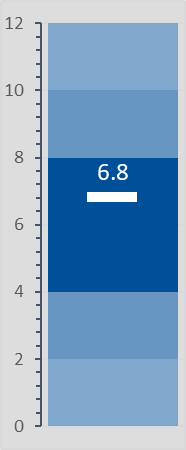

Durchschnittliche Lösungszeit: 6.8 Tage

Die durchschnittliche Zeit für die Lösung eines Incidents, der dem Service Desk gemeldet wird, beträgt 6.8 Tage:

Durchschnittliche Incident-Lösungszeit

Dies ist ein vergleichsweise hoher Wert. Vor allem, wenn bedenkt wird, dass der Service Desk rund zwei Drittel aller Incidents selbst lösen kann.

In den 6.8 Tagen ist jedoch nicht nur die Lösungszeit des Service Desks enthalten, sondern ebenfalls die Zeiten aller anderen IT-Abteilungen, die zur Lösung eines Incidents nötig sind. Lange Lösungszeiten sind daher Hinweise auf die folgenden Punkte:

1) Der Incident Management Process ist nicht implementiert resp. wird nicht gemanaged und überwacht.

2) Es fehlt ein Incident Manager, der die Incidents und deren Lösung überwacht und dort interveniert, wo die Lösung zu lange dauert oder die Incidents immer wieder an andere Stellen in der IT verschoben (oder hin und her geschoben) werden.

3) Der Problem Management Prozess fehlt und Incidents werden über Wochen und Monate offen gelassen, anstatt ein Problem zu eröffnen.

Bei praktisch jedem Review des Incident Management Prozesses sind wir auf offene Incidents gestossen, die über ein Jahr alt waren. An diesen Incidents wird in der Regel nicht mehr gearbeitet, aber sie treiben die durchschnittliche Lösungszeit nach oben.

IT-Abteilungen, die über einen funktionierenden Incident und Problem Management Prozess verfügen, die Incident-Lösungszeit messen und einen aktiven Incident Manager haben, erreichen durchschnittliche Incident-Lösungszeiten zwischen einem und zwei Tage. In Extremfällen sogar unter einem Tag.

Diese IT-Abteilungen sind in der Regel nicht teurer als IT-Abteilungen mit höheren Incident-Lösungszeiten. Eine stringente Implementation des Incident Management Prozesses kostet in der Regel nicht mehr Geld, sondern spart Geld. Man muss es nur tun.

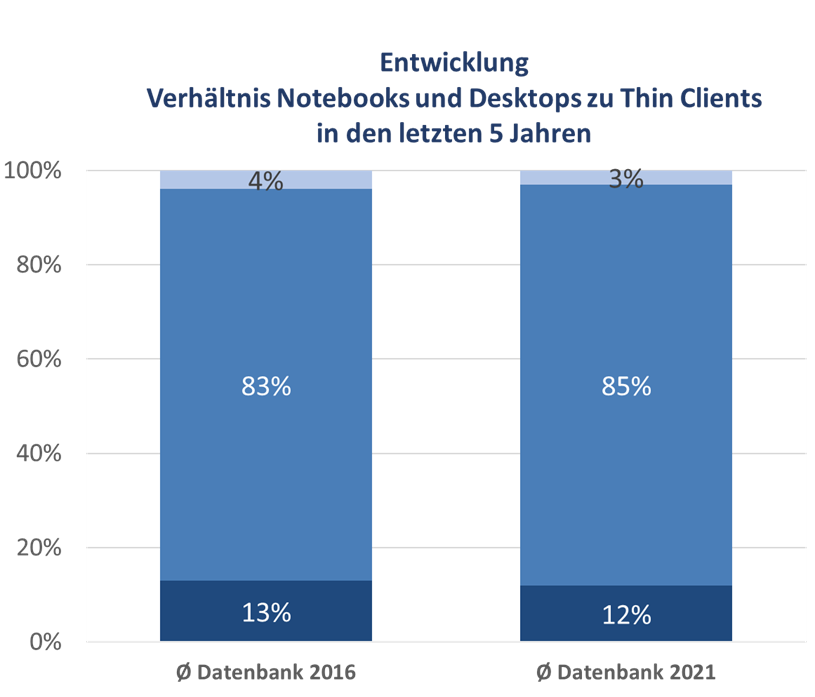

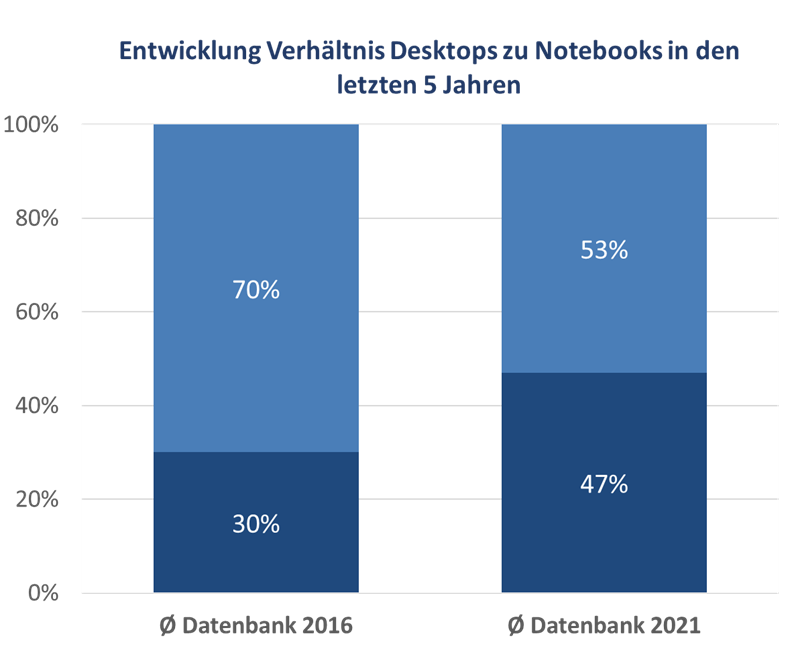

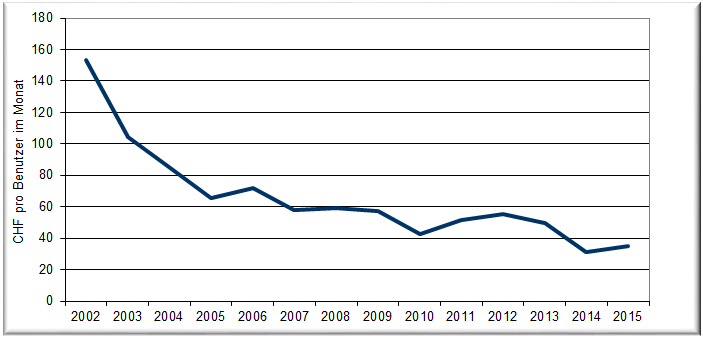

Thin-Clients stagnieren auf tiefem Niveau

12% aller Endgeräte sind Thin-Clients

Interessanterweise ist der Anteil der Thin-Clients und damit der Unternehmen, die auf Citrix oder eine entsprechende Technologie setzen, in unseren Benchmarks über die Jahre konstant geblieben:

Anteil der Thin- resp. Fat-Clients

Mit nur gerade 13% resp. 12% ist der Anteil der Thin-Clients allerdings verhältnismässig klein und zeigt, dass die meisten Unternehmen auf Fat-Clients setzen. Die 3% aufgeführten Spezialgeräte sind in der Regel ebenfalls Fat-Clients (z.B. CAD-Workstations oder Banken-Handelsarbeitsplätze).

Während die Notebooks in der Pandemie und der Homeoffice-Empfehlung resp. -Pflicht grosse Vorteile gegenüber den Desktops aufweisen, haben die Thin-Clients in dieser Situation ebenfalls entsprechende Vorteile: Die Thin-Clients werden zwar in der Regel nicht nach Hause genommen, aber dafür kann mit dem Citrix Receiver resp. der Citrix Workspace App vom privaten PC auf die Firmenumgebung zugegriffen werden, so dass kein Firme-Gerät mit nach Hause genommen werden muss.

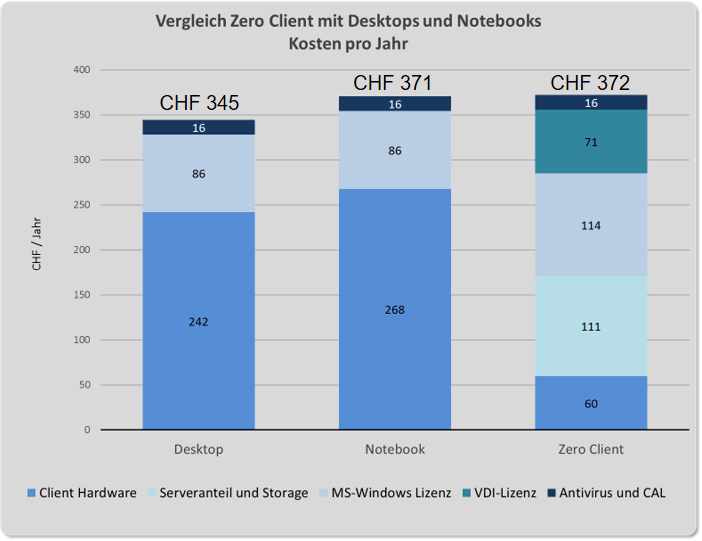

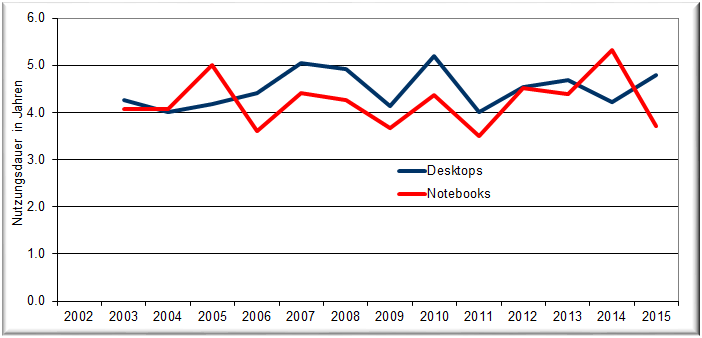

Im Durchschnitt kostet ein Thin-Client CHF 85 pro Jahr während ein Desktop CHF 176 und Notebooks CHF 293 pro Jahr kosten. Ein Teil geht auf die tieferen Beschaffungskosten der Thin-Clients zurück und der andere Teil auf die mit sechs Jahren um rund ein Jahr längere Nutzungsdauer als bei Desktops. Dazu kommen geringere Onsite Supportkosten für Thin-Clients, so dass auf der Seite der Endgeräte deutlich tiefere Kosten anfallen.

Diese Kostenvorteile werden in der Regel jedoch auf der Server-Seite (teilweise mehr als) kompensiert durch die aufwändige Server-Infrastruktur und die Virtualisierungs-Lizenzen.

Abgesehen von den Kosten gibt es jedoch noch zwei weitere Aspekte zu betrachten:

- Die meisten Virtualisierungslösungen haben Probleme mit Videokonferenzen

- Mit Office 365 und weiteren Cloud resp. SaaS-Lösungen werden die Clients immer mehr direkt mit dem Internet verbunden und nicht mehr über das eigene Rechenzentrum mit der Virtualisierungslösung

Mit dem Trend zu mehr mobilen Geräten dürfte die Anzahl der Thin-Clients wohl zurück gehen. In unseren aktuellen Benchmark-Zahlen ist noch kaum etwas davon erkennbar, aber die Diskussionen in den Firmen drehen sich eher um einen Wechsel zu Notebooks wie um einen Ausbau der Thin-Clients. Und mit der immer weiter fortschreitenden Verbreitung von Office 365 und dem Bezug von Services aus der Cloud (O365 oder auch SaaS-Lösungen) machen Thin-Clients immer weniger Sinn.

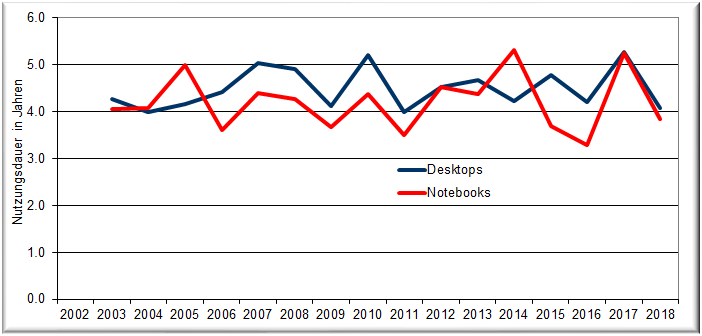

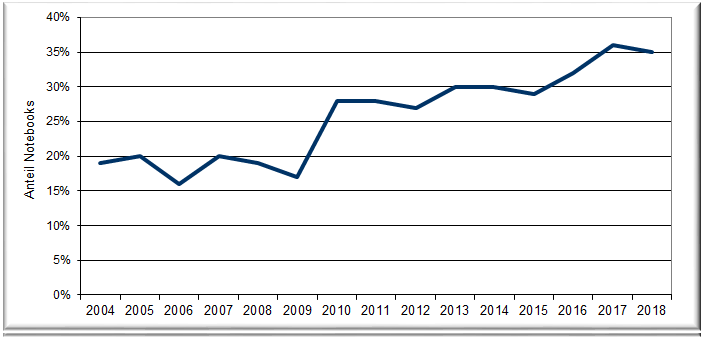

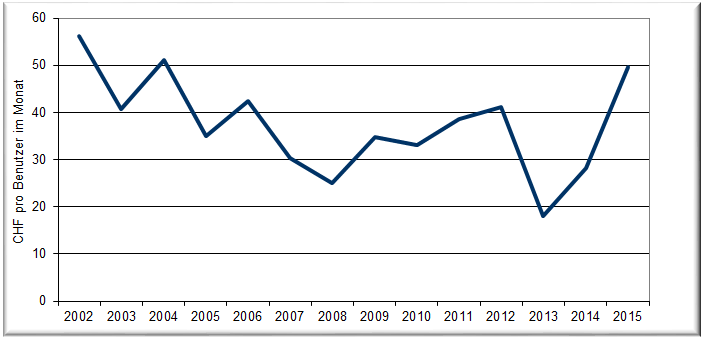

Klarer Trend zu Notebooks

47% aller Endgeräte sind Notebooks

Die Notebooks verdrängen die Desktops immer mehr. Bis 2009 ist der Anteil der Notebooks in unseren Benchmarks unter 20% gelegen. Bis 2016 wurde der Anteil auf 30% gesteigert, um im letzten Jahr (2021) knapp 50% zu erreichen:

Anteil der Desktops resp. Notebooks

Dabei ist zu beachten, dass bei der Erhebung der Benchmark-Werte alle aktuell vorhandenen Endgeräte erfasst werden. Also auch solche, die bereits vor vier Jahren beschafft wurden und bei einem Wechsel auf eine Notebook-Strategie erst nach und nach durch mobile Geräte abgelöst werden. Zudem enthalten unsere Durchschnittswerte üblicherweise die Benchmarks der letzten vier Jahre. Würden alle Werte heute erhoben, dürften die Notebooks die Desktops bereits überholt haben.

Die Pandemie mit der starken Förderung von Homeoffice hat sicherlich einen wichtigen Beitrag zur Steigerung der Notebook-Dichte geleistet. Aber auch sonst ist bei immer mehr Unternehmen eine Notebook-Only-Strategie zu beobachten.

Die Notebooks sind mit durchschnittlich CHF 1 345 in der Beschaffung teurer als Desktops mit durchschnittlich CHF 878. Dazu kommt mit 4.59 Jahren versus 5.0 Jahren eine leicht kürzere Nutzungszeit. Daraus resultieren jährliche Kosten von CHF 293 für Notebooks versus CHF 176 für Desktops. D.h. Notebooks kosten pro Jahr 66% mehr als Desktops.

Beim Desktop kommt noch (mindestens) ein Monitor dazu. Dieser kostet durchschnittlich CHF 245 in der Beschaffung und wird im Schnitt 6 Jahre eingesetzt. Das macht CHF 41 pro Jahr bei einem resp. CHF 82 pro Jahr mit zwei Bildschirmen. Häufig kommt bei den Notebooks jedoch auch ein (oder teilweise auch zwei) Monitore und noch eine Dockingstation dazu, so dass die Preisdifferenz zum Desktop erhalten bleibt oder durch die Dockingstation sogar noch leicht anwächst.

Kostenmässig scheint sich eine reine Notebook-Strategie nicht zu lohnen. Sobald man jedoch nicht nur die reinen Beschaffungs- resp. Abschreibungskosten betrachtet, kann der Verzicht auf Desktops jedoch durchaus Vorteile bringen:

- Das Notebook kann überall mitgenommen werden. Auch ins Homeoffice.

- Notebooks erlauben eine andere Support-Strategie, indem die IT nicht mehr zum Benutzer, sondern der Benutzer (resp. das Notebook) zur IT kommt.

- Das Gleiche gilt für die Auslieferung: Notebooks können per Post direkt an den entsprechenden User geschickt werden ohne dass IT-Leute dazu notwendig sind.

- Bei einem Umzug ist die IT nicht oder nur noch reduziert nötig, indem die Notebooks einfach im neuen Büro eingesetzt werden.

Ob sich eine reine Notebook-Strategie lohnt, muss jedes Unternehmen für sich entscheiden. Vor allem dann, wenn rein stationäre Arbeitsplätze gar nicht von Notebooks profitieren können. Unsere Benchmarkzahlen zeigen jedoch klar, dass die Notebooks die Desktops bald überholt haben werden.

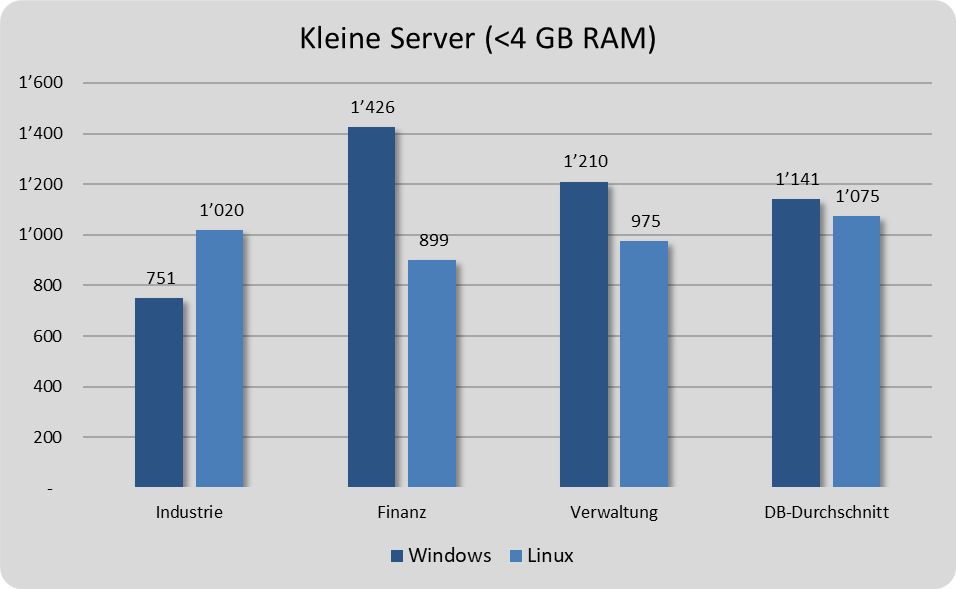

Teure Linux-Server in der Industrie wegen SAP

Kosten pro virtuelle Server nach Branche

Virtuelle Server gibt es in den verschiedensten Ausprägungen. Primär sind die Kosten von der Anzahl der virtuellen CPU sowie vom virtuellen RAM abhängig. Da die Grösse des zur Verfügung stehenden Memories der grössere Kostentreiber ist, haben wir die folgenden Kategorien gebildet:

• VM Klein (bis 4 GB RAM)

• VM Mittel (4-16 GB RAM)

• VM Gross (>16 GB RAM)

Bei den kleinen Servern bis 4 GB RAM fallen die sehr tiefen Kosten der Industrie sowie die sehr hohen Kosten der Finanzdienstleister für die Windows-Server auf. Die Verwaltungen bewegen sich nahe am Datenbank-Durchschnitt (DB-Durchschnitt):

Kosten der virtuellen Server (VM) mit weniger als 4 GB pro Jahr in Schweizer Franken

Die Kosten für die Linux-Server sind wesentlich ausgeglichener und schwanken nur geringfügig unter den verschiedenen Branchen. Während die Linux-Server bei den Finanzdienstleistern und den Verwaltungen teilweise deutlich unter den Kosten der Windows-Server liegen, besteht im Datenbank-Durchschnitt kaum ein Unterschied zwischen den Windows- und Linux-Servern.

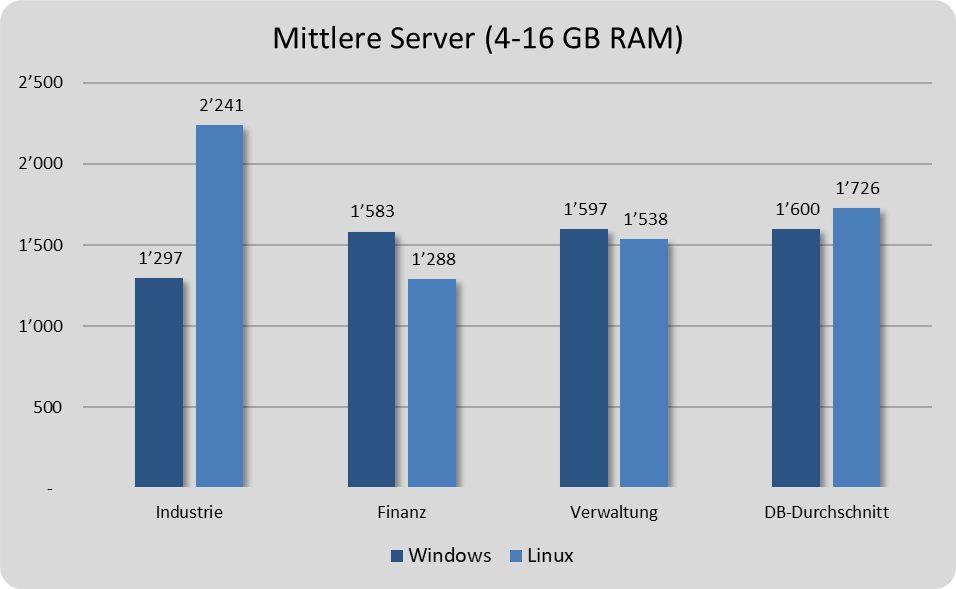

Bei den mittleren Servern (4-16 GB RAM) fallen die vergleichsweise teuren Linux-Server der Industrie-Unternehmen auf. Dies dürfte daran liegen, dass in der Industrie SAP in der Regel auf Linux-Servern betrieben wird und hier in der Kategorie der mittleren Server die VM eher mit 16 GB und weniger mit 4 GB ausgestattet sind:

Kosten der virtuellen Server (VM) mit 4 - 16 GB pro Jahr in Schweizer Franken

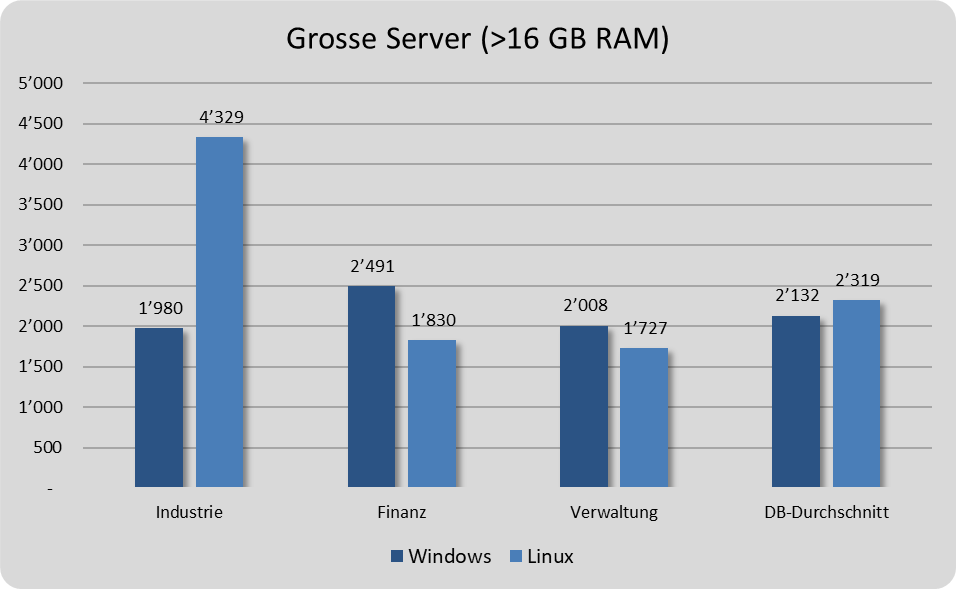

Dieser Effekt fällt bei den grossen Linux-Servern noch stärker ins Gewicht. Bei SAP-Installationen kommen teilweise Linux-Server mit mehreren Duzend (oder sogar mehreren Hundert) GB RAM zum Einsatz. Bei den anderen Branchen liegt die Speicherausstattung eher bei 16 oder 32 GB RAM.

Kosten der virtuellen Server (VM) mit mehr als 16 GB pro Jahr in Schweizer Franken

Abgesehen von diesem Effekt, bestehen kaum Unterschieden bei den Kosten zwischen den Windows- und Linux-Servern.

Die Einteilung der Server in die Kategorien klein / mittel / gross hilft, die Kosten vergleichbar zu machen. Wie das Beispiel SAP der Industrie-Unternehmen zeigt, ergeben sich daraus jedoch auch gewisse Unschärfen. Daher ist das Cloud-Angebot der grossen Cloud-Anbieter so umfangreich und deckt beinahe jede Facette und Ausprägung von virtuellen Servern ab.

Windows-Server sind nicht teurer als Linux-Server

Kosten pro virtuelle Server

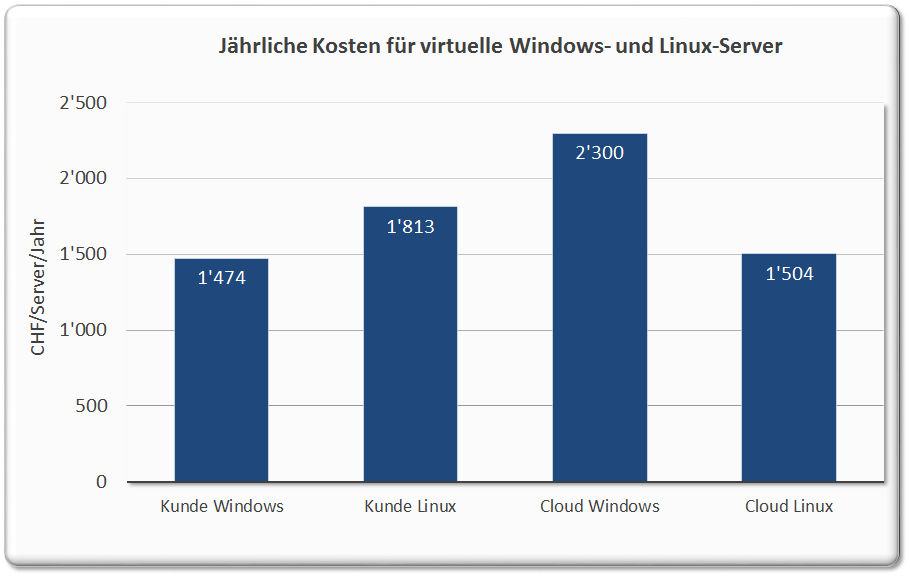

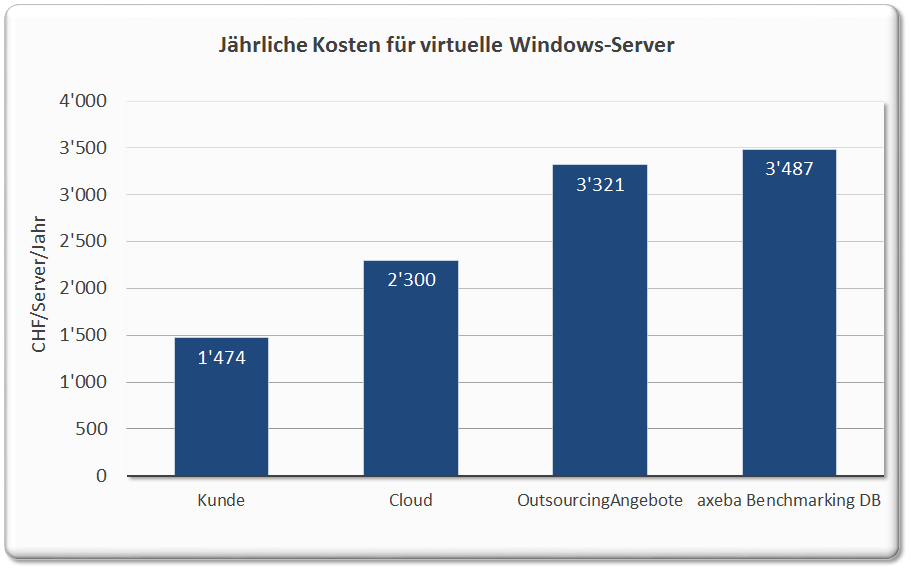

Die Kosten für virtuelle Server sind in den letzten Jahren laufend gesunken. Unsere Benchmarks von beinahe 100 Firmen und öffentlichen Verwaltungen mit insgesamt einigen Zehntausend virtuellen Servern zeigen folgendes Bild:

Kosten der virtuellen Server (VM) pro Jahr in Schweizer Franken

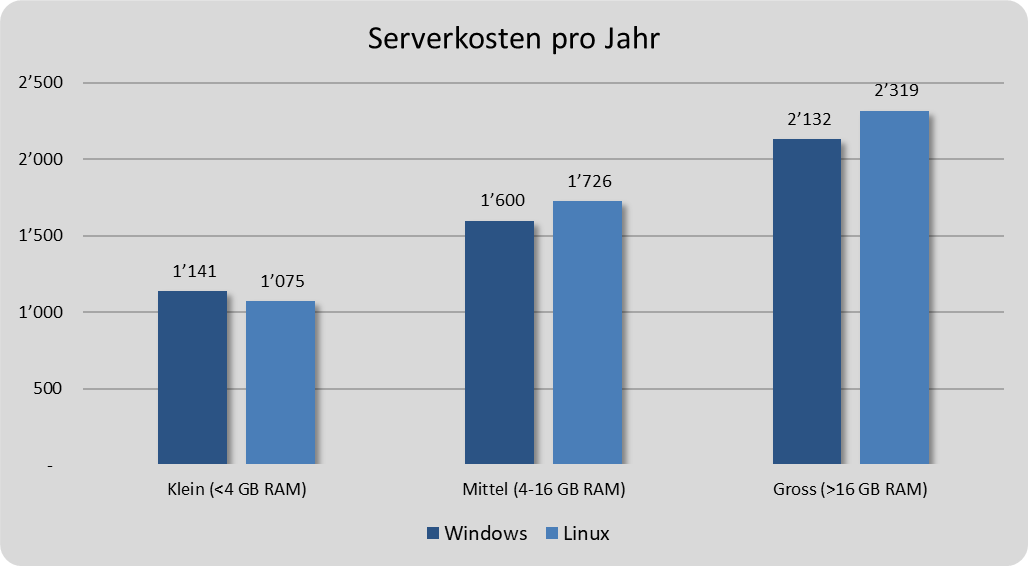

Da die Grösse des zur Verfügung stehenden Memories ein signifikanter Kostentreiber ist, haben wir die folgenden Kategorien gebildet:

• VM Klein (bis 4 GB RAM)

• VM Mittel (4-16 GB RAM)

• VM Gross (>16 GB RAM)

Dabei fällt auf, dass die Windows-Server Mittel und Gross leicht günstiger sind als die Linux-Server. Die Unterschiede sind allerdings gering und dürften darauf zurückzuführen sein, dass die IT in der Regel mehr Windows- als Linux-Server betreibt. Bei den kleinen Servern (bis 4 GB RAM) sind die Linux-Server leicht günstiger.

Werden die Kosten pro Monat anstatt pro Jahr betrachtet, kostet ein kleiner Server unter CHF 100 und ein grosser Server nur gerade knapp CHF 200 pro Monat. Dies ist in der Regel günstiger als die Outsourcing-Angebote und häufig auch günstiger als Server aus der Cloud. Outsourcing und Cloud haben jedoch andere Vorteile.

Die folgenden Aufwände sind in den obigen Kosten enthalten:

• Hardware der Hosts (Abschreibungen und HW-Wartung)

• Alle benötigen Lizenzen inkl. Wartung und Supportverträgen

• Interne und externe Personalkosten für das Engineering, Aufsetzen, Betrieb, Administrieren, Überwachen usw.

Nicht darin enthalten sind die folgenden Kosten:

• Datacenter (Raum, Klima, Strom)

• Datacenter Netzwerk

• Firewalls, Proxy usw.

• Storagesystem (SAN, NAS usw.) und Backup

• Sämtliche Kosten für die auf den Server betriebenen Applikationen

Bei einem Vergleich mit Angeboten von Outsourcing- oder Cloud-Providern müssen diese Kosten natürlich ebenfalls berücksichtig werden. Insgesamt dürften diese rund 20% ausmachen (natürlich ohne die Kosten für Storage und Backup sowie für den Betrieb der auf den Server laufenden Applikationen).

Aus Kostengründen lohnt es sich in der Regel nicht, die Server in eine Cloud oder zu einem Outsourcing-Anbieter auszulagern. Mit der immer stärkeren Verbreitung von Office 365 (M365) und SaaS-Lösungen werden faktisch jedoch immer mehr Server aus der Cloud bezogen und immer weniger selbst betrieben.

Performance und Verfügbarkeit sind Schlüsselfaktoren

Korrelation der Parameter bei der Leistungsfähigkeit und Zuverlässigkeit

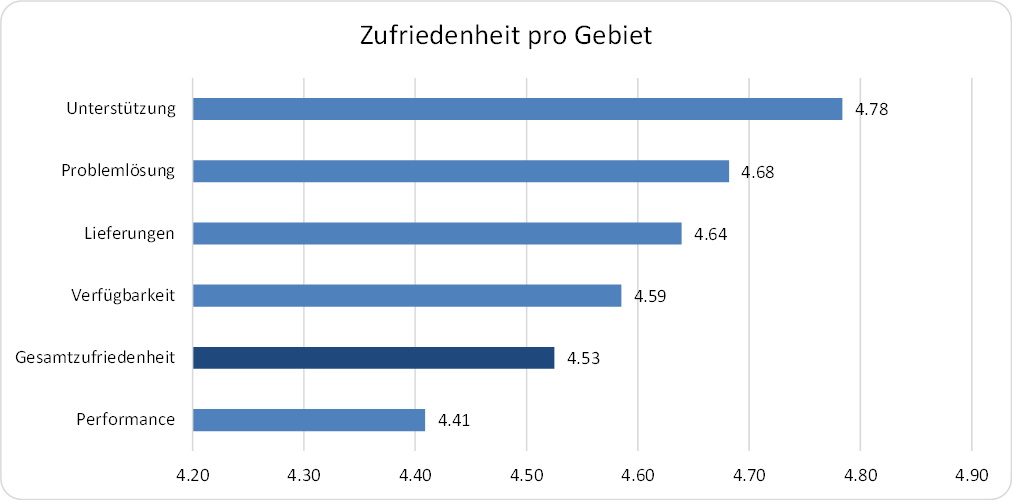

Bei der Befragung zur Leistungsfähigkeit und Zuverlässigkeit (Performance und Verfügbarkeit) der IT-Infrastruktur werden die verschiedenen Gebiete wie folgt beurteilt:

Zufriedenheit der einzelnen Gebiete bei der Leistungsfähigkeit und Zuverlässigkeit

Dabei lauten die Fragestellungen wie folgt:

Unterstützung: Wie gut werden Sie im Arbeitsprozess durch die PC-Infrastruktur unterstützt?

Problemlösung: Werden gemeldete Probleme in einer für Sie nützlichen Frist behoben?

Lieferungen: Wie beurteilen Sie den Ablauf, die Lieferung und Installation von Informatikmitteln?

Verfügbarkeit: Wie beurteilen Sie die Zuverlässigkeit der Informatik-Infrastruktur?

Performance: Wie beurteilen Sie die Leistungsfähigkeit der Informatik-Infrastruktur?

Gesamtzufriedenheit: Wie beurteilen Sie insgesamt die Leistungsfähigkeit und die Zuverlässigkeit der von Ihnengenutzten Informatikmittel?

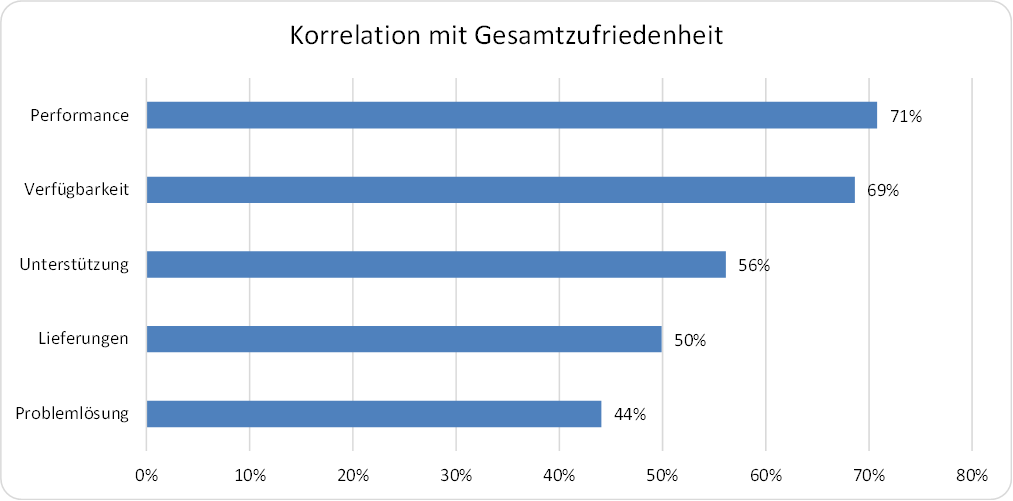

Wie wir bereits beim Service Desk und Onsite Support gesehen haben, weisen die Gebiete, die am stärksten mit der Gesamtzufriedenheit korrelieren, beinahe die umgekehrte Reihenfolge auf.

Korrelation der einzelnen Gebiete mit der Gesamtzufriedenheit der Leistungsfähigkeit und Zuverlässigkeit

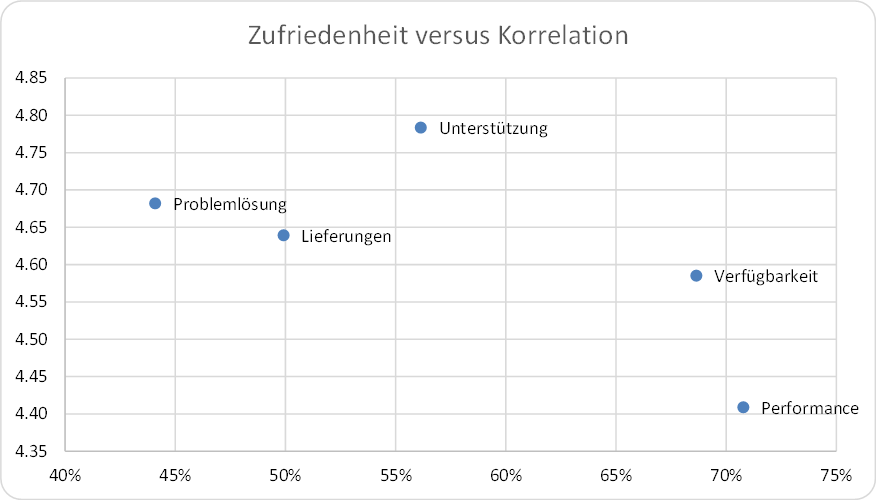

Wird die Zufriedenheit auf der Y-Achse und die Korrelation auf der X-Achse aufgetragen, wird das Bild deutlicher:

Zufriedenheit der einzelnen Gebiete versus Korrelation mit Gesamtzufriedenheit bei der Leistungsfähigkeit und Zuverlässigkeit

Performance und Verfügbarkeit sind die Gebiete mit der schlechtesten Beurteilung und weisen gleichzeitig die grösste Korrelation mit der Gesamtzufriedenheit auf. Das heisst, dass es sich am meisten lohnt, die Performance und Verfügbarkeit zu verbessern, um die Zufriedenheit bezüglich Leistungsfähigkeit und Zuverlässigkeit zu steigern.

Die Bereiche Problemlösung, Lieferungen und Unterstützung im Arbeitsprozess durch die PC-Infrastruktur werden besser beurteilt, weisen aber eine geringere Korrelation mit der Gesamtzufriedenheit auf, so dass sich Verbesserungen in diesen Gebieten weniger auswirken.

Damit muss die PC-Infrastruktur vor allem schnell und stabil sein, um zufriedene Benutzer zu haben.

Effizienz (Reaktionszeit, Lösungsgeschwindigkeit) ist der wichtigste Parameter im Onsite Support

Korrelation der Parameter im Onsite Support

Im Onsite Support werden die Erreichbarkeit sowie die Freundlichkeit mit Abstand am besten beurteilt:

Zufriedenheit der einzelnen Gebiete im Onsite Support

Interessanterweise korrelieren diese beiden Gebiete am wenigsten mit der Gesamtzufriedenheit mit dem Onsite Support:

Korrelation der einzelnen Gebiete mit der Gesamtzufriedenheit im Onsite Support

Auffallend ist, dass die Reihenfolge bei der Korrelation genau umgekehrt ist wie bei der Zufriedenheit. Dies wird nochmals deutlicher, wenn man die beiden Parameter auf je einer Achse darstellt:

Zufriedenheit der einzelnen Gebiete versus Korrelation mit Gesamtzufriedenheit im Onsite Support

Die Erreichbarkeit erreicht zwar die beste Beurteilung, weist allerdings auch die geringste Korrelation mit der Gesamtzufriedenheit im Onsite Support auf. Auf der anderen Seite wird die Effizienz (Reaktionszeit, Lösungsgeschwindigkeit) am schlechtesten beurteilt, weist dafür aber die grösste Korrelation auf.

Das heisst, dass es sich am meisten lohnt, die Effizienz (Reaktionszeit, Lösungsgeschwindigkeit) zu verbessern, um die Zufriedenheit im Onsite Support zu steigern.

Die Fachkompetenz sowie die Freundlichkeit weisen praktisch die gleiche Korrelation mit der Gesamtzufriedenheit auf. Da die Fachkompetenz jedoch schlechter beurteilt wird wie die Freundlichkeit, lohnt es sich mehr, in die Fachkompetenz zu investieren als die Freundlichkeit noch weiter zu steigern.

Die Erreichbarkeit des Onsite Supports weist hingegen bereits eine sehr hohe Zufriedenheit, aber die geringste Korrelation auf, so dass hier eine weitere Steigerung kaum noch etwas bringt.

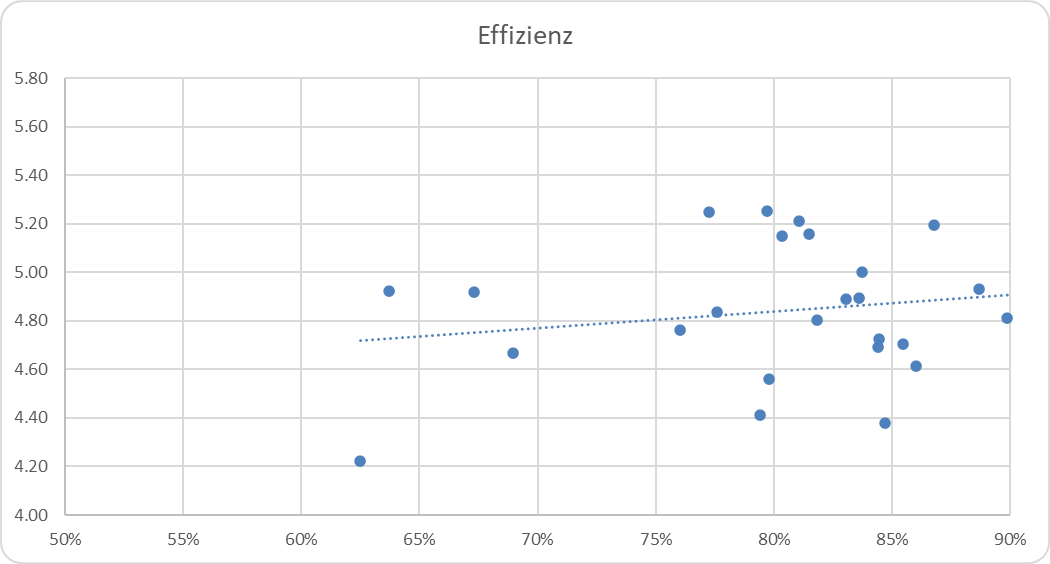

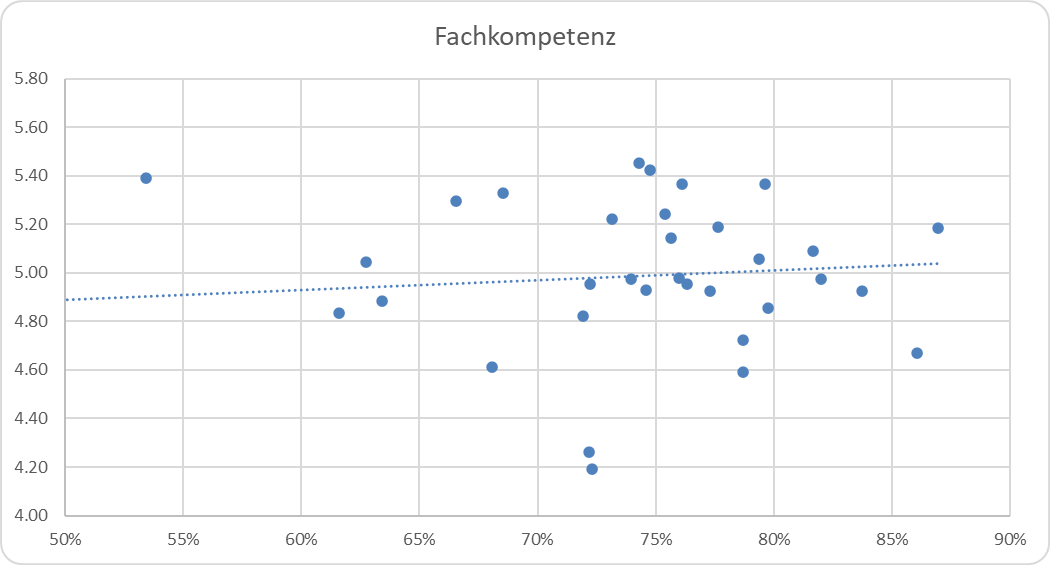

Übrigens: Bei der Analyse des Service Desks haben wir gesehen, dass die Zufriedenheit mit einem spezifischen Gebiet (z.B. Effizienz) negativ korreliert mit der Korrelation des Gebietes mit der Gesamtzufriedenheit. D.h. je schlechter ein Gebiet beurteilt wird, desto höher ist deren Abhängigkeit (Korrelation) von der Gesamtzufriedenheit.

Während sich im Onsite Support die Gebiete Erreichbarkeit und Freundlichkeit analog verhalten wie im Service Desk, verhalten sich die Fachkompetenz und Effizienz gerade umgekehrt. Das heisst, je zufriedener die Anwender mit diesen Gebieten sind, desto grösser ist die Korrelation mit der Gesamtzufriedenheit:

Effizienz: Zufriedenheit mit Effizienz (Y-Achse) versus Korrelation mit Gesamtzufriedenheit (X-Achse)

Bei der Effizienz beträgt die Korrelation allerdings nur gerade +0.2 (resp. 20%) und bei der Fachkompetenz noch geringere +0.16 (16%):

Fachkompetenz: Zufriedenheit mit Störungsaufnahme (Y-Achse) versus Korrelation mit Gesamtzufriedenheit (X-Achse)

Störungsaufnahme und Lösungs-Effizienz sind die wichtigsten Parameter im Service Desk

Korrelation der Parameter im Service Desk

Im letzten KPI of the month haben wir gesehen, dass im Service Desk die am besten beurteilen Gebiete Freundlichkeit und Erreichbarkeit eine geringere Korrelation mit der Gesamtzufriedenheit mit dem Service Desk aufweisen wie die beiden schlechter beurteilten Gebiete Störungsaufnahme und Effizienz:

Zufriedenheit der einzelnen Gebiete versus Korrelation mit Gesamtzufriedenheit im Service Desk

Das heisst, dass es sich am meisten lohnt, die Effizienz (Reaktionszeit, Lösungsgeschwindigkeit) sowie die Störungsaufnahme (Problem aufnehmen/verstehen, Statusmeldungen) zu verbessern, um die Gesamtzufriedenheit mit dem Service Desk zu steigern. Die Fachkompetenz trägt ebenfalls stark zu Gesamtzufriedenheit bei, wird aber bereits gut beurteilt. D.h. dass hier eine weitere Steigerung (auf bereits hohem Niveau) schwierig sein dürfte.